Souvent perçu comme du shadow IT par les DSI et RSSI, ChatGPT d’OpenAI adopte une série de fonctionnalités pour apporter plus de sécurité et de contrôle des coûts. Ces ajouts pourraient intensifier la concurrence entre les acteurs de l'IA en entreprise. « Nous renforçons notre soutien aux entreprises avec des fonctionnalités utiles autant pour les grandes entreprises que pour les développeurs qui évoluent rapidement sur notre plateforme », a déclaré la start-up. Parmi les principales mises à jour, on peut citer l'introduction de Private Link, une fonction de communication directe entre l'infrastructure cloud d'un client comme Microsoft Azure, et OpenAI, tout en minimisant son exposition à Internet, de façon à réduire les risques de fuite de données.

MFA et supervision des projets individuels

Autre élément de sécurité supplémentaire, OpenAI propose désormais l'authentification multifactorielle (MFA) pour les comptes utilisateurs en entreprise. « Ces apports complètent les fonctions de sécurité d'entreprise existantes, comme la certification SOC 2 Type II, le SSO, le cryptage des données au repos avec le chiffrement AES-256 et en transit avec le protocole TLS 1.2, et les contrôles d'accès basés sur les rôles », a indiqué OpenAI dans son annonce. « Nous proposons également des accords de partenariat aux entreprises du secteur de la santé qui doivent se conformer à la loi américaine HIPAA (Health Insurance Portability and Accountability Act), ainsi qu'une politique de conservation des données nulle pour les clients de l'API avec un cas d’usage qualifié », a ajouté le fournisseur.

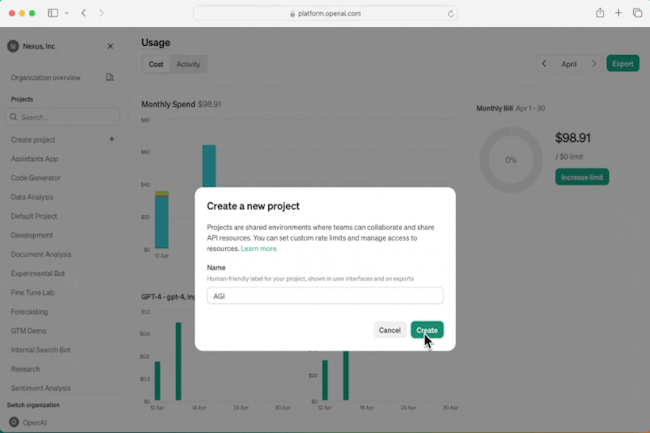

Une autre fonctionnalité appelée « Projects » promet aux entreprises une plus grande capacité de supervision et un meilleur contrôle sur les projets individuels. « Elles pourront par exemple attribuer des rôles et des clés API à des projets spécifiques, restreindre/autoriser les modèles à mettre à disposition et fixer des limites d'utilisation et de taux d'accès et éviter les dépassements inattendus. Les propriétaires de projets pourront aussi créer des clés API de compte de service qui donnent accès aux projets sans être liés à un utilisateur individuel », a aussi expliqué l'entreprise.

Des réductions tarifaires sur certains services

OpenAI veut aussi aider les sociétés à gérer autrement leurs dépenses tout en augmentant leur utilisation de l'IA. Elle propose des options d'utilisation à prix réduit (jusqu'à 50 %) pour le débit provisionné et des coûts réduits pour les charges de travail asynchrones. « Les clients ayant un niveau soutenu d'utilisation de jetons par minute (TPM) sur GPT-4 ou GPT-4 Turbo peuvent demander l'accès à un débit provisionné pour obtenir des réductions pouvant aller de 10 % à 50 % en fonction de l'importance de l'engagement », glisse OpenAI.

De même, la société a introduit une API Batch à moitié prix spécifiquement pour les tâches non urgentes. « Cette API est idéale pour des cas d’usage tels que l'évaluation de modèles, la classification hors ligne, le résumé et la génération de données synthétiques », a déclaré l'entreprise. Les développeurs qui travaillent avec l'API Assistant d'OpenAI bénéficieront également de plusieurs améliorations. C’est le cas notamment de la recherche avec « file_search », qui peut ingérer jusqu'à 10 000 fichiers par assistant, alors que la limite précédente était de 20 fichiers. « L'outil est plus rapide, prend en charge les requêtes parallèles grâce à des recherches multithread, et a amélioré le reclassement et la réécriture des requêtes », conclut OpenAI.

Commentaire