La Chine, la Russie, l’Iran et Israël ont été pointés du doigt par OpenAI pour s’être servis de son outil de GenAI pour mener des campagnes de désinformation. La start-up précise qu’elle a réussi à détecter 5 opérations de ce type au cours des trois derniers mois. « Ces acteurs ont utilisé les outils d'IA d'OpenAI pour créer et publier du contenu de propagande sur diverses questions géopolitiques et socio-économiques sur les plateformes de réseaux sociaux », souligne la société dans son rapport. Elle relativise néanmoins en observant qu’en mai 2024, ces campagnes ne semblaient pas avoir « augmenté de manière significative l’engagement ou la portée de leur audience grâce à nos services ».

Une vague de campagnes actives

Parmi les campagnes détectées, il y a celle d’origine russe baptisée « Bad Grammar ». Elle a ciblé l'Ukraine, la Moldavie, les États baltes et les États-Unis, afin de créer des commentaires politiques et du code de débogage pour les robots Telegram à l'aide des outils d'IA d'OpenAI. Une autre opération russe baptisée « Doppelganger », a généré des commentaires en plusieurs langues, traduisant des articles, et les a publiés sur des plateformes comme Facebook, 9GAG et X. « Un réseau chinois connu sous le nom de Spamouflage, s’est servi de nos modèles pour effectuer des recherches sur l'activité des réseaux sociaux publics, générer des textes dans plusieurs langues dont le chinois, l'anglais, le japonais et le coréen, les publier ensuite sur des plateformes comme X, Medium et Blogspot, et déboguer du code pour gérer des bases de données et des sites Web, y compris un domaine précédemment non signalé, revealscum[.]com », indique le rapport.

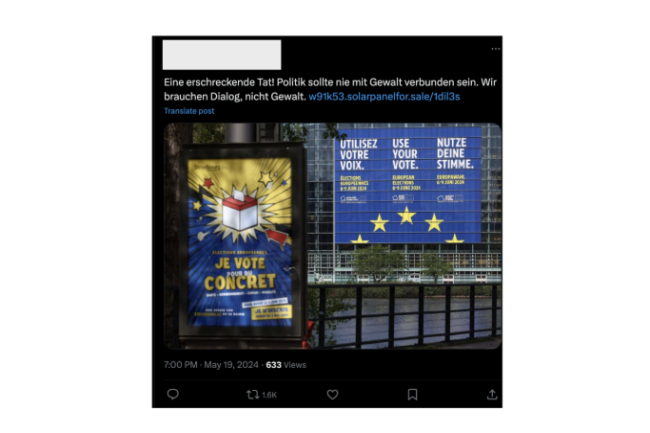

De même, une opération iranienne connue sous le nom de « The International Union of Virtual Media » (IUVM) a rédigé via l’IA des articles longs et des titres à publier sur le site ivumpress.co. Par ailleurs, une entreprise israélienne STOIC a lancé une opération baptisée « Zero Zeno » qui a généré avec l’IA des articles et des commentaires publiés sur plusieurs plateformes, notamment Instagram, Facebook, X et leurs propres sites web. « Le contenu posté par ces différentes opérations portait sur un large éventail de sujets, notamment l'invasion de l'Ukraine par la Russie, le conflit à Gaza, les élections indiennes, la politique en Europe et aux États-Unis, et les critiques du gouvernement chinois par des dissidents chinois et des gouvernements étrangers », poursuit le rapport d'OpenAI. Premier du genre réalisé par l'entreprise, il met en évidence plusieurs tendances parmi ces opérations. Les mauvais acteurs se sont appuyés sur des outils d'IA comme ChatGPT pour générer de grands volumes de contenu avec moins d'erreurs de langage, créer l'illusion d'un engagement sur les réseaux sociaux et améliorer la productivité en résumant les messages et en déboguant le code. Cependant, le rapport ajoute qu'aucune des opérations n'a réussi à « mobiliser de vraies audiences de manière significative ».

L’IA de Meta aussi utilisée

Un rapport similaire publié dernièrement par Facebook faisait déjà état de l'utilisation abusive croissante des outils d'IA par ces « opérations d'influence » à visées malveillantes. L'entreprise les appelle CIB (Coordinated Inauthentic Behavior) et les définit comme des « efforts coordonnés pour manipuler le débat public dans un but stratégique, dans lesquels les faux comptes sont au cœur de l'opération ». À chaque fois, les personnes se coordonnent et utilisent de faux comptes pour tromper les autres sur leur identité et leurs activités. Dans son rapport trimestriel sur les menaces, Meta indique qu'elle a récemment mis fin à de nombreuses opérations de ce type qui utilisaient l'IA pour générer des images, des vidéos et du texte afin de mettre en œuvre leur programme. On peut également souligner la campagne Portal Kombat découverte récemment par Viginum.

Après avoir perturbé les opérations d'influence, OpenAI a utilisé comme mesures défensives des outils d'IA pour améliorer la détection et l'analyse, rendant ainsi les enquêtes plus efficaces. Toujours selon ce rapport, l'entreprise a également imposé des mesures de sécurité qui ont souvent empêché la création de contenus malveillants. « OpenAI publie ces résultats, comme le font d'autres entreprises IT, afin de promouvoir le partage d'informations et les meilleures pratiques au sein de la communauté élargie des parties prenantes ».

Commentaire