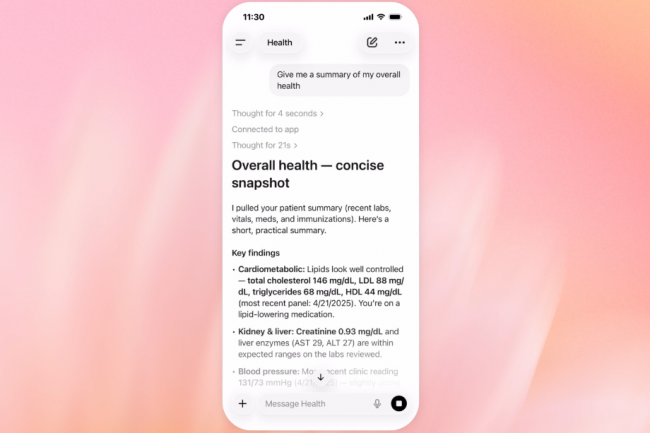

230 millions. Tel est le nombre de personnes, selon OpenAI, qui posent chaque semaine des questions liées à la santé et au bien-être sur ChatGPT. Fort de ce constat, le géant de la GenAI a annonçé ChatGPT Santé, un dérivé de l’assistant IA orienté santé accessible depuis son menu latéral. Pour l’instant ce service - disponible uniquement aux Etats-Unis et dont les inscriptions sont liste d’attente - promet d’aider les utilisateurs « à répondre aux questions du quotidien et à comprendre des tendances dans le temps, au-delà des seuls moments de maladie, afin que vous vous sentiez mieux informé et préparé pour des échanges médicaux importants ». L’éditeur indique avoir développé ChatGPT Santé en collaboration avec plus de 260 médecins dans 60 pays. « L’objectif était de comprendre ce qui rend une réponse de santé utile ou, au contraire, risquée. Ce groupe a désormais fourni plus de 600 000 retours sur les réponses du modèle, couvrant 30 domaines d’analyse », fait savoir OpenAI. Cela permettra-t-il de rassurer les utilisateurs réticents à partager leurs données de santé avec le fournisseur américain ?

Car ChatGPT Santé va se nourrir de multiples sources de données de l’utilisateur, tel que des applications de bien-être : Apple Santé (forme physique, mouvements, sommeil, niveaux d’activité), Function (analyse des bilans sanguins et recommandations nutritionnelles), MyFitnessPal (coneils nutritionnels...), Weight Watchers (recettes alimentaires spécifiques...). Mais également à des dossiers médicaux électroniques (résultats d’analyses, comptes-rendus de consultation et historique clinique). « ChatGPT Santé est conçu pour soutenir les soins médicaux, et non pour les remplacer », annonce OpenAI. « La fonctionnalité n’a pas vocation à établir un diagnostic ni à proposer un traitement. » Ces intégrations de données issues d’applications et services tiers dans ChatGPT Santé sont assurées - aux Etats-Unis pour l’instant seulement – par B.Well, un prestataire qui propose une plateforme unifiant des services, solutions, et données de santé, et qui a lancé le mois dernier un SDK utilisable par les assistants IA. Baptisée Connected Health celle-ci a été identifiée par le Gartner en juillet dernier dans deux de ses rapports hype cycle, parmi les « solutions leaders » de ce marché.

Des risques d’hallucination à ne pas écarter

Au lancement, Health est disponible sur le web et iOS, et le sera bientôt sur Android pour les utilisateurs de ChatGPT Free, Go, Plus et Pro dans les pays supportés (à l'exception des pays de l’Espace économique européen, de la Suisse et du Royaume-Uni). Pour garantir la confidentialité et la sécurité des informations de santé, OpenAI indique que ChatGPT Santé fonctionne comme un espace distinct doté de protections renforcées pour les données sensibles. « Si vous démarrez une conversation liée à la santé dans ChatGPT, nous vous proposerons de passer dans l’espace Santé afin de bénéficier de ces protections supplémentaires », poursuit l’éditeur. Dans cet espace, les conversations, applications connectées et fichiers sont stockés séparément des chats classiques avec l’IA d’OpenAI. « Lorsque c’est utile, ChatGPT peut s’appuyer sur le contexte de vos conversations hors de ChatGPT Santé, comme un déménagement récent ou un changement de mode de vie, afin de rendre une discussion de santé plus pertinente », indique toutefois la start-up. « En revanche, les informations et mémoires de santé ne sont jamais réinjectées dans vos conversations principales, et les discussions en dehors de ChatGPT Santé ne peuvent pas accéder aux fichiers, conversations ou mémoires créés dans ChatGPT Santé. »

Pour rassurer les utilisateurs, OpenAI indique apporter des protections supplémentaires, comme du chiffrement dédié et une isolation renforcée pour protéger et cloisonner les conversations de santé. « Vous pouvez renforcer davantage les contrôles d’accès en activant l’authentification multifacteurs (MFA), qui ajoute une couche de protection supplémentaire pour prévenir les accès non autorisés », indique OpenAI. En revanche, l’éditeur se montre discret sur d’éventuelles autres finalités d’exploitation, modalités de conservation ou encore risques d’hallucination, indiquant seulement que « les informations relatives à la santé (y compris les conversations, les souvenirs et les fichiers) ne sont pas utilisées pour entraîner nos modèles de base ».

Commentaire