Il vous reste 98% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte? Connectez-vous

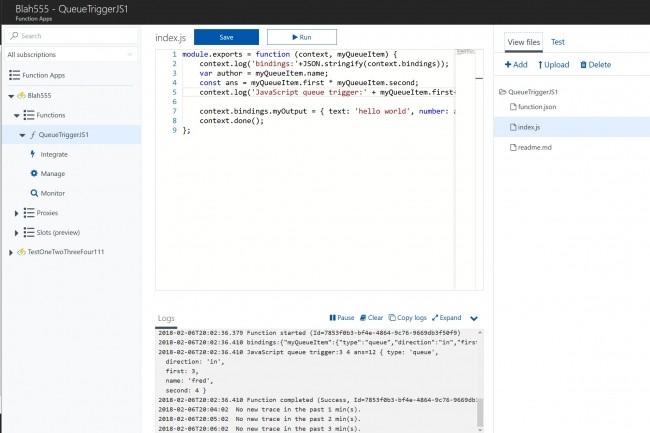

Avec des offres serverless comme Lambda, Cloud Functions et Azure Functions, que proposent respectivement AWS, Google et Microsoft, on peut développer des applications sans gérer de serveurs, et aller assez loin avec un peu de code métier bien appliqué. Les infrastructures serverless présentent chacune des avantages, mais en définitive, ce sont surtout les API et services proposés par ailleurs - Maps, reconnaissance vocale, Office, etc. - qui conduiront à choisir l'une ou l'autre.

Il vous reste 98% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire