Grande mise à jour pour Vertex AI à l’occasion de l’évènement. Next de Google à Las Vegas. La plateforme facilitant la création et le déploiement d’IA générative voit son portefeuille de LLM grossir notamment de Gemini 1.5 Pro, lequel supporte 1 million de tokens en fenêtre contextuelle. Les premiers retours des entreprises sur ce volume sont qu’il éviterait l’affinage des modèles ou l’utilisation du RAG (retrieval augmented Generation) pour rectifier les réponses du modèle.

En outre, Gemini 1.5 Pro dans Vertex AI pourra aussi traiter les flux audio, y compris la parole et le son des vidéos. Google précise que la capacité de traitement audio permet aux utilisateurs de bénéficier d'une analyse multimodale et d'obtenir des informations sur le texte, les images, les vidéos et le son. « Le modèle Pro prendra également en charge la transcription, qui peut être utilisée pour rechercher du contenu audio et vidéo », a ajouté la firme.

Imagen 2 enrichit et Codegemma arrive

Dans le catalogue de Google Cloud, le LLM Imagen 2 évolue, notamment avec des capacités d'édition de photos, la possibilité de créer des vidéos de 4 secondes ou des « images en direct » à partir d'invites textuelles. La fonction de création d'images en direct à partir d'un texte est encore en mode preview, mais les capacités d'édition de photos sont généralement disponibles, de même qu'une fonction de filigrane numérique qui sert à marquer les images générées par l'IA. CodeGemma, un modèle léger de la famille propriétaire Gemma figure aussi parmi les mises à jour LLM de Vertex AI.

Afin d'aider les entreprises à obtenir des réponses plus précises de leurs modèles de base, Google va permettre aux équipes d'utiliser des LLM dans Google Search ainsi que leurs propres données par l'intermédiaire de Vertex AI. « Les modèles de base sont limités par leurs données d'entraînement, qui peuvent rapidement devenir obsolètes et ne pas inclure les informations dont les modèles ont besoin pour les cas d’usage de l'entreprise », a déclaré Google, ajoutant que l'ancrage dans Google Search peut améliorer de manière significative la précision des réponses.

Extension des capacités MLops dans Vertex AI

Par ailleurs, afin d’accompagner les entreprises dans leurs tâches d'apprentissage machine, le fournisseur de services cloud a étendu les capacités MLops de Vertex AI. Une des fonctionnalités étendues appelée Prompt Management aide les équipes à expérimenter des invites, à les migrer des invites et à les suivre ainsi que les paramètres. « Prompt Management fournit une bibliothèque d'invites utilisées par les équipes, y compris les versions, l'option de restauration des anciennes invites et les suggestions générées par l'IA pour améliorer les performances des requêtes », a déclaré Google. « La fonction de gestion des prompts permet aussi aux entreprises de comparer les itérations d'invites côte à côte afin d'évaluer l'impact de petits changements sur les résultats, avec la possibilité pour les équipes de prendre des notes », précise la société.

Parmi les autres fonctionnalités étendues figurent des outils d'évaluation, dont un actuellement en preview pour évaluer les performances du modèle lors de l'itération de la conception de l'invite. Outre l'ajout de fonctionnalités aux modèles, Google Cloud a étendu la résidence des données stockées au repos pour les API Gemini, Imagen et Embeddings de Vertex AI à 11 nouveaux pays : l'Australie, le Brésil, la Finlande, Hong Kong, l'Inde, Israël, l'Italie, la Pologne, l'Espagne, la Suisse et Taïwan.

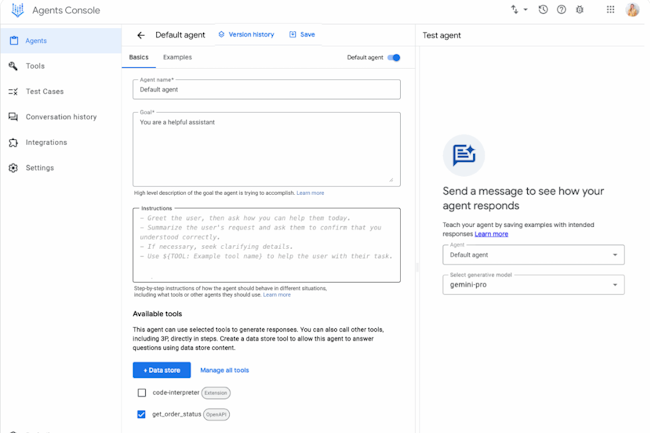

Un agent builder pour Vertex AI

Afin de concurrencer ses rivaux comme Microsoft et AWS, Google Cloud a lancé une offre d'agent builder basée sur l'IA générative. Baptisée Vertex AI Agent Builder, cette offre no-code, combinaison de Vertex AI Search et du portefeuille de produits Conversation de la firme, propose une gamme d'outils pour construire plus rapidement des chatbots étayés par les LLM Gemini. L'avantage de cette offre no-code réside dans son système RAG prêt à l'emploi, Vertex AI Search, qui créer des agents plus rapidement que les techniques RAG traditionnelles, qui sont longues et compliquées. « Il suffit de quelques clics pour être opérationnel et, grâce à des composants prédéfinis, la plateforme facilite la création, la maintenance et la gestion d'implémentations plus complexes », a déclaré Google dans un communiqué. « Les API RAG intégrées dans l'offre peuvent aider les développeurs à effectuer rapidement des vérifications sur les entrées », a-t-elle ajouté. Pour des implémentations encore plus complexes, Agent Builder propose également une recherche vectorielle pour construire des systèmes RAG basés sur des embeddings personnalisés. En outre, les développeurs ont également la possibilité de mouliner les résultats du modèle dans Google Search afin d'améliorer encore les réponses. La gamme d'outils inclus dans l'offre no-code comprend les extensions, les fonctions et les connecteurs de données de Vertex AI.

« Alors que les extensions Vertex AI sont des modules réutilisables préconstruits pour connecter un LLM à une API ou un outil spécifique, les fonctions Vertex AI aident les développeurs à décrire un ensemble de fonctions ou d'API et à faire en sorte que Gemini sélectionne intelligemment, pour une requête donnée, la bonne API ou fonction à appeler, ainsi que les paramètres API appropriés », a expliqué la société. « Les connecteurs de données, quant à eux, permettent d'ingérer des données provenant d'entreprises et d'applications tierces comme ServiceNow, Hadoop et Salesforce ». En plus de toutes les mises à jour de Vertex AI, Google a ajouté Gemini à son offre de business intelligence, Looker. Cette infusion donne à la plateforme des capacités d'analyse conversationnelle, de génération de rapports et de formules, LookML et d'assistance à la visualisation, ainsi que de génération automatisée de diapositives Google. La suite d'offres d'analyse de données bénéficie aussi de ces autres mises à jour, pour l’instant en avant-première, à savoir le lancement d'une version gérée d'Apache Kafka pour BigQuery et l'interrogation continue pour le même service.

Commentaire