Il vous reste 97% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte? Connectez-vous

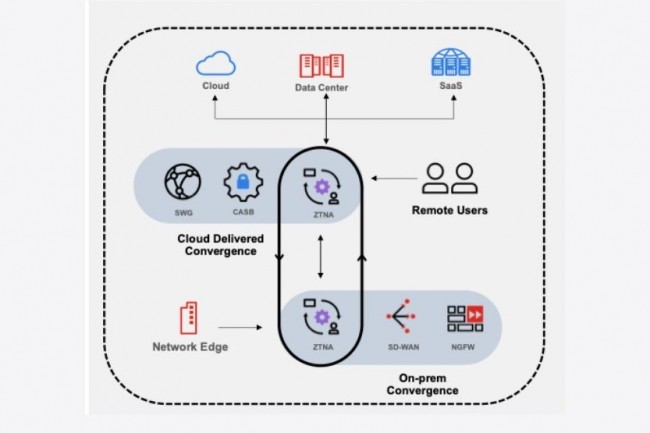

Le zero trust, ou ZTNA, est une stratégie de sécurité, et non un produit, selon laquelle les terminaux et les utilisateurs sont considérés comme non fiables jusqu'à ce qu'ils puissent être authentifiés.

Il vous reste 97% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire