Lancée fin 2023, Cortex AI est la solution du spécialiste en data store Snowflake pour héberger des LLM et fournir aux entreprises des outils facilitant le développement d’applications basées sur l’intelligence artificielle. Après la prise en charge des modèles de langage d’Anthropic, Meta et OpenAI, ce sont ceux de Google Cloud qui viennent renforcer son offre.

Depuis ce 6 janvier, Gemini 3 Pro et Gemini 2.5 Flash sont disponibles en bêta publique dans Cortex AI Functions. Le premier LLM apporte à Snowflake les dernières avancées de Google Cloud en matière de compréhension multimodale, de raisonnement contextuel à long terme et de capacités agentique. Avec à la clé une compréhension plus approfondie des événements et des agents IA plus performants, sans faire l’impasse sur la sécurité et la gouvernance assure le fournisseur. Plus abordable et optimisé pour la vitesse, Gemini 2.5 Flash fournit quant à lui des résultats pertinents pour des tâches de synthèse, de chat, d’extraction de données, de sous-titrage, ...

Gemini bientôt dans Intelligence et Cortex Agents

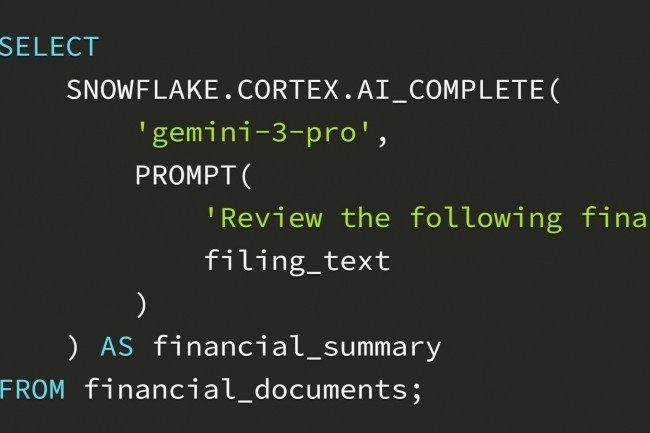

Dans Cortex AI Functions, la solution de Snowflake pour faciliter la création de pipelines d'IA évolutifs à partir de données d'entreprise multimodales avec SQL, les LLM de Google apportent plusieurs avantages selon le fournisseur. « Avec le raisonnement avancé de Gemini 3, les clients peuvent aller au-delà des questions-réponses basiques pour bénéficier d'analyses nuancées, d'une aide à la planification et à la prise de décision qui reflètent mieux la complexité réelle de leurs activités », explique Snowflake. A noter que les LLM Gemini seront prochainement pris en charge dans les solutions Intelligence et Cortex Agents.

Au-delà de cet accord portant sur Gemini, Snowflake annonce par ailleurs l’extension de son partenariat avec Google Cloud en renforçant ses intégrations avec d’autres services comme Vertex AI et BigQuery, et sa disponibilité dans deux autres de ses régions, Arabie Saoudite et Melbourne.

Commentaire