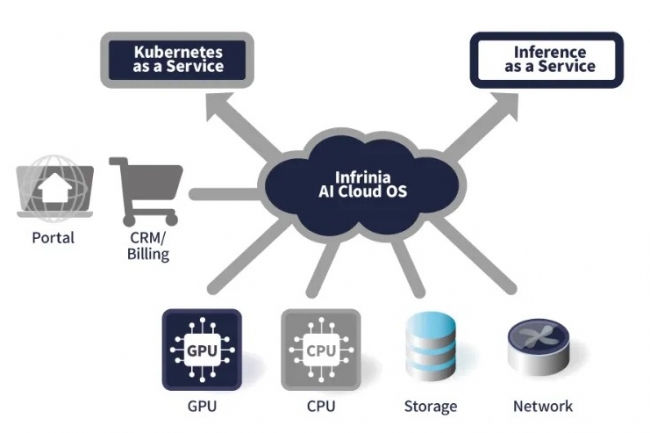

La pile logicielle Infrinia AI Cloud OS pour l'exploitation des centres de données IA lancée par SoftBank automatise la gestion de l'infrastructure et fournit des services d'inférence pour les grands modèles de langage. Les tâches gérées vont de la configuration du Bios à la gestion de Kubernetes sur les plateformes GPU, y compris le système GB200 NVL72 de Nvidia. « En déployant Infrinia AI Cloud OS, les opérateurs de datacenters IA peuvent créer un service Kubernetes-as-a-Service (KaaS) dans un environnement multi-instances, et un service d'inférence as a service (InfaaS) pour disposer de capacités d'inférence des LLM via des API, dans le cadre de leurs propres services cloud GPU », a indiqué SoftBank dans un communiqué. Selon la société, cet environnement a été développé pour répondre à la complexité opérationnelle liée à l'exécution de services cloud GPU. « De plus, la pile logicielle devrait réduire le coût total de possession (TCO) ainsi que la charge opérationnelle par rapport aux solutions sur mesure ou au développement en interne », a précisé la société japonaise. Selon Charlie Dai, vice-président et analyste principal chez Forrester, ce lancement marque l'expansion de SoftBank au-delà du matériel vers la couche logicielle pour les GPU dans le cloud. Il « passe du statut de simple opérateur d'infrastructure à celui de concurrent au niveau de la plateforme IA-native », a souligné M. Dai.

Répondre à des défis complexes

Selon SoftBank, le logiciel fournit deux services principaux. « Le composant Kubernetes-as-a-Service automatise la pile depuis les paramètres Bios et Raid jusqu'au système d'exploitation, aux pilotes GPU, au réseau, aux contrôleurs Kubernetes et au stockage », a détaillé l’entreprise. « Il reconfigure la connectivité physique à l'aide de Nvidia NVLink et de l'allocation de mémoire lorsque les utilisateurs créent, mettent à jour ou suppriment des clusters », poursuit le communiqué. « Le système alloue les nœuds en fonction de la proximité des GPU et de la configuration du domaine NVLink afin de réduire la latence », explique la société nippone. Selon M. Dai, les entreprises sont actuellement confrontées à des défis complexes d'approvisionnement en clusters GPU, de gestion du cycle de vie Kubernetes, de mise à l'échelle de l'inférence et d'ajustement de l'infrastructure, qui nécessitent une expertise approfondie.

« L'approche automatisée de SoftBank répond à ces aspects en gérant la configuration BIOS-to-Kubernetes, en optimisant les interconnexions GPU et en facilitant 'inférence dans des services basés sur des API », a-t-il expliqué. « Cela permet aux équipes de se concentrer sur le développement de modèles plutôt que sur la maintenance de l'infrastructure », a ajouté M. Dai. Selon l'entreprise, « le composant « Inference-as-a-Service » donne aux utilisateurs la capacité de déployer des services d'inférence en sélectionnant des grands modèles de langage sans avoir à configurer Kubernetes ou l'infrastructure sous-jacente. Il fournit des API compatibles avec OpenAI et s'adapte à plusieurs nœuds sur des systèmes tels que GB200 NVL72 ». Selon le communiqué, le logiciel comprend l'isolation des tenants grâce à des communications chiffrées, la surveillance et le basculement automatisés du système, ainsi que des API pour la connexion au portail, à la gestion des clients et aux systèmes de facturation.

Une concurrence de plus en plus intense dans un marché en pleine croissance

Avec ce lancement, SoftBank se positionne pour être compétitif sur un marché qui devrait passer de 8,21 Md$ en 2025 à 26,62 Md$ d'ici 2030. Il est confronté à la concurrence des fournisseurs de cloud hyperscale et des fournisseurs de GPU spécialisés. AWS, Microsoft Azure et Google Cloud proposent des services Kubernetes managés avec prise en charge des GPU via EKS, AKS et GKE. Des néocloud notamment CoreWeave, Lambda Labs et RunPod, proposent déjà des plateformes Kubernetes native ciblant des défis opérationnels similaires. CoreWeave exploite par exemple 45 000 GPU et est le premier fournisseur de services cloud de niveau Elite de Nvidia. Contrary Research indique que Lambda Labs a généré 425 M$ de revenus en 2024 et propose des instances H100 à 2,49 $ HT de l'heure.

Selon M. Dai, l'approche centrée sur les logiciels de SoftBank déplace l'avantage concurrentiel de la disponibilité des GPU à l'automatisation des plateformes. « À mesure que la demande de GPU en tant que Service s'accélère, la différenciation dépend de plus en plus de l'orchestration intelligente, de l'abstraction de l'inférence et des outils intégrés du cycle de vie de l'IA », a-t-il souligné. « Le marché s'oriente vers des plateformes cloud IA-native full-stack plutôt que vers la fourniture de puissance de calcul brute », a ajouté l'analyste.

Premiers déploiements en interne

SoftBank prévoit de déployer d'abord le logiciel dans ses propres services cloud GPU avant de l'étendre à des clients externes. « L'équipe Infrinia prévoit d'installer le logiciel dans des centres de données et des environnements cloud à l'étranger », a indiqué l’entreprise. « Le développement de l'infrastructure IA nécessite non seulement des composants physiques comme des serveurs GPU et des systèmes de stockage, mais aussi des logiciels qui intègrent ces ressources et permettent leur fourniture de manière flexible et à grande échelle », a fait valoir Junichi Miyakawa, CEO de SoftBank, dans un communiqué. Le groupe a déclaré que le logiciel vise à réduire le coût total de possession et la charge opérationnelle par rapport aux solutions personnalisées ou au développement en interne. Pour l’instant, l’entreprise n'a divulgué aucun détail sur le prix ou la disponibilité.

Commentaire