Il vous reste 98% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte? Connectez-vous

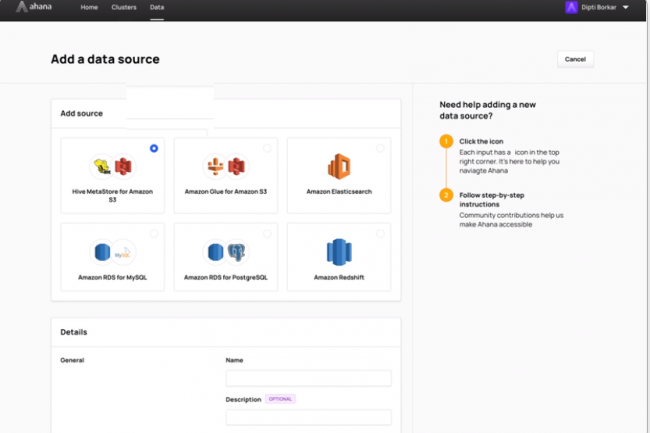

Ahana Cloud for Presto transforme un data lake Amazon S3 en véritable entrepôt de données, sans déplacer aucune donnée. Les requêtes SQL s'exécutent rapidement, même lorsqu'elles sont envoyées à plusieurs sources de données hétérogènes.

Il vous reste 98% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire