Nvidia et SAP ont annoncé hier un partenariat élargi pour fournir aux clients le traitement accéléré dont ils ont besoin pour adopter les grands modèles de langage (LLM) et l'IA générative à l'échelle. Dans le cadre de ce partenariat, SAP va intégrer le service d'IA générative de Nvidia, y compris les microservices d'inférence NIM annoncés récemment lors de la GTC 2024, dans Datasphere, Business Technology Platform (BTP), RISE with SAP et le portefeuille d'applications d'entreprise de l’éditeur allemand. « Nous intégrons l'IA dans nos applications d'entreprise de façon à ce que les clients du cloud puissent l'utiliser facilement, en tant que service, prêt à l'emploi », a déclaré Philipp Herzig, responsable de l'intelligence artificielle chez SAP (CAIO). M. Herzig note que SAP dispose d'un vaste écosystème de partenaires et de divers fournisseurs de LLM, de nouveaux LLM apparaissant presque tous les jours. « L’idée est de faire en sorte que les clients n'aient pas à se soucier de la complexité », a-t-il ajouté. Au final, les clients veulent la meilleure expérience, la meilleure performance ou le prix le plus bas pour utiliser les LLM dans leurs flux de travail. SAP utilise les services de Nvidia, notamment le supercalculateur DGX Cloud AI, le logiciel AI Enterprise et les modèles AI Foundation, pour ajouter de nouvelles capacités au hub d'IA générative dans AI Core et Datasphere de SAP.

La RAG au service de Joule

Nvidia NeMo Retriever, un microservice de récupération sémantique dévoilé en novembre dernier, qui aide les applications de GenAI à fournir des réponses plus précises grâce à la génération augmentée par récupération (Retrieval-Augmented Generation, RAG), renforcera le copilote Joule de SAP. La RAG optimise les LLM en leur donnant la possibilité de référencer des bases de connaissances faisant autorité en dehors de leurs données de formation. « Des tonnes de documents ne résident pas dans un système SAP », a fait remarquer M. Herzig. C’est le cas par exemple de la politique de ressources humaines, de la politique de voyage, des documents de conformité, des documents juridiques, qui peuvent se trouver dans un SharePoint ou sur un portail. Joule est déjà en mesure de répondre à des questions simples, du genre « Combien de jours de vacances me reste-t-il ? » à partir du dossier de l'employé. Mais le microservice de Nvidia permet à Joule d'aller plus loin en lui donnant accès à la politique des ressources humaines et en la comparant au dossier de l'employé.

Des fonctions pour data scientists et développeurs

Le partenariat explore aussi plus de 20 cas d’usage de la GenAI afin d’aider les clients à simplifier la transformation numérique, notamment l'automatisation de l'ERP avec une correspondance intelligente des factures dans S/4HANA Cloud, l'amélioration des cas d’usage des RH via SuccessFactors et l’usage des capacités GenAI de Signavio pour traiter les recommandations commerciales et optimiser les processus d'assistance à la clientèle. Parallèlement, SAP s'appuie sur les plates-formes de traitement accélérées de Nvidia et sur le logiciel de science des données AI Enterprise, dont Rapids, Rapids cuDF et cuML, pour faciliter l'accès des scientifiques aux données et améliorer les performances des charges de travail ML dans Datasphere. Par ailleurs, les services IA de Nvidia aideront les développeurs à créer un code de langage spécifique au domaine et à affiner les LLM pour écrire du code dans le langage de programmation ABAP (Advanced Business Application Programming) de SAP. « Un grand nombre de codes hérités ont été écrits dans ce langage de programmation appelé ABAP, et il s'avère que les grands modèles de langage ne sont généralement pas adaptés à ABAP », a expliqué M. Herzig. « Si les LLM prêts à l'emploi peuvent produire un code ABAP qui aurait été acceptable dans les années 1990, ils ne s'accordent pas avec les principes de conception modernes de ABAP Cloud », a-t-il précisé.

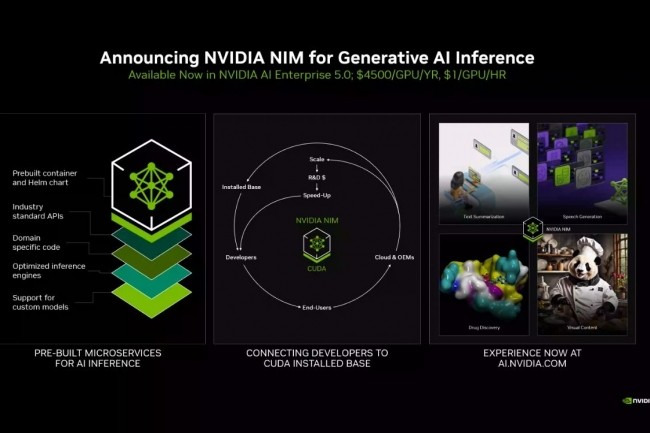

« La génération de code ne fonctionne pas vraiment avec la RAG », a ajouté Kari Ann Briski, vice-présidente de la gestion des produits logiciels d'IA générative chez Nvidia. « Il n’est pas possible de récupérer du code, puis de le copier et de l'écrire. Le code génératif doit vraiment provenir de la connaissance du langage et de la capacité à le créer pour obtenir une invite naturelle ». Enfin, les microservices d'inférence Nvidia NIM, également annoncés hier, aideront les clients à optimiser les performances d'inférence dans leur infrastructure SAP. « Il s'agit essentiellement de microservices préconstruits par Nvidia pour divers modèles : des modèles ouverts de l'écosystème, des modèles propriétaires, certains modèles de Nvidia, des modèles de petites startups jusqu’à ceux des grands clouds », a indiqué Manuvir Das, vice-président de l'informatique d'entreprise chez Nvidia. « Nous prenons le modèle et nous l'assemblons avec les moteurs optimisés pour ces modèles afin qu'ils fonctionnent le plus efficacement possible sur une gamme de GPU Nvidia que l'on peut trouver dans les ordinateurs portables ou les stations de travail, les centres de données ou les clouds ».

Commentaire