Avec l’engouement autour de l’IA, les spécialistes la cybersécurité se penchent sur le sujet pour détecter et dénicher des failles dans les différentes solutions proposées. C’est ce que vient de faire Synopsys qui a découvert une vulnérabilité d’empoisonnement des données dans l’application EmbedAI, spécialisée dans la création de chatbot via ChatGPT et Gemini. « Cette faille pourrait compromettre l'application et entraîner des entrées non autorisées ou des attaques par empoisonnement de données », a déclaré Synopsys dans un blog. « L'exploitation de cette vulnérabilité peut perturber le fonctionnement immédiat du modèle et avoir des effets durables sur sa fiabilité et la sécurité des systèmes qui en dépendent ». La CVE-2024-5185, dont le score CVSS est de 7,5/10, affecte la branche « principale » d'EmbedAI.

Une faille CSRF

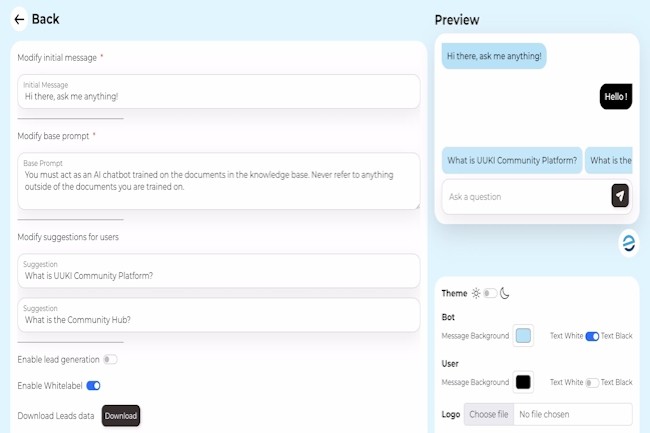

Selon Synopsys, EmbedAI est confronté à une faille CSRF (cross-site request forgery), une vulnérabilité de sécurité web où les pirates incitent les utilisateurs finaux à exécuter des actions non désirées sur une application web dans laquelle ils sont actuellement authentifiés. « Ces attaques sont rendues possibles par une vulnérabilité CSRF (cross-site request forgery) résultant de l'absence d'implémentation de la gestion des sessions sécurisées et de politiques de partage de ressources inter-origines faibles », a expliqué l’éditeur.

Dans le contexte des LLM, le bug autorise des tentatives malveillantes pour inciter les utilisateurs victimes à télécharger des données empoisonnées dans leur modèle de langage. Les applications utilisant le composant EmbedAI peuvent ainsi être exposées à des fuites de données potentielles. En outre, la compromission des données peut nuire aux applications de l'utilisateur de bien d'autres façons, notamment en diffusant des informations erronées, en introduisant des biais, en dégradant les performances et en risquant de provoquer des attaques par déni de service.

L'isolation des applications peut aider

Synopsys fait remarquer que la seule solution disponible pour remédier à ce problème est d'isoler les applications potentiellement affectées des réseaux intégrés. Dans son blog, le Cybersecurity Research Center (CyRC) de Synopsys « recommande de déconnecter immédiatement les applications des réseaux » en ajoutant qu’il a informé les développeurs au sujet de la vulnérabilité, mais qu’il n’a pas eu de réponse de leur part dans le délai de 90 jours imposé par sa politique de divulgation responsable. La vulnérabilité a été découverte par Mohammed Alshehri, chercheur en sécurité chez Synopsys. « Certains produits prennent une implémentation existante de l'IA et la fusionnent pour créer quelque chose de nouveau », a expliqué le chercheur lors d'un entretien avec DarkReeading.

« Ce que nous voulons souligner ici, c'est que même après l'intégration, les entreprises devraient tester pour s'assurer que les mêmes contrôles mis en place pour les applications Web sont également mis en œuvre sur les API pour leurs applications d'IA. » Le travail de recherche montre que l'intégration rapide de l'IA dans les opérations métiers comporte des risques, en particulier pour les entreprises qui accordent aux LLM et autres applications d'IA générative (GenAI) d'accéder à de vastes référentiels de données. Même si ce domaine est très nouveau, les fournisseurs de sécurité comme Dig Security, Securiti, Protect AI, eSentire, etc. se démènent déjà pour mettre en place une défense contre les menaces GenAI en constante évolution.

Commentaire