Les entreprises qui utilisent la plateforme de stockage vSAN de VMware ont peut-être dépensé beaucoup plus que nécessaire en matériel. Le fournisseur a reconnu que pendant longtemps ses recommandations de dimensionnement étaient basées sur des tests qui ne reflétaient pas les conditions réelles. VMware a révélé que l'analyse des données télémétriques provenant de milliers de clusters vSAN en production a montré que « les clusters vSAN utilisaient beaucoup moins de RAM que prévu » et qu’ils « peuvent utiliser moins de ressources CPU que prévu ». « Les recommandations matérielles pour les réseaux de stockage virtuel vSAN ont toujours été dérivées de tests synthétiques », a écrit Pete Koehler, ingénieur en marketing produit chez VMware, dans un blog annonçant la révision des spécifications. « Bien qu'utiles, ils ne reflètent pas les caractéristiques des charges de travail réelles ni le comportement du système de stockage. »

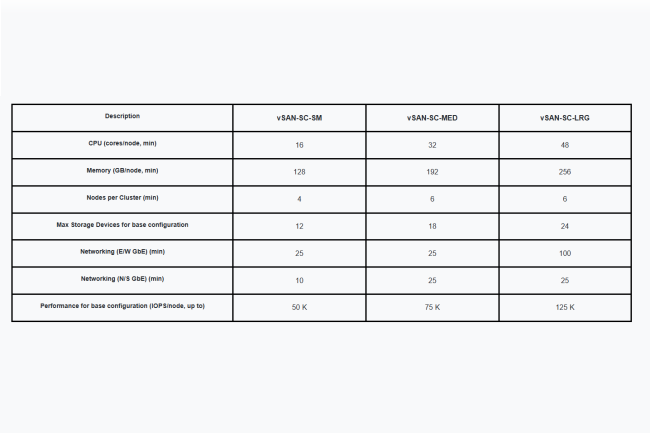

Sur la base de ces conclusions, l’entreprise a désormais révisé à la baisse, parfois de manière spectaculaire, ses spécifications pour ReadyNode, les configurations de serveurs certifiées par VMware pour une utilisation dans les déploiements vSAN. Dans ses dernières recommandations, le fournisseur a réduit les exigences de RAM pour les clusters de stockage jusqu'à 67 %, tandis que le minimum pour les cœurs de processeur a été abaissé jusqu'à 33 %. Selon Pete Koehler, pour les clusters HCI, les exigences de mémoire sont réduites jusqu'à 50 %. Si l’on met cela en perspective, on voit qu’auparavant le profil de cluster de stockage le plus performant nécessitait 768 Go de RAM par hôte. Les dernières recommandations préconisent un minimum de 256 Go. « Le profil minimal passe de 256 Go à 128 Go, avec une réduction du nombre de cœurs de 24 à 16 », indique le blog. VMware a affirmé que sur la base de ces spécifications révisées, les entreprises pourraient économiser « plusieurs dizaines de milliers de Go de RAM » par hôte, avec des « économies en cascade » sur l'ensemble des clusters de stockage distribués grâce à la réduction des besoins en licences, en énergie, en refroidissement et en espace de rack.

Un surinvestissement massif des entreprises

Alors que VMware présente cette annonce comme une opportunité de réduction des coûts, les analystes estiment qu'elle soulève des questions délicates pour les entreprises qui ont investi massivement dans des infrastructures sur la base des recommandations précédentes de l'entreprise. « Il ne s'agit pas d'un simple excès de technologie sur l'environnement », a déclaré Sanchit Vir Gogia, analyste en chef et CEO de Greyhound Research. « Les entreprises qui ont suivi les précédentes recommandations de VMware concernant vSAN ont investi massivement dans des infrastructures qui dépassaient largement les besoins réels de leurs charges de travail. Il ne s'agissait pas d'erreurs théoriques, mais bien d'un sur-provisionnement en mémoire et d'une sous-utilisation des capacités de calcul dans les centres de données du monde entier. » Charlie Dai, vice-président et analyste principal chez Forrester, s’accorde aussi à dire que l'impact est énorme. « Les prévisions antérieures exagérées de VMware peuvent se traduire par des coûts d'infrastructure importants. Par conséquent, ces récentes prévisions auront un impact considérable sur la réduction des dépenses d'investissement inutiles. » Broadcom n'a pas immédiatement répondu à une demande de commentaires sur le sujet.

Autre sujet soulevé par les analystes, depuis des années, VMware collecte des données télémétriques provenant des environnements de ses clients, alors pourquoi l'entreprise n'a-t-elle pas identifié et résolu ce problème plus tôt ? « Les données télémétriques étaient disponibles. Ce qui manquait, c'était le mécanisme — et la volonté — d'agir en conséquence », a pointé M. Gogia. « Pendant des années, les clients ont signalé que les clusters de production étaient loin d'atteindre les plafonds de ressources prescrits par VMware. Pourtant, le dimensionnement officiel est resté inchangé. » Selon M. Dai, ce retard reflétait un problème systémique qui dépassait le cadre de VMware. « Ce délai montre qu’il y a un écart entre la validation en laboratoire et les réalités de la production. Ce constat soulève des préoccupations plus larges : les recommandations de dimensionnement des fournisseurs privilégient souvent la prévention des risques plutôt que la rentabilité, les DSI doivent donc valider ces recommandations par rapport aux données réelles sur la charge de travail. » VMware estime que son approche était raisonnablement prudente et qu’elle était conçue pour garantir que vSAN « dispose d'un matériel suffisant pour répondre aux attentes de performances dans les circonstances les plus extrêmes ». Cependant, l'écart entre les exigences des tests synthétiques et les besoins réels de production s'est avéré suffisamment important pour que l'entreprise revoie l'ensemble de son framework de certification ReadyNode.

Des interrogations sur le timing

Cette annonce arrive également à un moment délicat pour Broadcom, la société mère de VMware, qui a fait l'objet de vives critiques suite aux modifications apportées à ses licences, lesquelles ont entraîné une augmentation des coûts pour de nombreuses entreprises clientes après son acquisition de VMware pour 69 milliards de dollars fin 2023. La restructuration de Broadcom a regroupé les produits VMware dans des suites plus larges et orienté les clients vers des modèles d'abonnement, incitant certaines entreprises à évaluer des alternatives, notamment celles de Nutanix, OpenStack et Proxmox. Dans ce contexte, les analystes ont souligné le moment opportun de l'annonce de VMware. « Il est difficile d'ignorer le timing », a déclaré M. Gogia. « Le réajustement de VMware intervient alors que les clients s’inquiètent fortement des modifications apportées aux licences de Broadcom. La révision à la baisse des exigences matérielles repositionne efficacement le discours sur les coûts et rend la pile VMware plus attractive, alors que de nombreux DSI explorent des stratégies de sortie. »

Charlie Dai est du même avis. « Face à la réaction négative suscitée par les licences Broadcom et à l'intérêt croissant pour Nutanix et OpenStack, VMware essaye de mettre en avant une possible optimisation des coûts. Même si cela améliore le coût total de possession (TCO), les entreprises doivent y voir à la fois un ajustement technique et une stratégie de fidélisation concurrentielle. » Cependant, M. Gogia a averti que la réduction des coûts matériels ne répondait pas aux préoccupations fondamentales des clients. « Réduire les exigences matérielles peut alléger la charge financière, mais cela ne résout pas les inquiétudes plus profondes à propos de la structure des licences VMware, l'évolution des prix ou l'orientation à long terme des produits. Ce redressement de cap est bienvenu, et mais il ne remet pas les pendules à zéro. »

Que faire maintenant ?

Compte tenu de ces complexités, que doivent faire les entreprises qui exploitent ou prévoient actuellement de déployer vSAN avec ces informations ? « Cette mise à jour devrait inciter tous les DSI qui exploitent ou prévoient de déployer vSAN à revoir leur stratégie d'infrastructure », a conseillé M. Gogia. « Ces derniers devraient donner la priorité à l'application prospective du récent modèle de dimensionnement, l'utiliser pour peser sur les contrats à venir et éviter de céder à la tentation de réorganiser des clusters stables en cours de cycle, sauf en cas de nécessité absolue. »

Charlie Dai recommande une approche similaire. « Pour les déploiements existants, les DSI doivent évaluer si le matériel peut être réutilisé ou réduit lors des cycles de renouvellement. Pour les nouveaux projets, il convient d'appliquer des spécifications révisées afin d'éviter tout sur-provisionnement. Plus généralement, ils doivent intégrer le dimensionnement basé sur la télémétrie dans leur stratégie de virtualisation afin d'éviter des inefficacités similaires sur toutes les plateformes », explique-t-il. Les deux analystes ont souligné que ces enseignements dépassaient le cadre de VMware. « C'est aussi un signal d'alarme pour les DSI et les architectes : les conseils des fournisseurs ne peuvent pas être suivis aveuglément », a déclaré M. Gogia. « La télémétrie interne, la modélisation spécifique au contexte et la validation continue doivent désormais occuper une place centrale dans la planification de l'infrastructure. »

Commentaire