Flux RSS

HPC

138 documents trouvés, affichage des résultats 101 à 110.

| < Les 10 documents précédents | Les 10 documents suivants > |

(27/05/2010 17:26:02)

Le CEA met en service le Tera100 développé avec Bull (MAJ)

Le CEA annonce la mise en service du Tera100, le super calculateur développé par Bull. C'est la Direction des Applications Militaires du CEA qui utilisera les capacités de calcul de ce supercomputer pour son programme de simulation nucléaire. D'une puissance de 1,05 Petaflops, le Tera100 se classe, à ce jour, parmi les 3 premiers supercalculateurs au monde.

Installé en mars dernier par Bull, le Tera 100 a été mis sous tension le 26 mai 2010. Il regroupe 4 300 serveurs de type bullx série 5 équipés de 140 000 coeurs Intel Xeon 7500, une plateforme X86-64 donc en lieu et place des Itanium IA-64 du Tera10. La mémoire vive exploitable atteint un total de 300 To, et la capacité de stockage globale 20 Po. Le système offre un débit de 500 Go/s pour les échanges entre machines. Selon Bull et le CEA, la capacité de calcul représente « plus d'opérations en une seconde que ce la population ferait en 48 heures, à raison d'une opération par seconde et par personne. »

Par rapport au Tera10, reposant sur des puces Itanium et mis en service en 2005, ce supercomputer est jusqu'à 20 fois plus puissant tout en occupant le même emplacement au sol et en offrant un meilleur rendement énergétique.

(...)(26/05/2010 15:11:18)HP passe devant IBM sur le marché des serveurs

Au premier trimestre 2010, Hewlett-Packard a ravi à IBM la première place (en valeur) sur le marché mondial des serveurs. Un secteur marqué par la progression des ventes des systèmes x86 et la baisse continu des machines Unix et des mainframes, a indiqué le cabinet d'études Gartner. Le chiffre d'affaires mondial de ce marché a augmenté de 6% par rapport à l'année dernière à la même époque, pour atteindre les 10,8 milliards de dollars. Le nombre d'unités vendues a grimpé de 23%, soit un total de 2,1 millions serveurs, ce qui signifie que les prix de vente continuent de se tasser.

L'économie est en voie de guérison et les entreprises s'emploient à moderniser leurs serveurs anciens, a expliqué Jeffrey Hewitt, vice-président en charge de la prospective au Gartner. L'arrivée des processeurs Intel Xeon Westmere et Nehalem-EX a été l'occasion de renouveler les équipements, poursuit-il. Mais l'industrie n'est pas encore revenue aux pics trimestriels qu'elle affichait en 2008. Toujours au 1er trimestre, les revenus issus des ventes de serveurs à base de processeurs x86 étaient de 7,18 milliards de dollars, en hausse de 32%, tandis que les expéditions de machines ont atteint 2,06 millions d'unités. Le chiffre d'affaires de la branche haut de gamme qui comprend notamment les serveurs Risc Itanium a diminué de 27%, et la catégorie «autres» - pour la plupart des mainframes - a diminué de 15%.

La tendance générale est favorable à HP et à Dell, qui ont bénéficié des plus grands gains au cours du trimestre, et qui a vu la débâcle de l'activité serveurs d'Oracle. Les revenus de HP sur ce segment sont montés à 3,39 milliards de dollars, en hausse de 15,9 % d'une année sur l'autre, ce qui représente 31,5% de part de marché. Le chiffre d'affaires d'IBM a chuté de 2,1% à 3,05 milliards de dollars (28,4% en part de marché). A la troisième place, on retrouve donc Dell, dont les revenus ont augmenté de 35,5% avec 1,67 milliard de dollars, soit une part de marché de 15,6%. Alors que la compagnie a bien tenté de rassurer les clients de Sun en leur indiquant qu'elle allait continuer à investir sur le créneau des serveurs, Oracle enregistre une forte diminution. Les livraisons ont baissé de 29,5 % pour atteindre 42.528 serveurs, tandis que les revenus de cette activité ont diminué de 38,7% à 598 millions de dollars. Si l'incertitude continue de nuire à l'entreprise, certains acheteurs attendent peut être de futurs processeurs Ultra SPARC pour changer de machines, analyse Jeffrey Hewitt. Aucune information ne filtre chez Oracle sur ce sujet mais les cycles de ventes et les durées de vie des serveurs Risc sont généralement plus long que ceux des machines x86.

En Europe et en volume, toujours selon les chiffres du Gartner, HP reste également le leader avec 43,7% de part de marché, Dell arrive deuxième avec 18,60% et IBM pointe seulement à la troisième place avec 11,20%. 606 778 serveurs ont été vendu au premier trimestre 2010 sur le vieux continent, soit une hausse de 19,7% par rapport à l'année dernière. Avec prés de 100 000 unités supplémentaires, le marché a donc également redémarré de ce coté de l'Atlantique.

Illustration HP ProLiant SL2x170z G6, crédit H.P.

(...)(07/05/2010 17:21:31)Jusqu'à 12 coeurs pour le prochain Westmere-EX d'Intel ?

Le fondeur de Santa Clara a annoncé que ses prochaines puces Westmere-EX offriront plus de coeurs et des fréquences plus rapides. Gravés en 32 nm, contre 45 pour les Nehalem-EX, les processeurs Westmere-EX cibleront les serveurs à quatre sockets et plus, a déclaré Stephen Smith, vice-président chez Intel, lors d'un discours retransmis sur le web.

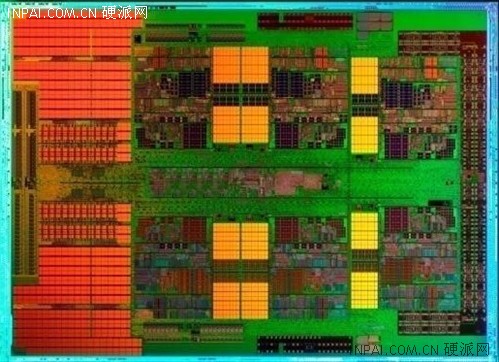

Introduites en mars dernier, les puces Nehalem-EX, disponibles sous les appellations commerciales Xeon 7500 et 6500, sont destinées aux serveurs haut de gamme qui nécessitent performances et temps de disponibilité élevé. Pour répondre ces besoins, Intel a intégré à ses puces des fonctions de correction d'erreur et des facilités de maintenance (RAS). Augmenter le nombre de coeurs est aujourd'hui une des solutions retenues par la société pour améliorer les performances tout en essayer de réduire la consommation des puces. En mars dernier, Intel avait également dévoilé sa plate-forme Westmere-MP (Xeon 5600), gravée en 32 nm, et offrant jusqu'à six coeurs par socket. Le fondeur annonçait des performances en hausse de 60% par rapport à la génération précédente.

[[page]]«Nous avons toujours dû faire des compromis entre performances brutes et fonctionnalités, en poussant dans un sens ou dans l'autre mais ici nous avons choisi de promouvoir les deux", a expliqué Stephen Smith. Ce dernier a toutefois refusé de révéler la vitesse d'horloge et le nombre de coeurs sur les puces Westmere-EX. La société ne précise pas non plus le trimestre où seront introduits ces processeurs. Le dirigeant indique simplement qu'un rafraîchissement de la gamme processeurs pour serveurs sera réalisé en « milieu de cycle », et qu'elle offrirait une compatibilité descendante pour protéger les investissements des fabricants de systèmes Nehalem-EX. « Nous venons juste de lancer les Nehalem-EX (...) Ces plates-formes ont généralement une durée de vie (...) de deux ans et plus. Le développement a bien avancé et nous sommes confiants. Ce produit va nous donner un coup de pouce au niveau des performances. Et pour préserver les plates-formes et les investissements de nos partenaires OEM, ces puces iront dans les mêmes sockets ».

Plus de coeurs pour gagner en performances

Rappelons qu'Intel a apporté 50 % de coeurs supplémentaires avec ses Westmere-EP, et pourrait faire de même avec la mise à jour Westmere-EX, a souligné Nathan Brookwood, analyste chez Insight 64. Si les puces Nehalem-EX offrent jusqu'à huit coeurs, Intel pourrait monter à 12 avec les Westmere-EX, avance l'analyste. Il ajoute que cela apportera un gain significatif de performances sur les serveurs haut de gamme. Les centres de calcul seraient en mesure de supporter une plus grande charge de travail sans augmenter le nombre de machines. Ces puces contribueraient également à la réduction de la consommation électrique tout en consolidant les serveurs dans des salles plus petites. Westmere-EX permettra également de contrer les prochaines offres d'AMD. « Ce qui est intéressant, c'est qu'AMD a déjà un processeur 12 coeurs, le Magny-Cours, et qu'ils sortiront l'année prochaine un puce 16 coeurs gravée en 32 nanomètres », a précisé Nathan Brookwood. Connue sous le nom de code Interlagos, cette plate-forme reposera sur une microarchitecture baptisée Bulldozer.

Nehalem-EX et vSphere 4 avec les serveurs novascale bullion de Bull

« Avec notre offre bullx Série B en lame et Série R en rack (sur base Intel Xeon Westmere), nous couvrons une grande part des besoins en extreme computing, dans la banque, l'industrie et la recherche scientifique », assure Bruno Pinna, directeur marketing de Bull, « mais avec le lancement de la Série S (sur base Nehalem-EX/ https://www.lemondeinformatique.fr/actualites/lire-intel-nehalem-ex-cap-sur-la-performance-et-la-haute-disponibilite-30323.html), nous proposons des serveurs quadri sockets capables de monter en puissance grâce un lien d'interconnexion maison, le BCS (Bull Coherent Switch). Avec cette technologie, nous proposons des noeuds de 8, 12 ou 16 processeurs Xeon 7500 avec un maximum de 2 To de mémoire. » Depuis l'annonce Intel, on voit beaucoup de serveurs haut de gamme Nehalem-EX 4 ou 8 sockets reposant sur des composants standards ou spéciaux. Bull, comme SGI, s'est spécialisé dans le développement de solutions originales.

[[page]]

Même approche pour la gamme novascale bullion, Bull a en effet décidé de livrer nativement ses serveurs sur base Intel Xeon Nehalem-EX avec vSphere 4, la suite de virtualisation de VMware. « Nos serveurs novascale bullion partagent leurs caractéristiques techniques avec les bullx Série S mais, sur les premiers, nous avons décidé de mettre l'accent sur la fiabilité avec le support des fonctions Race et le partenariat avec VMware. Le marché évolue et nous pensons que la conjonction entre une machine « scalable » et l'outil vSphere 4 permet d'offrir à nos clients une plate-forme technologique stable et évolutive, et ce, dans un environnement critique virtualisé. » Sur la question de savoir pourquoi le partenariat a été fait avec VMware plutôt qu'avec Microsoft, Bruno Pinna assure trouver chez le premier une compréhension globale du marché, « on sent bien toute une stratégie cloud interne et une évolution vers le software mainframe. Nous avons également des projets en cours avec Microsoft qui reste un partenaire privilégié, mais les novascale bullion seront exclusivement livrés avec vSphere 4 et l'hyperviseur ESX 4. »

Pour l'instant, Bull ne propose pas de serveurs sur base AMD Opteron mais rien n'est définitivement exclu précise Bruno Pinna. « Nous avons effectivement une collaboration étroite avec Intel, nous finalisons par exemple avec ce dernier le Tera 100, un super calculateur pour le CEA capable d'atteindre le PetaFlop, une première en Europe. Nous nous focalisons dans nos choix et nous sommes très satisfaits de nos partenariats.»

Pour les prix, la gamme bullx démarre à 20K€. Pour les novascale bullion, Bull annonce 200K€ pour le serveur (avec WMware vSphere 4), 200K€ pour la solution de stockage et 100K€ pour les services associés.

Microsoft s'immisce un peu plus dans le calcul haute performance

En novembre dernier, Microsoft avait publié la version beta de Windows HPC Server 2008 R2. Aujourd'hui, la firme de Redmond annonce la disponibilité via téléchargement d'une mise à jour de cet outil. En 2008, Microsoft avait franchi le Rubicond en présentant, à Shanghai, un cluster basé sur Windows HPC se plaçant en 10ème position (19ème aujourd'hui) dans le classement des 500 ordinateurs les plus puissants dans le monde.

« Avec cette mise à jour, nous anticipons notre présence dans le Top 500 » explique Vince Medillo, directeur marketing produit, au sein du groupe dédié aux calculs haute performance. Cette seconde version de la beta doit prendre en considération les retours clients et les résultats des premiers tests réalisés sur les 1 000 nodes du centre de recherche de Microsoft. « Notre objectif est de rendre le calcul en parallèle plus facile, car aujourd'hui la programmation en parallèle est trop compliquée à mettre en oeuvre » souligne Vince Medillo. Des fonctionnalités intégrées dans le poste de travail doivent permettre d'optimiser la puissance des PC pour améliorer la vitesse des clusters. Ainsi, une société, disposant de 500 PC, pourra faire tourner un cluster HPC pendant la nuit, période où les salariés n'utilisent pas leur ordinateur. La mise à jour comprend également une intégration avec Excel, accélérant la programmation des plages de calcul. Dans un autre registre, les évolutions de Visual Studio 2010, présentées prochainement, aidera les développeurs à créer, débloquer des applications HPC.

La version définitive est attendue à l'automne 2010.

(...)(29/03/2010 15:16:49)Opteron 6100 : Un gros 12 coeurs AMD pour contrer les 6 coeurs d'Intel (MAJ)

Face à un concurrent toujours plus redoutable qui vient de dévoiler ses plates-formes bi et quadri sockets pour serveur (Intel Xeon Westmere 32 nm et Nehalem-EX 45 nm), AMD double le nombre de coeurs disponibles dans sa ligne de processeurs pour serveurs bi et quadri sockets avec la génération Magny-Cours. Le gain de performance attendu avec ces Opteron est environ le double des précédentes puces six coeurs selon AMD. Il faut bien évidemment comparer ces benchmarks avec ceux des Xeon Westmere 5600 et des Nehalem-EX 7500/6500, notamment sur les points des performances brutes et de la consommation électrique. Seul bémol sur ce dernier point, AMD communique ses chiffres en se basant sur la consommation moyenne (ACP) alors qu'Intel livre des données de type TDP (consommation maximale). Difficile de vraiment comparer l'enveloppe thermique des deux plates-formes dans ces conditions.

Dans son premier communiqué de presse sur la question, AMD ne compare toutefois les benchmarks de l'Opteron 6174 deux sockets que face au Xeon 2 voies X5680 (voir infographie ci-dessous). Le premier constat est qu'AMD a besoin de 12 coeurs pour faire le travail d'un six coeurs chez Intel mais avec une enveloppe thermique difficile à comparer (105 Watts en ACP contre 130 chez Intel en TDP). Un point pourtant particulièrement important quand on densifie ses salles informatiques pour réduire le nombre de serveurs. Les X6500 d'Intel (bi socket Nehalem-EX ) n'ayant pas encore été officiellement dévoilés, il est encore nécessaire d'attendre quelques heures pour confronter ces nouveaux bi sockets face à face...

Le fondeur entend bien tirer à profit les gains offerts par cette plate-forme pour convaincre les entreprises de remplacer leurs serveurs bi sockets par sa solution. Un des principaux avantages mis en avant par AMD est la réduction des coûts de licences logicielles. En 2004, avec l'arrivée des processeurs double coeur, Microsoft avait annoncé qu'il continuerait à licencier ses logiciels en prenant comme base les processeurs, et non pas le nombre de coeurs par puce. De nombreux fournisseurs ont une approche similaire mais cette pratique commerciale n'est pas universelle.

[[page]]

Pour Matt Lavallée, directeur technique de la société MLS Property Information Network (Shrewsbury, Massachusetts) qui fournit des données immobilières à des sites marchands, le passage 4 à 12 coeurs sur ses serveurs Opteron lui permettra de réduire le nombre de ses serveurs et de diminuer les coûts de ses licences logicielles. Matt Lavallée qui a déjà effectué des tests avec des préversions de Magny-Cours estime que l'utilisation de puces douze coeurs de base, qui coûtent un peu plus chers que les huit, est un bon moyen de réduire les coûts de ses serveurs SQL.

SIA exploite 60 serveurs, et son directeur technique pourrait théoriquement réduire de moitié son nombre de machines avec une évolution vers Magny-Cours. Prudemment, il envisage de diminuer d'un tiers seulement ses serveurs avec une mise à jour au niveau des puces. Matt Lavallée explique avoir commencé à utiliser des puces Opteron il y a environ deux ans et demi, et estime que le principale avantage de ces puces résident dans leur débit très important (jusqu'à 5,2 Gb/s, voir encadré).

Gordon Haff, analyste chez Illuminata, précise que c'est la performance, et non le nombre de coeurs, qui compte sur ces puces. Il s'attend à ce qu'Intel et AMD offrent au final des performances similaires mais en utilisant des approches différentes. AMD dispose de 10 options de tarification en fonction du nombre de coeurs, des cadences d'horloge et de la consommation électrique : compter environ 455 $ pour une puce huit coeurs à 1,8 GHz (65 Watts) et 1 386 $ pour un 12 coeurs à 2, 3 GHz (105 Watts).

(...)(08/03/2010 15:03:27)

Huit coeurs et tolérance aux pannes accrue pour les Intel Xeon Nehalem-EX

Développée pour les serveurs quatre sockets, la génération Xeon Nehalem-EX (huit coeurs par processeur) vise le marché haut de gamme : base de données et usage intensif d'applications dans des environnements virtualisés. La semaine dernière, IBM a annoncé qu'il mettrait en oeuvre ces puces dans ses serveurs System x eX5 . Le PDG d'Intel, Paul Otellini, a simplement décrit Nehalem-EX comme le processeur maison le plus rapide à ce jour. Aucune information sur la fréquence n'a été indiquée mais la puce, gravée en 45 nm, sera dotée de 24 Mo de cache et de 2,3 milliards de transistors. Chaque noyau physique sera en mesure d'exécuter deux threads simultanément, ce qui permettra à cette plate-forme de supporter jusqu'à 64 coeurs virtuels sur les serveurs, a déclaré Shannon Poulin, directeur Plate-forme Xeon d'Intel. Rappelons que l'architecture Nehalem intègre le contrôleur mémoire et améliore la vitesse du système en réduisant les goulets d'étranglement qui ont longtemps été le talon d'Achille des systèmes Xeon. Intel exploite également de nouvelles technologies comme la MCA pour améliorer la correction d'erreurs. Le processeur sera capable de détecter les erreurs issues du CPU ou de la mémoire et de les corriger en travaillant avec le système d'exploitation. Certaines de ces technologies sont issues des travaux engagés sur les puces très haut de gamme Itanium, qui reposent sur une architecture distincte et principalement destinées aux systèmes Unix hautes disponibilités. Les processeurs EX intègrent également des composants de mémoire tampon distincts pour stocker temporairement des données aux côtés de la mémoire principale et accélérer significativement l'exécution des tâches. Sur cette plate-forme, Intel devrait également offrir quatre canaux de mémoire par processeur, indique Shannon Poulin. Une condition sine qua none pour rattraper AMD et sa puce douze coeurs pour serveurs, le célèbre Opteron Magny-Cours. Plus de tuyaux pour fournir plus de bande passante mémoire et exécuter plus rapidement les programmes. Intel apporte plus de mémoire cache avec son Nehalem-EX pour améliorer les performances de sa puce, mais AMD Magny Cours offre plus de noyaux physiques par processeur. [[page]] AMD a commencé à livrer ses processeurs Magny-Cours, et l'arrivée de l'Intel Nehalem-EX devrait intensifier la bataille entre les deux rivaux qui cherchent à obtenir très rapidement des références clients dans les entreprises, nous a indiqué Nathan Brookwood, analyste chez Insight 64. Mais dans cette bataille, AMD pourrait détenir un avantage sur Intel quant à la tarification. Le fondeur de Santa Clara pourrait facturer un supplément substantiel pour ses puces Nehalem-EX, tandis que le processeur Magny-Cours offrirait un meilleur rapport coût /performances par coeur selon l'analyste. Les résultats de cet affrontement pourraient toutefois tourner court car les performances ne constituent qu'une partie de l'affaire, poursuit Nathan Brookwood. Les Nehalem-EX pourraient conquérir un nouveau marché grâce aux fonctionnalités supplémentaires comme la tolérance aux pannes, précise encore Nathan Brookwood. Intel pourrait enfin imposer ses puces X86 sur le territoire des serveurs haut de gamme partagé aujourd'hui entre les processeurs Risc d'IBM (PowerPC), d'Oracle/Sun (Sparc) et même de HP/Intel (Itanium). Le directeur de la plate-forme Xeon d'Intel, Shannon Poulin, indique également que la société lancera également des puces Xeon basées sur l'architecture Westmere. Des processeurs six coeurs qui seront tout d'abords intégrés aux serveurs bi sockets. Le jeu de composants capable de gérer des cartes mères quadri sockets ne sera pas disponible avant l'année prochaine. Gravé en 32 nm, les puces Westmere intègrent 1,17 milliard de transistors et jusqu'à 12 Mo de mémoire cache. Selon Intel, cette plate-forme offrira des performances améliorées et des économies d'énergie par rapport aux précédentes puces quatre coeurs. La dernière actualisation des processeurs pour serveur a été livrée en mars de l'année dernière, lorsque la société avait annoncé les Xeon série 5500 et 3500 basés sur l'architecture Nehalem et gravés en 45 nm. (...)

(05/03/2010 17:20:39)Microsoft mise tout sur le cloud, confesse Steve Ballmer

70% des 40 000 collaborateurs de Microsoft(*) qui travaillent sur les logiciels le font d'une façon ou d'une autre pour le cloud, a déclaré à Seattle hier, jeudi 4 mars, le PDG de la société, Steve Ballmer, devant un auditoire d'étudiants en informatique réunis à l'Université de l'Etat du Washington. Selon le patron américain, cette proportion sera passée à 90% dans un an. « Notre inspiration, notre vision... s'appuie sur le cloud. C'est le pari que nous faisons. Pour le cloud, nous sommes tous sur le pont. Littéralement, je vous dirai que nous avons misé notre groupe dessus ». Tous les produits de l'éditeur, incluant Windows, Office, la Xbox, Azure, Bing et Windows Phone, sont conçus avec l'idée d'une connexion au cloud, a-t-il poursuivi. Même si pour certains d'entre eux récemment livrés, comme Windows 7, il y a eu beaucoup de développements qui n'étaient pas liés aux services hébergés, l'inspiration autour du produit a démarré « avec le cloud ». Au-delà du logiciel, Ballmer a évoqué les différentes stratégies de Microsoft pour mettre au point des équipements qui se connectent à des services en ligne. « Le cloud a besoin de terminaux plus intelligents ». Il a reconnu que Microsoft a commis des erreurs dans sa façon d'aborder le marché de la mobilité, laissant aux fabricants trop de latitude sur le choix des formats de terminaux. « Nous n'avons pas suffisamment standardisé », ce qui a généré pour les utilisateurs une trop forte cacophonie autour des formats. Clouds publics/clouds privés Au Mobile World Congress de Barcelone, Microsoft a montré que la nouvelle version de sa plateforme mobile, Windows Phone 7, était plus stricte sur les pré-requis matériels. Malgré cela, a ajouté Steve Ballmer, le système d'exploitation devrait offrir aux fabricants davantage d'options pour innover face à des concurrents tels qu'Apple ou RIM. Avec ces derniers, on ne peut faire que « ce qu'ils ont choisi pour vous », a-t-il asséné. Le PDG précise que sa société recourt à la même stratégie pour sa console de jeu Xbox. Microsoft veut aussi encourager le développement de différents services de cloud computing, à la fois privés et publics. « Comment faire pour que le cloud ne soit pas quelque chose que seules Microsoft et quatre autres sociétés exploitent pour le compte de la planète entière ? Comment vous le rendre ? Vous devez, si vous le voulez, pouvoir exploiter votre propre cloud ». Dans certains cas, Microsoft peut avoir intérêt à aider à mettre en place un environnement hébergé, par exemple dans le cas d'un gouvernement souhaitant conserver ses données à l'intérieur de ses frontières. « Il y a peu de chance que notre société installe bientôt un cloud public en Slovénie, cite en exemple Steve Ballmer. En revanche, Microsoft pourra vendre un ensemble de produits construits autour de ses services de cloud Azure qu'un pays comme la Slovénie pourra acheter et mettre en place lui-même. [[page]] Accélérer l'innovation scientifique Les bénéfices potentiels du cloud computing sont énormes pour les entreprises et les chercheurs, considère le PDG de Microsoft. «Nous devons accélérer la cadence de l'innovation scientifique». En accédant à des services de cloud public, les chercheurs pourront analyser de plus importants volumes de données et accélérer leurs travaux, explique Steve Ballmer. Ce qui permettra, par exemple, de pouvoir avancer sur les questions de changements climatiques. Le cloud « va créer pour vous tous ici des opportunités de recherche et de projets », a-t-il lancé aux étudiants en ajoutant que le modèle hébergé créait aussi de nouvelles possibilités pour les entreprises. Le PDG pense voir apparaître encore de nouveaux modèles économiques suscités par « cette infrastructure logicielle qui n'existait pas jusqu'à présent ». Il cite l'exemple d'une société dont les ressources limiteraient sa capacité de services à une communauté locale. En utilisant une infrastructure en ligne, elle pourra offrir ses produits à une audience plus large, payant les services informatiques au fur et à mesure qu'elle les utilise, sans avoir à investir d'emblée dans un datacenter. Steve Ballmer suggère même que cela pourrait donner des idées aux développeurs en Open Source pour vendre ce qu'ils ont fait. « Avec l'apparition de ces nouvelles infrastructures commerciales, ces inventeurs peuvent maintenant se demander comment ils pourraient monétiser ce qu'ils ont fait », et tirer un revenu des innovations qu'ils ont créées. (...)

(15/02/2010 17:33:36)Avec Cyclone, SGI invite au calcul scientifique dans le cloud

Sous le nom de Cyclone, SGI vient de lancer une offre de cloud computing reposant sur ses technologies de supercalculateur et spécifiquement consacrée à des applications techniques et scientifiques. Le constructeur, racheté au printemps dernier par Rackable Systems, met ainsi à disposition une puissance de calcul à la demande qui s'exploite suivant deux modes. D'une part, les entreprises peuvent louer du temps de calcul pour faire tourner leurs propres applications sur les technologies HPC de SGI. D'autre part, elles peuvent accéder sur Cyclone à une quinzaine d'applications scientifiques parmi les plus utilisées dans le domaine de la mécanique des fluides et du calcul de structure (OpenFoam, Numeca, Acusolve, LS-Dyna), de la modélisation moléculaire (Gaussian, Gamess, Namd, Gromacs, Lammps), de la biotechnologie (Blast, Fasta, Hmmer, ClustalW) et du Web sémantique (OntoStudio). « Cette puissance de calcul à la demande répond à des besoins bien identifiés, explique Patrice Gommy, directeur marketing de SGI France. Elle vise à la fois les entreprises qui ne peuvent pas investir dans des technologies de supercalculateur et celles qui sont déjà équipées mais qui, pour une étude particulière, doivent accéder à une puissance 'pic' à un moment donné ». Un service tarifé un dollar l'heure de processeur HPC L'heure de calcul sur Cyclone est facturée un peu moins d'un dollar par processeur. Sur cette base, on peut estimer par exemple qu'il en coûtera mille dollars pour exploiter en environnement HPC la capacité de mille processeurs pendant une heure. Les offres de calcul à la demande existent depuis longtemps. Mais, « jusqu'à présent, la puissance de calcul en ligne était généralement réservée à certains utilisateurs, dans certains centres de recherche notamment », précise Patrice Gommy. Avec cette offre de cloud, toute entreprise peut maintenant y accéder. A noter qu'en France, Bull prévoit lui aussi de lancer cette année des services de calcul à la demande sur HPC dans le cloud. Voilà déjà quelques années que SGI pensait à fournir ce type de service. Le rapprochement avec Rackable Systems, spécialistes des datacenters, a accéléré le mouvement. « Nos technologies sont très complémentaires », souligne le directeur marketing de SGI France, qui rappelle que les datacenters de Google, Youtube et Facebook reposent sur les serveurs de Rackable, de même que les cloud Azure de Microsoft et EC2 d'Amazon. Mémoire partagée, mémoire distribuée et clusters GPU Quant à la technologie SGI utilisée pour Cyclone, elle va permettre d'accéder à trois types d'architecture, explique Patrice Gommy. Suivant la nature de ses applications, le client retiendra celle qui lui apportera des performances optimisées. «Pour les applications ayant d'importants besoins en mémoire (de 1à 4 To), les clients s'appuieront sur une machine SMP à mémoire partagée, typiquement, par exemple, dans le domaine de la modélisation moléculaire.» A l'inverse, si la nature de l'application requiert plutôt d'optimiser les échanges entre processeurs, Cyclone propose des architectures à mémoire distribuée avec des noeuds de clusters interconnectés en technologie QDR Infiniband ou Gigabit Ethernet. Par ailleurs, Cyclone va aussi permettre aux entreprises qui le souhaitent de tester leurs applications avec des processeurs graphiques, dans une architecture hybride, connectant un cluster classique à des clusters de type GPU. Conçus pour le traitement de l'image et la visualisation, les GPU apportent dans certains cas des puissances de calcul très supérieures aux processeurs classiques pour autant que les applications aient été redéveloppées pour en tirer parti. « Mais toutes ne s'y prêtent pas, rappellent Patrice Gommy. Certains clients prêts à investir sur ce terrain nous ont donc demandé, auparavant, de leur mettre à disposition des architectures de types GPU afin d'y valider leurs applications ». Cette offre de cloud computing repose sur deux datacenters installés aux Etats-Unis, l'un situé en Californie, au siège de SGI, l'autre dans le Wisconsin. (...)

| < Les 10 documents précédents | Les 10 documents suivants > |