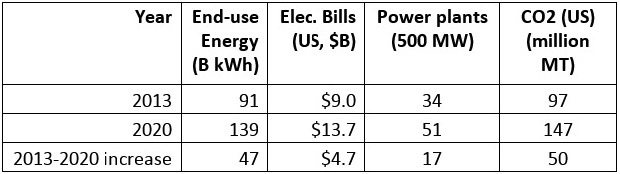

Les datacenters installés sur le sol américain consomment trop d'électricité, et plus qu'ils n'en ont besoin. Aujourd'hui, il faut 34 centrales électriques de 500 mégawatts pour alimenter l'ensemble des datacenters en fonctionnement aux États-Unis. Selon les prévisions, en 2020, pour accompagner une activité économique toujours plus dépendante du numérique, il faudra 17 centrales supplémentaires de taille équivalente pour répondre à ces nouveaux besoins en énergie. Et pour produire plus d'électricité, il faudra consommer plus de combustibles fossiles, ce qui signifie donc une augmentation des émissions de gaz à effet de serre. Mais, selon un nouveau rapport sur l'efficacité énergétique des datacenters publié par la National Resources Defense Council (NRDC), une association de défense de l'environnement, ce surcroit de pollution n'est pas une fatalité. Au total, en 2013, les datacenters installés sur le territoire américain ont consommé 91 milliards de kilowatts-heures, et ils consommeront 139 milliards de kilowatts-heures en 2020, soit une augmentation de la consommation de 53 %.

Le graphique ci-dessus montre l'utilisation estimée d'énergie (en milliards de kilowatts-heures), et le coût de l'énergie utilisée par les datacenters aux États-Unis en 2013 et en 2020, avec le nombre de centrales électriques nécessaires pour répondre à la demande. La dernière colonne indique les émissions de dioxyde de carbone (CO2) en millions de tonnes (Source : NRDC).

Selon le rapport de la NRDC, en améliorant l'efficacité énergétique des centres de calcul, il serait possible de réduire le gaspillage d'énergie d'au moins 40 %. L'association a listé les freins à l'efficacité énergétique : les serveurs dits « comateux » ou serveurs fantômes, qui consomment de l'énergie sans exécuter un quelconque travail ; le sur-provisionnement des ressources informatiques ; le recours insuffisant aux solutions de virtualisation ; des modèles d'approvisionnement qui ne prennent pas en compte la question de l'efficacité énergétique. « Typiquement, un serveur n'utilise pas plus de 12 % à 18 % de sa capacité, et 30 % des serveurs sont des serveurs fantômes », affirme le rapport.

Les géants du cloud parmi les plus efficaces

La NRDC s'est intéressée aux conséquences de l'inefficacité énergétique des datacenters au niveau national et a demandé à plusieurs entreprises, dont Microsoft, Google, Dell, Intel, The Green Grid, Uptime Institute et Facebook d'examiner ses résultats. « Ces échanges ont donné lieu à des contributions techniques importantes », a précisé l'association. Dans son rapport, le NRDC fait une nette distinction entre les grands datacenters gérés par les grands fournisseurs de cloud, dont la consommation d'énergie ne représente que 5 % de la consommation totale des datacenters, et les petits centres de calculs, moins efficaces. Le secteur offre « de nombreux exemples de centres de calcul ultra-efficaces », note le rapport. Ajoutant que « ceux-ci ne posent pas de problème ». Mais « ce sont les milliers d'autres, utilisés par les entreprises commerciales et l'administration, et les petits datacenters, corporate ou multi-propriétaires, qui posent problème », fait valoir le document.

Les efforts accomplis par les grands fournisseurs de cloud en matière d'efficacité énergétique « conduisent à imaginer que le problème est en grande partie résolu », a déclaré Pierre Delforge, directeur du département chargé de suivre l'efficacité énergétique du secteur high-tech à la NRDC, « mais cela ne correspond pas à la réalité, car il faut prendre en compte la totalité des centres de calcul ». Les datacenters sont « l'un des rares gros secteurs industriels où la consommation électrique augmente », a ajouté Pierre Delforge. « Cette augmentation de la consommation électrique des datacenters pousse la demande, laquelle se traduit par la création de nouvelles centrales électriques dans certaines régions », a-t-il ajouté.

La colocation pose problème

Pour les entreprises qui choisissent la colocation, les centres de calcul multi-tenant ne sont pas forcément synonymes d'efficacité. Le système de tarification de ces services est basé sur l'occupation, le nombre de racks ou la superficie, plus une limite sur la quantité d'énergie au-delà de laquelle le client doit payer des frais supplémentaires. Ce modèle n'incite pas à utiliser l'équipement de manière aussi efficace que possible. Selon le rapport, l'an dernier, la totalité des datacenters installés sur le sol américain ont consommé 91 milliards de kilowatts-heures, « soit deux fois plus, et avec de la marge, que la quantité nécessaire à alimenter tous les habitants de New York en électricité ». Selon les estimations, en 2020, la consommation annuelle des datacenters devrait atteindre 140 milliards de kilowatts-heures.

« Si les entreprises adoptaient de meilleures pratiques énergétiques dans les datacenters, les avantages économiques seraient considérables », estime encore le rapport de la National Resources Defense Council. Une réduction de 40 % de la consommation d'énergie permettrait aux entreprises d'économiser 3,8 milliards de dollars. Et selon le rapport, une réduction de 80 % est techniquement possible. L'étude constate également que l'effort pour améliorer l'efficacité énergétique progresse peu. Mises à part certaines initiatives évidentes, comme l'isolement des allées chaudes et froides, les investissements supplémentaires pour améliorer l'efficacité énergétique sont plus difficiles à justifier, soit à cause du coût, soit parce que les gestionnaires IT craignent que certaines mesures ne contribuent à augmenter le risque. Les responsables informatiques sont « extrêmement prudents » et rechignent à mettre en oeuvre des programmes contraignants de gestion de l'énergie parce qu'ils redoutent un effet négatif sur la disponibilité », note le rapport.

L'Europe incite aussi à l'amélioration de ses datacenters

Plusieurs indicateurs permettent de mesurer l'efficacité énergétique des datacenters, et le rapport recommande le développement d'outils pour surveiller l'usage du processeur, estimer l'usage moyen des serveurs et du datacenter. Selon la NDRC, « une généralisation de ces mesures simples permettrait d'avoir une meilleure visibilité sur l'efficacité énergétique, et inciterait davantage les opérateurs à optimiser l'usage de leurs ressources IT ». L'association n'est pas la première à se pencher sur la question. En 2007, l'Agence de protection de l'environnement américaine avait travaillé sur le sujet avec un grand nombre d'opérateurs de datacenters et de groupements industriels. Le rapport sur la consommation d'énergie des datacenters publié à l'époque avait établi qu'entre 2000 et 2006, la consommation d'électricité des serveurs et des centres de calculs avait plus que doublé et l'agence appelait déjà à l'amélioration de l'efficacité énergétique des centres de calcul.

L'arrivée prochaine d'une taxe carbone en Europe et la nécessité d'abaisser la consommation des datacenters qui se multiplient comme des petits pains ont amené le CRIP (Club des Responsables d'Infrastructure et de Production) et la CTO Alliance à travailler sur un indicateur du nom de DCEM (Data Centre Energy Management) capable de benchmarker les différents types de datacenters en Europe et d'enterrer par la même occasion le très décrié PUE, très utilisé par les anglo-saxons, puisqu'il permet d'afficher des notes flatteuses en simulant la pleine charge.

Datacenters, les nouveaux pollueurs ?

1

Réaction

Selon une étude réalisée par une association américaine de défense de l'environnement, les responsables informatiques ne prennent pas assez d'initiatives pour gérer la dépense énergétique et les entreprises ne sont pas disposées à investir au-delà d'un certain seuil pour améliorer leur consommation électrique.

Newsletter LMI

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire

Suivre toute l'actualité

Newsletter

Recevez notre newsletter comme plus de 50 000 professionnels de l'IT!

Je m'abonne

-Point de vue économie d'énergie, le nouveau super ordinateur HP Apollo 8000 est remarquable.

Signaler un abus-On devrait interdire le bitcoin mining, gouffre à énergie qui ne rend aucun service utile.