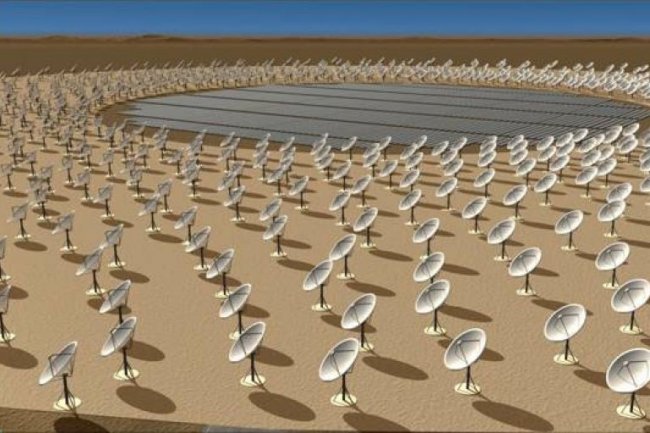

« Il s'agit d'un projet de recherche pour savoir comment construire un système informatique pour traiter 1 exabyte de données par jour » explique Ton Engbersen, un chercheur d'IBM qui travaille sur le projet SKA (Square Kilometre Array). La Hollande a alloué une subvention de 32,9 millions d'euros sur 5 ans à IBM et Astron, l'institut néerlandais de radioastronomie pour concevoir un système IT capable de traiter des quantités massives de données générées par SKA. Financé par un consortium de 20 organisations gouvernementales, SKA (Square Kilometre Array) sera le plus grand radiotélescope de radioastronomie au monde et doit apporter des éclairages sur le Big Bang qui a eu lieu il y a 13 milliards d'années. SKA sera composé de 3 000 petites antennes diffusant un flux continu de données.

Une fois opérationnel en 2024, le télescope va produire plus d'une exaoctet de données par jour (un soit1 milliard de Go). A titre de comparaison, ce volume représente à deux fois la totalité du trafic quotidien sur le web, précise IBM. Les données seront téléchargées depuis le télescope, qui sera basé soit en Australie ou en Afrique du Sud, pour ensuite les compresser et les diffuser dans le monde entier. L'analyse des données permettra de reconstituer à partir des informations des antennes une grande image sur la création de l'univers.

Penser à l'évolution matérielle en créant le système

Ton Engbersen, souligne que même en prenant en compte la performance et la puissance des ordinateurs en 2024, IBM aura encore besoin d'autres technologies pour traiter ces données. Un tel ordinateur pourrait par exemple utiliser des puces empilées avec des interconnexions photoniques entre les processeurs, d'autres systèmes de bandes pour le stockage et des technologies de mémoire à changement de phase pour la conservation des données à traiter.

« Nous devons pousser nos efforts sur la conception du système » a déclaré Ton Engbersen. Les chercheurs n'ont pas encore pris de décision pour savoir si le système devait être centralisé sur un site ou ventilé sur plusieurs sites. Etant donnée la taille du système, les scientifiques s'interrogent sur la meilleure utilisation des composants matériels et leur consommation d'énergie. Ils doivent également adapter les algorithmes de traitement de données à cette configuration spécifique. Après traitement, le volume de données produites sera compris entre 300 et 1 500 Po chaque année. A titre de comparaison, le LHC (grand collisionneur de hadrons) du CERN produit chaque année environ 15 Po de données.

IBM va traiter les big data d'un radiotélescope dédié au Big Bang

0

Réaction

IBM développe un système de gestion de données et d'analyse pour ce qui sera le plus grand radiotélescope du monde. Le Square Kilometre Array (SKA), devrait être opérationnelle en 2024. Le système IT doit être capable de traiter un milliard de Go par jour.

Newsletter LMI

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire