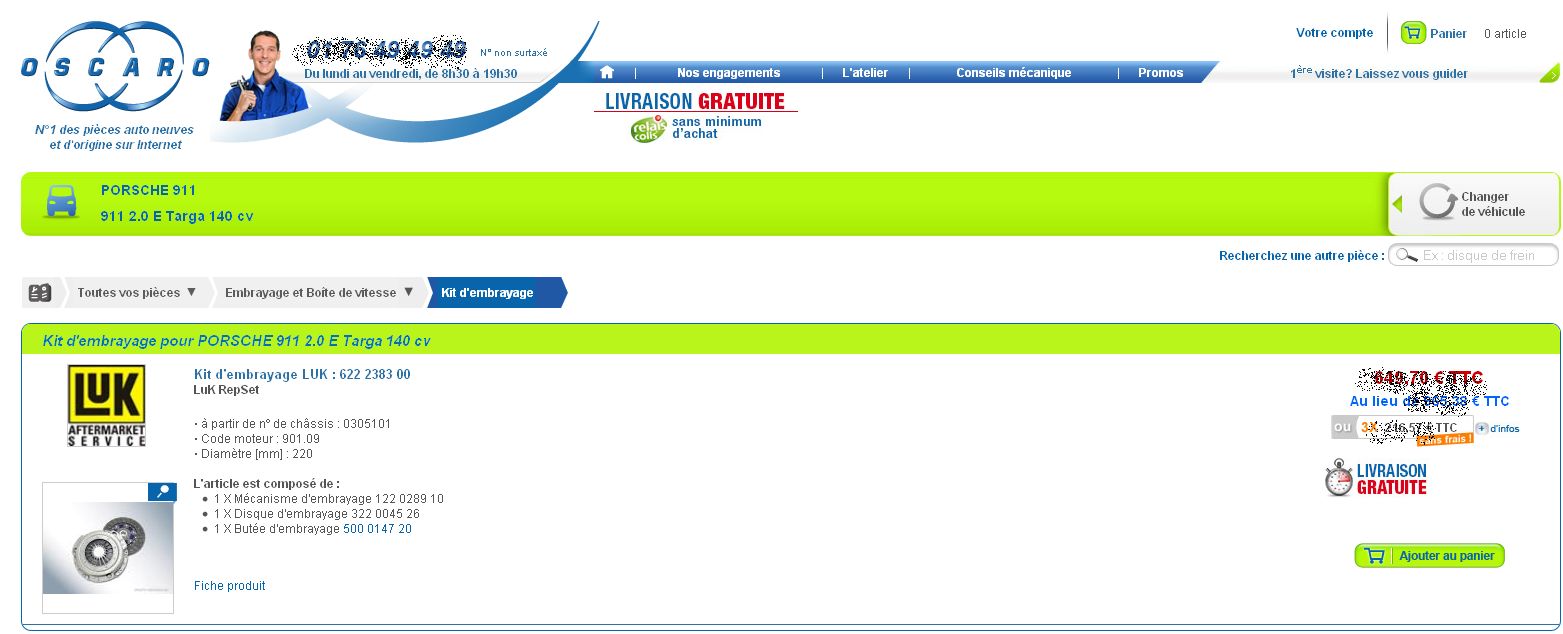

Le site de vente en ligne Oscaro.com propose plus de 530 000 pièces détachées automobiles neuves et d’origine sur Internet, rattachées unitairement à plus de 70 000 modèles de véhicules, soit une offre de plus de 21 millions de montages pièce/véhicule. Pour mettre à jour ce catalogue, la société française a constitué une équipe de mécaniciens experts chargés de vérifier et certifier que les pièces proposées peuvent bien être montées sur les différents modèles de voiture. Il y a un an, pour renforcer le service au client, l’e-commerçant a décidé de croiser ce catalogue avec les données de navigation de son site afin de permettre aux équipes ventes et marketing d’effectuer des analyses détaillées.

En dehors de la France, Oscaro.com est présent en Espagne, en Belgique et aux Etats-Unis. Il a réalisé en 2014 un chiffre d'affaires de 300 M€.

Ce projet nécessitait de disposer d’une solution efficace pour traiter les volumes de données ainsi générés qui représentent environ 5 To par an. L’équipe informatique s’est appuyée sur un tryptique Hadoop/BigQuery/BIME. Pour le tracker destiné à récupérer les événements de navigation web, l’équipe informatique a retenu la version Open Source du logiciel WT1 (développé par l’éditeur français Dataiku), qu’elle a un peu modifiée pour l’adapter à ses besoins. Du côté de la plateforme Hadoop, mise en place pour y déverser les données, elle a également choisi la version Open Source du framework. « Nous ne voulions pas de distribution, nous préférions maîtriser l’ensemble de notre stack big data », explique Romain Nio, responsable de l’équipe Data chez Oscaro.com. « Hadoop nous sert de zone de stockage sécurisée et répliquée et nous permet de traiter toutes les données ».

80 sources de données agrégées

Un cluster Hadoop interne de dix serveurs a été installé, alimenté par près de 80 sources de données. Pour l’équipe informatique, la première étape a consisté à dimensionner de façon optimale la mémoire utilisée pour chacun des traitements opérés. En dehors des données de navigation brutes issues du tracker web sont versées dans le cluster les données gérées dans l’ERP de la société (Dynamics AX de Microsoft), mais aussi celles du centre d’appels (temps d’attente, type de renseignements fournis…), celles du transporteur sur la livraison des colis ou encore, par exemple, les retours des enquêtes de satisfaction restitués par un prestataire (notes attribuées aux commandes). Il s’agit uniquement de données structurées qui, après avoir été descendues dans Hadoop, sont agrégées au moyen de scripts. Certaines d’entre elles sont ensuite transférées dans le service web BigQuery, disponible dans le cloud de Google, pour permettre aux analystes d’effectuer très rapidement des requêtes sur d’importants volumes de données en utilisant le langage SQL (ou, pour certains, par le biais d’extractions programmées en Python).

En complément à BigQuery, Oscaro.com utilise le logiciel d’analyse et de visualisation de la start-up française BIME pour permettre à différents utilisateurs métiers d’explorer aussi les données, sans devoir passer par SQL, et de disposer de tableaux de bord. Pour l’instant, ce sont les services ventes et marketing qui en bénéficient, mais à terme, tous les utilisateurs qui gèrent des projets sur Oscaro.com pourront recourir à l’outil, avec une gestion des droits d'accès qui garantira un cloisonnement des informations en fonction des profils. « BIME permet de croiser les données assez facilement. Il se pluggue sur BigQuery pour nous permettre, par exemple, de réaliser des analyses temporelles, en comparant des ventes de familles de produits dans le temps », explique François Dumarest, chef de projet Pricing chez Oscaro.com. « Il est très facile de choisir sa catégorie de produits, BIME voit les liens entre les différentes catégories. On peut avoir une vision d’ensemble et zoomer en entrant dans la catégorie. On peut aussi voir les sources de notre trafic, que tel pourcentage des utilisateurs sont arrivés sur une page donnée et décomposer la session d’une personne, déterminer s’il s’agit d’un nouveau ou d’un ancien client et suivre son évolution, gérer les coupons », indique le chef de projet. Les utilisateurs accèdent ainsi à des données très détaillées et peuvent analyser les performances liées au trafic web, les coûts d’acquisition par canal (par exemple les internautes qui sont passés par des adwords), mais aussi les marges produits, les données logistiques des transporteurs, celles du centre d’appels, etc. Des tableaux de bord ont également été mis en place pour partager les informations avec les autres équipes et l’outil présente différents types de visualisation comme le Sunburst, qui hiérarchise les données sous la forme d’un graphique sectoriel circulaire.

BIME, une solution SaaS utilisée d'abord par la IT

Pour retenir BIME, le e-commerçant a sélectionné parmi les partenaires de BigQuery (qui comptent aussi Qlik et Tableau) la solution qui répondait le mieux à son utilisation. « Le produit est full SaaS et facile à implémenter », note François Dumarest. Son prix a aussi joué en sa faveur. Après avoir démarré sur une ancienne version du logiciel qui n’était pas en HTML 5, Oscaro.com est rapidement passé à une bêta de la version actuelle transmise par l’éditeur. « Cela correspondait parfaitement à nos besoins », indique le chef de projet Pricing. « BIME s’adresse aux utilisateurs finaux qui ne savent pas requêter en SQL, mais il permet aussi d’explorer les données dans BigQuery pour voir s’il y a des manques, des trous temporels ». Ainsi, avant de le proposer comme outil de BI, l’équipe informatique s’est servie de BIME au démarrage du projet pour faire apparaître les incohérences dans les remontées de données et vérifier leur propreté. En fait, BIME a facilité l’intégration de BigQuery. « On voit les données comme jamais, ce qui nous a permis de déceler des bugs cachés, de plus haut niveau, par exemple dans la gestion des commandes dans l’ERP ».

A l’avenir, l’équipe informatique d’Oscaro.com prévoit de gérer son cluster Hadoop dans le cloud « pour bénéficier d’une puissance machine décuplée lorsque nous en aurons besoin », indique Romain Nio. Pour l’instant, les données sont versées dans Hadoop en mode batch. « Mais nous avons un projet de temps réel », précise le responsable Data. « Nous utilisons un projet de Google, DataFlow, ainsi que PigPen publié sur GitHub par Netflix, un outil de haut niveau qui encapsule Pig ». PigPen (Map-Reduce for Clojure) est un langage de programmation fonctionnelle qui permet d’obtenir du code compréhensible par Hadoop. L’équipe d’Oscaro a de son côté développé un interpréteur qui permettra d’utiliser le code écrit avec PigPen sur DataFlow (un outil publié sur GitHub) afin de pouvoir, à terme, basculer toute son architecture technique dans le cloud sans modification. « Cela permettra d’instancier des machines à la demande dans le cloud de Google pour une heure en cas de besoin». Et de ne plus avoir d’architecture technique à gérer en interne.

Commentaire