Flux RSS

SGBD

377 documents trouvés, affichage des résultats 21 à 30.

| < Les 10 documents précédents | Les 10 documents suivants > |

(30/11/2011 10:03:50)

HP combine Autonomy et Vertica pour traiter toutes les données

Hewlett-Packard a rapidement mis à profit ses récentes acquisitions, Vertica racheté en mars dernier et Autonomy en octobre, en rassemblant ces deux logiciels dans une seule solution baptisée Next Generation Information Platform. Avec cette offre disponible fin janvier, les utilisateurs pourront rechercher et analyser des données structurées et non structurées, a expliqué Mike Lynch, ancien CEO d'Autonomy et désormais en charge de l'entité Information Optimization Business Solutions chez HP, lors de l'événement Discover 2011 à Vienne, un rendez-vous qui mêle infrastructures et solutions logicielles.

La plate-forme Vertica Analytics est un logiciel dédié au stockage et à l'analyse de très grandes quantités de données structurées, ou de données qui ont été stockées dans une base de données relationnelle. La solution Autonomy IDOL (Intelligent Data Operating couche) peut quant à elle indexer les données non structurées au sein d'une entreprise, et fournir aux utilisateurs une interface de recherche.

IDOL arrive dans sa version 10

HP propose aujourd'hui une mise à jour de la solution d'Autonomy, IDOL 10, optimisée pour les plates-formes serveurs maison Proliant, et qui inclut un ensemble de liens qui lui permettent de s'intégrer plus facilement avec Vertica. IDOL, dans sa version 10, sera disponible le 1er décembre, et offrira aux utilisateurs la possibilité de travailler avec des données structurées stockées dans la base de données Vertica. Si la force d'Autonomy repose sur ses capacités de traitement de données texte, audio et vidéo, Vertica apporte en sus les ressources d'une base de données en colonnes et des capacités analytiques.

L'interface de recherche unifiée pourrait se montrer particulièrement utile pour afficher dans un seul flux une synthèse reposant sur des données structurées et non structurées. Dans les entreprises, ces informations sont généralement traitées par des systèmes distincts. Par exemple, les informations issues de réseaux sociaux tels que Twitter, qui sont généralement capturées en tant que données non structurées, pourraient être explorées en utilisant les fonctionnalités graphiques et analytiques de Vertica. Les flux vidéo et audio qui peuvent être tous deux ingérés par IDOL, pourraient être couplés avec les données liées à des événements historiques stockés dans Vertica pour fournir un suivi en temps réel. À titre d'exemple, une banque pourrait suivre une conversation téléphonique avec un client qui demande un crédit et certains mots clefs analysés par Autonomy pourraient déclencher une alerte dans Vertica. Si lors de cette conversation, l'appelant laisse échapper quelque chose qui pourrait indiquer un risque élevé, la société de crédit pourrait être immédiatement alertée par la fonction d'analyse de Vertica, nous a expliqué un responsable de HP.

Une base de données as a service pour Heroku de Salesforce.com

Heroku, filiale de Salesforce.com, vient de lancer sa base de données à la demande qui s'appuie sur le projet Open Source PostgreSQL. « Heroku Postgres a traité avec succès et en toute sécurité 19 milliards de transactions, et 400 millions de transactions supplémentaires sont traitées chaque jour, » a déclaré Heroku dans un blog. « Les clients qui utilisent le service peuvent se concentrer sur leurs tâches de développement d'applications, plutôt qu'à l'administration des bases de données, » a ajouté Heroku. L'option vient enrichir le service Database.com annoncé précédemment par Salesforce.com, qui ouvre l'accès de sa plateforme de développement Force.com à une infrastructure de bases de données.

Acquis par Salesforce.com l'an dernier, Heroku a hérité d'une participation significative dans le web et le développement d'applications pour les consommateurs, avec des objectifs semblables à ceux visés par Force.com dans le domaine des logiciels d'entreprise. Ceux qui choisissent Heroku Postgres seront « protégés de façon permanente » d'une panne de leurs bases de données, précise le message du blog. Le système « crée plusieurs copies, distribuées géographiquement, et prend en compte tous les changements au fur et à mesure de l'écriture des données, » indique encore le blog. « Et si un météorite anéantissait la côte Est, vous ne perdriez pas vos données ! » Heroku Postgres utilise une version standard, non modifiée, de PostgreSQL. « Tout client libpq peut tourner sans problème sur notre service. Et si jamais vous décidiez de revenir à votre propre DBA, c'est possible. Aucun verrouillage ne vous l'empêchera. »

Renforcer l'intérêt et fédérer autour de PostgreSQL

L'annonce pourrait avoir des conséquences positives pour PostgreSQL en général, comme l'a fait remarquer un observateur. « PostgreSQL est une technologie honorable et populaire à juste titre, même si MySQL a réduit l'écart technique, » a déclaré l'analyste Curt Monash de Monash Research. « PostgreSQL a manqué du support d'une communauté, qui apporte cohésion et pragmatisme au projet, ou d'un coach corporate efficace. Peut-être que la mise en place d'un ou plusieurs services cloud pourront combler l'écart. » VMware a également lancé il y a peu de temps un forfait basé sur PostgreSQL pour les déploiements cloud. Et au mois d'août dernier EnterpriseDB avait annoncé une version cloud de sa base de données avec des couches de fonctionnalités supplémentaires écrites en code Open Source PostgreSQL.

La tarification de Heroku Postgres commence à 200 dollars par mois pour 1.7 Go de cache, pour atteindre 6 400 dollars par mois pour 68 Go de cache. Toutes les bases sont livrées avec une capacité de stockage de 2 To, un monitoring 24/24, des instantanés quotidiens et un accès depuis n'importe quel client PostgreSQL. Comparativement, Database.com est gratuit pour un petit nombre d'utilisateurs et de données. Une fois ces limites dépassées, le prix pour les utilisateurs, les données et le nombre de transactions sont établis sur une base évolutive. « Si vous voulez une base de données classique, l'offre de PostgreSQL est plus logique que Database.com, » a déclaré Curt Monash. « Mais si vous êtes intéressé par toute la pile Force.com, alors Database.com s'avère être une bonne option. »

Hadoop World 2011 : la sécurité et le contrôle d'accès aux données agrégées en question

Cette semaine, lors de la conférence Hadoop World (du 8 au 9novembre à NY), analystes et responsables informatiques ont appelé les dirigeants des entreprises de technologie à se montrer vigilants avant d'utiliser Hadoop pour agréger des données provenant de multiples sources disparates, les mettant en garde contre des problèmes potentiels de sécurité. Le framework Java Open Source Hadoop permet aux entreprises de collecter, d'agréger, de partager et d'analyser d'énormes volumes de données structurées et non structurées, des données stockées par l'entreprise, ou provenant de blogs, de transactions en ligne ou encore résultant des échanges au sein de médias sociaux.

De plus en plus d'entreprises utilisent Hadoop et des technologies connexes comme Hive, Pig et Hbase pour traiter leurs données. En partie parce qu'elles ne peuvent pas le faire facilement et à coût raisonnable avec les bases de données relationnelles traditionnelles. JPMorgan Chase, par exemple, utilise Hadoop pour améliorer la détection des fraudes, pour gérer certains risques informatiques et les applications en self-service. Le groupe financier l'utilise également pour avoir un point de vue beaucoup plus global sur sa clientèle, comparé à ses outils précédents, comme l'ont déclaré ses dirigeants. Ebay a aussi utilisé la technologie Hadoop et la base de données Open Source Hbase pour élaborer un nouveau moteur de recherche pour son site de vente aux enchères.

Attention aux problèmes de sécurité

Les analystes estiment que les services informatiques qui utilisent le framework Hadoop pour ce type d'applications doivent être conscients des problèmes de sécurité potentiels qu'elle pose. « L'utilisation de la technologie Hadoop pour agréger et stocker des données provenant de sources multiples peut générer une série de problèmes liés au contrôle d'accès et à la gestion, mais aussi au droit et à la propriété des données, » a déclaré Larry Feinsmith, directeur général des opérations IT chez JPMorgan Chase. « Dans les environnements Hadoop, on peut trouver des données de niveau et de sensibilité différentes, en matière de classification et de sécurité, » a renchéri Richard Clayton, ingénieur informatique chez Berico Technologies, un fournisseur de services informatiques pour les agences fédérales.

« Le défi pour les entreprises est de s'assurer qu'elles ont mis en place des contrôles de sécurité adaptés, qui maintiennent le niveau d'accès aux données, » a-t-il ajouté. « L'agrégation des données dans un environnement unique augmente également le risque de vol ou d'une divulgation accidentelle, » a déclaré Richard Clayton. Surtout, l'analyse des données agrégées dans un environnement Hadoop par des applications peut se traduire par la création de nouveaux documents qui ont peut-être aussi besoin d'être protégés. « De nombreuses organisations gouvernementales stockent leurs données Hadoop dans des «enclaves» distinctes, afin d'avoir l'assurance qu'elles ne seront accessibles qu'à ceux qui en ont l'autorisation, » a ajouté l'ingénieur de Berico Technologies. « La plupart des agences ne mettent pas leurs données sensibles dans des bases de données Hadoop, en raison de problèmes d'accès aux données, » a encore ajouté l'ingénieur. « Plusieurs agences ont tout simplement mis en place des pare-feu pour protéger leurs environnements Hadoop, » a-t-il expliqué.

[[page]]

« Pour de nombreux utilisateurs de Hadoop, l'approche la plus efficace en matière de sécurité consiste à crypter les données au premier niveau, quand celles-ci transitent ou sont stockées dans un environnement Hadoop, » a encore déclaré l'ingénieur. D'une manière générale, celui-ci conseille aux entreprises d'être prudentes quand elles utilisent ces technologies. Il fait remarquer que, utilisées seules, certaines fonctionnalités de sécurité du système de fichiers distribués intégré de Hadoop - Hadoop Distributed File System (HDFS) - comme les listes de contrôle d'accès (Access Control Lists) et les Kerberos ne sont pas adaptées à un usage en entreprise.

Selon David Menninger, analyste chez Ventana Research, « les problèmes de la sécurité et de contrôle d'accès justifient le fait qu'Hadoop n'est pas prêt à remplacer les bases de données relationnelles dans l'entreprise. » Pour Sid Probstein, directeur des technologies chez Attivio, qui vend des technologies de gestion d'accès unifié dans les environnements Big Data, « Hadoop est une technologie formidable, mais il lui manque certains éléments pour être utilisé en entreprise. »

(...)(27/10/2011 12:24:03)Les entreprises incapables d'analyser 90% de leurs données, selon IBM

D'après Jeff Jonas, chercheur responsable de l'Entity and Analytics Group d'IBM, « à mesure que les ordinateurs deviennent plus rapides, les entreprises deviennent plus bêtes - aujourd'hui, elles ont la chance de bien comprendre 7% de leurs données, mais cela ne va pas durer. » Avant de se retrouver chez Big Blue, Jeff Jonas dirigeait SRD, une entreprise qui fournissait des systèmes aux casinos, et acquise en 2005 par IBM.

La multinationale américaine voudrait pousser les entreprises vers des solutions de gestion de données avant que la quantité de données générées ne se retrouve hors de contrôle pour la plupart d'entre elles. Pour cela, elle veut proposer aux services informatiques de s'appuyer sur sa solution de gestion et d'analyse des données de type BigData et ses solutions d'analytiques portées dans le cloud et pour mobiles, pour l'accès aux données.

Pour Sarah Diamond, d'IBM Global Business Services, « les banques devraient pleinement adopter les programmes de transformation de données pour satisfaire les régulateurs et offrir plus de croissance à leurs investisseurs. » Selon elle, « la crise dans le secteur des services financiers s'est prolongée, et le FMI considère qu'il a déjà effacé 2 200 milliards de dollars de créances douteuses et autres pertes. » Sarah Diamond affirme que « la transformation est devenue une nouvelle «norme», les silos de données et les tableurs ne suffisant plus pour gérer ses datas. » Ajoutant que « les entreprises doivent offrir de la transparence pour satisfaire les autorités règlementaires et créer de la croissance. »

Pendant cette semaine de conférence, IBM va en profiter pour donner plus de contenu à sa stratégie de gestion de données. La technologie BigInsights de l'offre SmartCloud de Big Blue vise à aider les clients à donner du sens aux masses de données non structurées provenant de diverses sources, y compris les réseaux sociaux et les appareils mobiles. Si l'on estime que 80 % des datas d'une entreprise sont des données non structurées, on comprend la difficulté à les gérer et à les interpréter pour un usage professionnel.

L'application IBM Cognos Mobile pour iPad inaugure aussi le support pour appareil mobile, et le logiciel SPSS Statistics 20.0 (voir illustration principale) intègre une fonction de cartographie qui permet aux utilisateurs d'ajouter une dimension géographique à l'analyse de données et au reporting. Grâce à cette fonction, ils pourront cibler, faire des prévisions et des prospections par zones géographiques.

(...)(26/10/2011 11:58:03)

IBM critique l'acquisition d'Autonomy par HP

Dixit IBM, HP devra « lutter » pour réussir à intégrer les solutions de gestion de l'information de l'éditeur Autonomy et les ressources combinées des deux sociétés ne seront pas une menace sérieuse pour ses offres de gestion et d'analyse des données. Cette déclaration a été rapportée par notre confrère de ComputerWorld UK, Antony Savvas, à l'occasion de la sixième édition de l'événement Information On Demand (IOD) d'IBM (du 23 au 27 octobre à Las Vegas). 10 000 clients et partenaires étaient attendus sur ce salon dédié aux solutions de gestion des données de Big Blue.

Interrogé à cette occasion sur l'impact attendu suite au rachat d'Autonomy par HP, Steve Mills, senior vice-président en charge de l'activité logiciels et systèmes d'IBM, a été particulièrement critique. M.Mills a ainsi déclaré: « Ça va être dur pour HP d'exploiter Autonomy et obtenir un retour sur investissement, ils ont dépensé beaucoup d'argent pour ça [cette acquisition] et il n'y a aucune certitude quant à ce retour. (...) Nous étions déjà en compétition avec Autonomy sur ce marché avant l'acquisition et faire partie de HP sera ou ne sera pas une difficulté pour eux. »

Une course frénétique aux acquisitions

HP a récemment finalisé l'acquisition d'Autonomy pour un montant de 11,7 milliards de dollars et même IBM a récemment acquis l'éditeur canadien d'analyses de risques Algorithmics, qui travaille notamment avec HSBC et Société Générale, pour un montant plus modeste, 387 millions de dollars. Steve Mills a indiqué sur ce dernier point : « Nous sommes un peu plus réfléchi quant à la façon de dépenser l'argent des actionnaires ! »

Cela dit, ces dernières années IBM a effectué une vingtaine d'acquisitions dans le domaine de la gestion de l'information et de l'analyse des données. La firme d'Armonk estime d'ailleurs qu'elle est sur la bonne voie pour capter une bonne partie d'un marché estimé à 16 milliards de dollars en 2015.

Oracle toujours dans le collimateur d'IBM

La compétition avec le duo HP / Autonomy n'était pas la seule cible d'IBM lors de cette discussion avec le dirigeant d'IBM, Oracle est également venu sur le tapis. A la question de savoir si le nombre d'inscrit à événement IOD n'était pas plutôt modeste par rapport aux 45 000 personnes qui participent tous les ans à la manifestation OpenWorld, Arvind Krishna, directeur général d'IBM en charge de l'activité gestion de l'information, a rejeté la comparaison. « Alors qu'Oracle a choisi d'organiser un grand événement, nous avons cinq manifestations différentes qui se concentrent sur des domaines différents : cet événement IOD, la conférence Impact, Lotusphere, Rational et Tivoli, et nous pensons que cela fonctionne beaucoup mieux ainsi. »

Arvind Krishna, directeur général d'IBM en charge de l'activité gestion de l'information

Pendant la keynote d'Arvind Krishna, Curt Cotner, employé au sein de la division gestion de l'information d'IBM, a tapé sur les capacités de traitement des bases de données d'Oracle, indiquant que le nombre de coeurs et processeurs utilisés dans les résultats publiés par l'éditeur de Redwood était «incertain».

Un autre dirigeant d'IBM dans le New Hampshire, qui a préféré resté anonyme, a également cogné sur Oracle en affirmant à notre confrère de ComputerWorld UK : « Nous sommes meilleurs quant à l'intégration de technologies issues d'entreprises que nous avons achetées, il suffit de regarder Oracle, ils ont parlé de « Fusion » pendant des années après les acquisitions de PeopleSoft et JD Edwards, et ces technologies ne sont pas encore totalement intégrées. »

Illustration principale : Steve Mills, senior vice-président en charge de l'activité logiciels et systèmes d'IBM, crédit photo D.R.

Oracle propose une version d'évaluation de sa base NoSQL

Une version d'évaluation de l'édition Enterprise d'Oracle NoSQL Database, récemment annoncée, peut être téléchargée depuis quelques jours sur le site OTN (Oracle Technology Network) de l'éditeur. Cette base NoSQL, qui repose sur Berkeley DB, est l'un des composants clé de l'offre Big Data Appliance que la société va livrer au cours du premier trimestre 2012. Elle conviendra aux clients d'Oracle « qui récupèrent d'importants volumes d'informations sans savoir encore comment ils vont les traiter et veulent capturer ces données de façon plus fluide », a expliqué Marie-Anne Neimat, vice-présidente, responsable du développement des bases de données chez Oracle, et fondatrice de TimesTen. Des propos rapportés par nos confrères d'IDG News Service.

Ces dernières années, les solutions de ce type se sont multipliées afin de contourner l'architecture SQL typique pour permettre aux bases de s'étendre plus facilement et d'améliorer leurs performances. Elles sont utilisées pour stocker des informations générées par l'activité des systèmes informatiques (les logs), ou bien remontées par divers capteurs et compteurs, ou encore tirées des réseaux sociaux et des sites de e-commerce, rappelle l'éditeur. Pour l'analyste Curt Monash, de Monash Research, les bases NoSQL sont également adaptées aux grandes entreprises qui exploitent des bases Oracle, les solutions relationnelles ne constituant pas le meilleur choix pour certains types de tâches. Curt Monash estime qu'il y a bien une place pour une option NoSQL dans les comptes qui ont choisi Oracle. C'est donc tout à fait normal que l'éditeur cherche à la coopter, écrit-il sur son blog.

NoSQL convient aussi pour stocker des données qui ne sont pas essentielles, afin de soulager les bases plus structurées. Curt Monash rappelle à ce sujet un problème récemment rencontré par la banque JP Morgan Chase. Cette dernière avait stocké sur la même base des données financières transactionnelles et des informations sur les utilisateurs. Les transactions financières ont été ralenties par l'afflux sur le site web d'utilisateurs venus effectuer des vérifications sur le site après un crash. En conservant les données de ces derniers sur une base séparée, éventuellement NoSQL, ce problème aurait pu être évité, estime l'analyste.

L'administrateur ajuste la réactivité

Oracle NoSQL repose sur la version Java de Berkeley DB, base Open Source développée par l'Université de Californie Berkeley, très utilisée dans les systèmes embarqués. Elle utilise un modèle de données clé/valeur simple, ce qui signifie qu'un programme peut aller chercher la donnée requise en fournissant la clé appropriée ou un identifiant numérique. Si elle n'offre pas la possibilité d'effectuer des requêtes subtiles et fortement structurées comme on le ferait avec une base relationnelle SQL, elle n'impose pas un schéma sous-jacent figé. Il est donc possible d'ajouter des colonnes au fur et à mesure que de nouveaux types d'informations sont récupérés, explique Marie-Anne Neimat, d'Oracle.

(.../...)

[[page]]

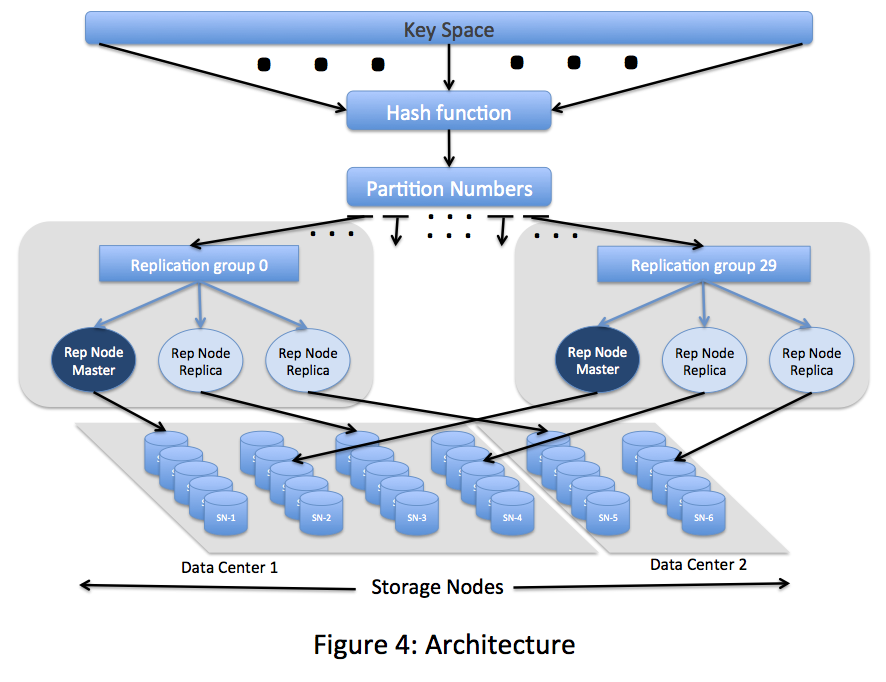

Le logiciel permet par ailleurs aux administrateurs d'ajuster la rapidité les temps de réponse en fonction du niveau de cohérence qu'ils veulent obtenir sur la base (suivant le temps nécessaire pour stocker les informations afin que chaque utilisateur connecté dispose de la même vue sur les données). « Quand une mise à jour se fait, elle peut être appliquée à un seul noeud, à la majorité des noeuds, ou à la totalité. Cela permet de gérer plus facilement la cohérence, indique Marie-Anne Neimat. La base va pouvoir être dimensionnée à un rythme presque linéaire, ce qui signifie que la capacité peut s'accroître de façon uniforme au fur et à mesure que l'on ajoute des serveurs au cluster. Oracle a construit un cluster de 300 noeuds avec sa base de données, quoique, en théorie, il n'y ait pas de limite à la taille du cluster qui pourrait être construire », a ajouté Marie-Anne Neimat.

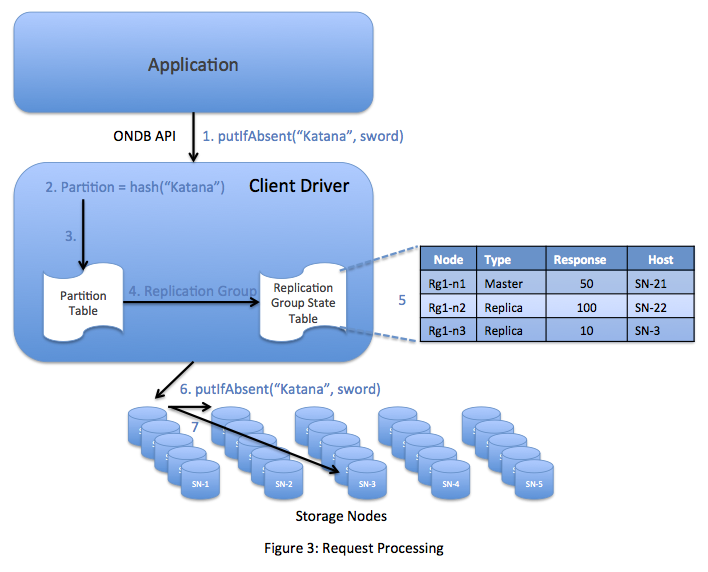

La localisation de toutes les données sera tracée et conservée par une bibliothèque cliente qui peut être reliée à une application. La bibliothèque Java dirige les requêtes vers le noeud qui conserve la copie de la donnée. Les programmeurs font interagir leurs applications avec la base de données à travers une API Java.

Clés principales et clés secondaires

Les clés principales peuvent elles-mêmes avoir des clés secondaires qui dirigent vers différents champs au sein du même enregistrement. Ces clés secondaires peuvent être utilisées pour ajouter des champs de données aux enregistrements existants. « Vous disposez de flexibilité sur la façon d'associer les attributs et les enregistrements », indique Marie-Anne Neimat. « Vous n'êtes pas encore sûrs de ce que vous voulez faire des données, mais vous savez que vous souhaitez les conserver pour les analyser plus tard ».

« Les enregistrements qui partagent la même clé racine sont tous sur la même partition, tous sur le même noeud. Vous pouvez mettre à jour un grand nombre d'enregistrements, faire des insertions, y accéder ou les supprimer en utilisant la clé principale », complète-t-elle. Les administrateurs peuvent interagir avec la base de données à partir d'une console web qui permet de gérer et de surveiller la topologie, ainsi que de faire de l'équilibrage de charges entre les différents noeuds.

Oracle va proposer une version communautaire gratuite de la base et une version commerciale qui sera enrichie de fonctions supplémentaires. Pour l'instant, l'éditeur propose gratuitement une version d'évaluation.

Illustration : Oracle NoSQL Database

Trimestriels Software AG : l'activité gestion de processus se démarque nettement

L'éditeur allemand Software AG a livré des résultats préliminaires pour son troisième trimestre 2011. Son chiffre d'affaires total ne progresse pas sur la période, par rapport au 3e trimestre 2010. Il s'élève à 275 millions d'euros contre 275,3 M€ l'an dernier. Et, globalement, les revenus provenant des ventes de licences et de la maintenance des logiciels n'augmentent que de 2% (à taux de change courant et de 5% à devise constante).

En revanche, l'activité Business Process Excellence, centrée sur l'intégration et la gestion des processus métiers, se distingue nettement et affiché de très bonnes performances : 84 millions d'euros, contre 72,1 M€ il y a un an, soit +17% à taux de change courant et +21% à devise constante. Dans ce domaine, les ventes de licences ont grimpé de plus de 33% en trois mois par rapport à l'an dernier, à taux de change courant, pour atteindre 42 millions d'euros (+37% à devise constante).

IDS Scheer Consulting reprend des couleurs

A l'inverse, l'activité ETS (Enterprise transaction systems), qui regroupe la base de données Adabas et l'environnement de développement Natural, a reculé de 10% à taux de change courant, à 79 M€. Le chiffre d'affaires services, qui représente environ 38% des revenus totaux, a également baissé, à 105 M€ (-3%). Mais l'éditeur souligne dans ce domaine un recentrage sur la rentabilité pour IDS Scheer Consulting, ce qui permet à cette activité de renouer avec les bénéfices. Karl-Heinz Streibich (en photo), le PDG de Software AG, considère que le redressement d'IDS Scheer Consulting est une réussite.

Sur le troisième trimestre, le résultat d'exploitation de la société se situe entre 71 et 73 M€ (contre 69,1 M€ un an plus tôt).

Pour l'exercice 2011, l'intérêt manifesté par les clients pour les solutions de Business Process Excellence conduit l'éditeur à maintenir ses objectifs de croissance de 10 à 15% (à devise constante) pour le chiffre d'affaires qui sera généré par les produits. Le chiffre d'affaires total devrait augmenter de 2 à 5% (à devise constante) et le bénéfice après impôt de 10 à 15% par rapport aux 175,6 M€ enregistrés en 2010.

Truffle 100 Europe, belle progression, mais les Américains à l'affût

Illustration principale : Karl-Heinz Streibich, PDG de Software AG (crédit : D.R.)

Les 10 technos stratégiques en 2012 selon le Gartner

Comme chaque automne, Gartner vient de publier sa liste des 10 technologies stratégiques pour les entreprises en 2012. Des technologies destinées à avoir un fort impact sur les sociétés ces trois prochaines années et qu'il serait risqué de négliger selon le cabinet de consultants. «Les entreprises devraient démarrer des projets exploratoires sur ces technologies et rassembler de multiples informations les concernant, y compris sur les réseaux sociaux», explique Carl Claunch, vice président et analyste chez Gartner.

Peu de surprises dans le palmarès 2012 établi par les consultants :

1. Tablettes et au-delà

Les entreprises auront à gérer des environnements peuplés de terminaux toujours plus hétérogènes. Elles devront se doter de deux stratégies mobiles distinctes: l'une à l'égard des employés (productivité, risque), l'autre à l'égard des clients (accès, intégration, réseaux sociaux).

2. Applications et interfaces conçues pour le mobile

Les interfaces mobiles (tactile, voix, recherche) remplacent peu à peu les interfaces classiques (fenêtres, menus, souris). Les applications elles-mêmes tendent à être plus simples et ciblées et combinées entre elles. Il conviendra de les développer de façon à ce qu'elles supportent de multiples terminaux et tirent parti de nouveaux développements comme HTML5.

3. Expérience contextuelle et sociale

L'informatique va de plus en plus exploiter des données disponibles directement sans intervention humaine, telles que la géolocalisation ou le réseau social. Ces données serviront à leur tour à fournir des informations personnalisées et conviviales, par exemple sous forme de réalité augmentée.

4. Internet des objets

Même si le concept d'objets équipés de senseurs et communiquant entre eux existe depuis quelques années, Gartner estime que le mouvement va s'accélérer. Le cabinet cite plusieurs domaines parmi lesquels, les systèmes embarqués, la reconnaissance d'image et la technologie NFC.

5. App Stores

Le concept d'app stores popularisé par Apple et Android avec des centaines de milliers d'applications disponibles en téléchargement devrait gagner l'entreprise. Le rôle de l'IT se transformerait ainsi de plus en plus d'un planificateur cebntralisé vers un gestionnaire de marché fournissant des prestations de courtage et des conseils aux métiers.

6. Nouvelle génération d'analyse

Le domaine de l'analytics de développe dans de multiples directions : l'analyse embarquée, l'analyse en temps réel et prédictive, l'analyse de données non structurées et l'analyse s'appuyant sur le cloud. L'analyse devrait d'autre part se rapprocher toujours plus de l'aide à la décision et de la collaboration.

ICTJournal.ch

[[page]]

7. Big data

Les volumes de données, la complexité des formats et la vitesse de réponse demandée requièrent l'usage de nouvelles technologies. Le modèle d'un data warehouse unique réunissant l'ensemble des données devient illusoire et sera remplacé par le concept d'entrepôts logiques.

8. In-memory

Gartner prédit un essor considérable de l'usage de mémoire flash dans les terminaux des particuliers et les systèmes IT. La disponibilité d'une grande capacité mémoire va permettre le développement de nouvelles applications (event processing, analytics, data management, messaging).

9. Serveurs à très basse consommation

L'adoption de serveurs à faible consommation énergétique va nous faire remonter dans le temps, prédit Gartner. En effet, il s'agit là d'employer de multiples systèmes basés sur des processeurs économes (comme ceux des smartphones), plutôt que de gros systèmes puissants. Un concept qui peut s'avérer optimal dans certains domaines, à l'instar du big data.

10. Cloud computing

Là aussi, bien que le concept ne soit guère nouveau, son adoption promet de s'accélérer ces prochainesd années dans tous les secteurs. Les entreprises comprenant de mieux en mieux les bénéfices et les risques du cloud computing et ses variantes privée, hybride et publique, elles sont mûres pour décider de ce qui mérite d'être déplacés dans les nuages.

Oracle rachète Endeca, spécialiste de l'analyse des données non structurées

Oracle rachète Endeca Technologies pour un montant non dévoilé. L'opération doit être finalisée avant la fin de l'année. Cette acquisition s'apparente à une réponse d'Oracle sur le rachat d'Autonomy par HP. Endeca est connue pour son moteur MDEX pour le traitement des données non structurées, telles que les emails et les informations textuelles d'autres provenances, mais aussi pour sa plateforme applicative d'analyse Latitude et son produit CEM (Customer Experience Management) InFront.

Les entreprises font face à une explosion du volume d'informations non structurées générées par leurs sites web, les réseaux sociaux, les centres d'appels et d'autres sources. HP et Oracle veulent offrir aux entreprises la capacité d'analyser en détail et rapidement les données pour mieux les comprendre et réaliser des économies.

Avec les application ATG Commerce et de BI (Business Intelligence) d'Oracle, les solutions d'Endeca créeront « une suite d'outils analytiques pour corréler et analyser les données structurées et non structurées grâce à un ensemble commun d'interfaces utilisateur, » précise la firme de Redwood . Des applications analytiques préconfigurées pour certaines industries sont également envisagées.

Sur le plan de la distribution, Oracle bénéficie aussi du portefeuille client d'Endeca qui comprend 600 clients, parmi lesquels Toyota, Ford, Raytheon et Walmart.

Les apports d'Oracle NoSQL Database

Quand Oracle a présenté sa solution Big Data Appliance (alliant matériel et logiciel), sur OpenWorld 2011 début octobre, il a précisé qu'il la livrait avec « R », le langage d'analyse statistique Open Source, ainsi qu'avec une base de données NoSQL maison. A l'évocation de cette dernière, la plupart des regards ont convergé vers Berkeley DB. En février dernier, Oracle avait effectivement expliqué comment la base Open Source (en 2006, il avait racheté la société Sleepycat Software qui la gérait) pouvait être utilisée comme une solution NoSQL (voir «Using Oracle Berkeley DB as a NoSQL Data Store »).

A l'issue d'OpenWorld, Charles Lamb, l'un des anciens de Sleepycat, désormais membre de l'équipe technique d'Oracle, a jugé utile d'apporter, sur le blog officiel qu'il tient, quelques précisions sur cette base de données capable de manipuler d'importants volumes. « J'ai consulté les commentaires de la Twitter-sphere au sujet d'Oracle NoSQL Database. Il y a un certain nombre de questions et d'idées fausses qui circulent auxquelles j'apporte ici une réponse », y écrit-il.

Selon lui, la première idée fausse est qu'Oracle NoSQL Database se résumerait à la version Java Edition de Berkeley DB (BDB) simplement rebaptisée. Ou encore, que le produit ne serait qu'une BDB avec quelques petites choses en plus. « Lorsque nous avons bâti NoSQL Database, nous avons constaté que Berkely DB Java Edition HA [high availability] disposait de nombreuses caractéristiques pour effectuer du stockage NoSQL, mais que cela ne suffisait pas », relate Charles Lamb. Il énumère ce que JE/HA apporte : des transactions caractérisées ACID (atomicité, cohérence, isolation, durabilité), la persistance, la haute disponibilité, le support des débits élevés et des grandes capacités et l'administration à distance. « Et l'on peut même considérer que son modèle de données clé/valeur est déjà NoSQL », ajoute-t-il. « Mais nous estimons que NoSQL signifie davantage pour la plupart des gens. » Par exemple : la distribution des données et leur découpage dynamique (aussi appelé « sharding »), la répartition de charges, la surveillance et l'administration, des temps de latence prévisibles et un backup multi-noeuds.

Une API différente et des liaisons réseaux

Si la base de données NoSQL présentée par Oracle utilise effectivement BDB JE/HA comme système de stockage sous-jacent («pourquoi réinventer la roue ? » souligne à cet égard Charles Lamb), elle bénéficie au-dessus d'une infrastructure complémentaire importante pour la faire entrer dans l'univers NoSQL.

Par ailleurs, la base Oracle NoSQL ne présente pas la même API (interface de programmation) que BDB JE, poursuit le consultant technique d'Oracle. L'interface est Java et elle procure pour les paires clé/valeur les fonctions CRUD (create, read, update and delete), l'itération et des capacités CAS (Compare and swap ou RMW, Read Modify Write), indique-t-il en détaillant plus avant dans son billet.

Charles Lamb aborde enfin un troisième point, relevé parmi les commentaires diffusés, selon lequel Oracle aurait ajouté à la base Berkeley DB Java la possibilité de configurer des liaisons réseaux avant de la renommer Oracle NoSQL. L'auteur de cette remarque s'interroge aussi sur la facilité de configuration et de développement. Sur ce deuxième point, le consultant technique d'Oracle explique qu'il est possible de lancer une version 'single process' (single-node) d'Oracle NoSQL Database, par invocation d'une simple ligne de commande, afin de tester l'API sans trop se compliquer la vie.

Enfin, sur la question des liaisons réseaux, il préfère une autre formulation. « BDB JE HA permet à un utilisateur de réaliser des opérations soit sur le « master » (pour les mises à jour et la lecture), soit sur les « replicas » (pour la lecture). L'objection la plus courante que nous rencontrons est que l'application doit « savoir » quels sont les noeuds où se trouvent le master et les replicas (pour router les mises à jour et lire les requêtes de façon appropriée). Il n'y a pas de couche réseau dans BDB JE/HA pour le faire, tandis qu'Oracle NoSQL Database le permet », conclut-il en expliquant comment procéder. (Oracle NoSQL Database/Source Oracle - cliquer ici pour agrandir)

(Oracle NoSQL Database/Source Oracle - cliquer ici pour agrandir) (Oracle NoSQL Database/Source Oracle - cliquer ici pour agrandir)

(Oracle NoSQL Database/Source Oracle - cliquer ici pour agrandir)

| < Les 10 documents précédents | Les 10 documents suivants > |