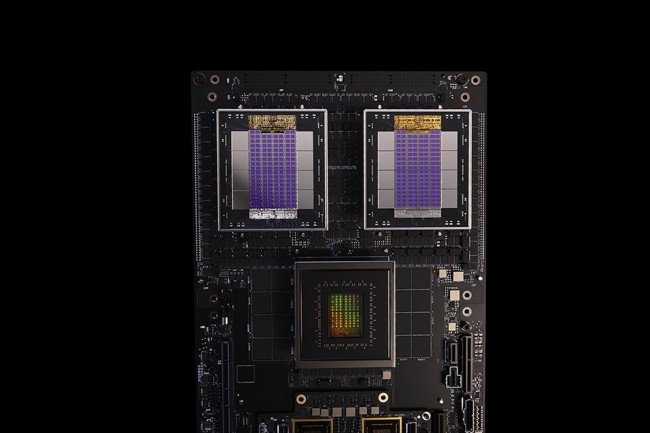

Arm diversifie ses paris dans le domaine des réseaux d'IA en rejoignant l'écosystème NVLink Fusion de Nvidia, en plus du consortium rival UALink auquel il avait adhéré l'année dernière. Le concepteur de designs de processeurs a annoncé lors de la SC25, la conférence internationale sur le calcul haute performance, les réseaux, le stockage et l'analyse, qu'il rejoindrait Nvidia et ses partenaires actuels, Intel, Fujitsu et Qualcomm. NVLink Fusion, annoncé lors du Computex de mai, donne aux partenaires la possibilité de construire ce que Nvidia décrit comme une infrastructure d'IA semi-personnalisée, mais en utilisant uniquement le protocole NVLink introduite pour la première fois il y a plus de dix ans. « Certains partenaires souhaitent combiner différents processeurs et accélérer les technologies pour des cas d'utilisation spécialisés », a déclaré Dion Harris, directeur principal des solutions d'infrastructure HPC et IA chez Nvidia. Précisons que ce dernier utilise des designs Arm pour ses puces serveurs GB200 combinant des CPU (Grace) et des GPU (Blackwell)

« NVLink Fusion permet aux hyperscalers et aux constructeurs d'ASIC personnalisés de tirer parti de l'architecture à l'échelle du rack de Nvidia pour déployer rapidement des puces personnalisées », a déclaré M. Harris lors d'une conférence de presse. « Arm intègre la propriété intellectuelle NVLink afin que ses clients puissent construire des SOC CPU pour se connecter aux GPU Nvidia. L'ajout d'Arm offre aux clients davantage d'options pour des infrastructures spécialisées et semi-personnalisées. »

Contrôle ouvert

Cependant, Sanchit Vir Gogia, CEO de Greyhound Research, a déclaré : « L'adhésion d'Arm à NVLink Fusion est saluée comme un moment d'ouverture, mais les conséquences architecturales sont plus nuancées. Fusion permet aux hyperscalers et aux laboratoires nationaux de connecter des processeurs et des accélérateurs tiers aux GPU Nvidia via une interconnexion cohérente, mais avec une règle : la connexion doit se terminer sur la structure Nvidia. Cela donne une impression de flexibilité tout en renforçant un centre de gravité qui reste exclusivement sous le contrôle de Nvidia. » Il a ajouté : « En intégrant Arm, Fujitsu, Qualcomm et les fabricants de silicium personnalisés, Nvidia s'assure que même les conceptions hétérogènes restent cohérentes avec Nvidia. C'est un coup de maître stratégique. Les concurrents peuvent innover en périphérie, mais pas au niveau de la structure centrale. »

Ces quatre partenaires font déjà partie du consortium UALink, fondé en 2024 et comptant plus de 80 membres, qui a développé une norme industrielle, publiée en avril, qui définit une interconnexion à faible latence et à large bande passante pour la communication entre les accélérateurs et les commutateurs dans des pods IA. La spécification UALink 1.0 permet de connecter jusqu'à 1 024 accélérateurs au sein d'un pod IA, « offrant ainsi une interconnexion standard ouverte pour les performances des clusters IA de nouvelle génération », a déclaré le consortium dans son communiqué. Nvidia n'est pas membre du groupe.

Commentaire