Arista Networks a fourni quelques détails sur le déploiement de sa technologie Etherlink qui sous-tendra les réseaux Ethernet capables de répondre aux exigences des charges de travail basées sur l'IA. La plateforme Etherlink comprendra une large gamme de systèmes 800G et de cartes de ligne basées sur le système d'exploitation EOS du fournisseur, lequel inclura à terme des fonctions Ethernet suralimentées compatibles avec les spécifications de l'Ultra Ethernet Consortium (UEC), comme l’a expliqué Jayshree Ullal, le CEO d'Arista, dans un récent billet de blog. « Alors que l'UEC complète ses extensions afin d'améliorer l'Ethernet pour les charges de travail de l'IA, Arista assure à ses clients qu’elle peut offrir des produits compatibles UEC, qui pourront facilement évoluer vers les futures normes à mesure des avancées de l'Ultra Ethernet Consortium d’ici à 2025 », a écrit Mme Ullal.

Fondé l’an dernier par AMD, Arista, Broadcom, Cisco, Eviden, HPE, Intel, Meta et Microsoft, l'Ultra Ethernet Consortium compte aujourd'hui plus de 50 fournisseurs. Le consortium développe des technologies visant à augmenter l'échelle, la stabilité et la fiabilité des réseaux Ethernet afin de répondre aux exigences de l'IA en matière de réseaux à haute performance. Dans le courant de l'année, le consortium prévoit de publier des spécifications officielles qui mettront l'accent sur une série d'améliorations Ethernet évolutives, notamment de meilleures options de livraison de paquets et de trajets multi-path, ainsi que des fonctions modernes de congestion et de télémétrie. « Dans l'ensemble de la gamme Etherlink d'Arista, les fonctions compatibles avec l'UEC comprendraient l'équilibrage de charge dynamique, le contrôle de la congestion et la livraison fiable des paquets », a indiqué Mme Ullal.

Réduire la latence et la congestion

« Les charges de travail d'IA poussent l'opération 'collective', où Allreduce et All-to-All (le tout-à-tout) sont les types collectifs dominants. Avec GPT-4, les modèles actuels passent déjà de milliards à mille milliards de paramètres. Bien sûr, il en existe d'autres, comme Google Gemini, Llama (open source) et Grok (xAI) », a encore précisé Mme Ullal. « Pendant le cycle de calcul, d'échange et de réduction, le volume de données échangées est si important que tout ralentissement dû à un réseau de mauvaise qualité peut avoir un impact critique sur les performances de l'application d'IA. La topologie Etherlink AI permettra à chaque flux d'accéder simultanément à tous les chemins vers la destination avec un équilibrage de charge dynamique à des vitesses de plusieurs térabits », a-t-il affirmé. « Aujourd'hui, Arista Etherlink prend en charge un radix de 1 000 à 100 000 nœuds GPU, et il passera à plus d'un million de GPU à l'avenir », a ajouté la dirigeante.

Selon la CEO, les plateformes Etherlink d'Arista présentent deux autres caractéristiques essentielles, une latence prévisible et une gestion de la congestion. Concernant la latence prévisible, « un transfert de masse rapide et fiable de la source à la destination est essentiel à l'achèvement de toutes les tâches d'IA. La latence par paquet est importante, mais la charge de travail de l'IA dépend surtout de l'achèvement en temps voulu d'une étape de traitement complète. En d'autres termes, le temps de latence de l'ensemble du message est essentiel. Des mécanismes de commande flexibles utilisent tous les chemins Etherlink, du NIC au commutateur, pour garantir une communication prévisible de bout en bout ». Quant à la gestion de la congestion, la gestion de l'encombrement des réseaux d'IA est un problème « incast » courant. « Cet encombrement peut se produire sur le dernier lien du récepteur d'IA quand plusieurs expéditeurs non coordonnés lui envoient simultanément du trafic. Pour éviter les points chauds ou les collisions de flux sur de coûteux clusters de GPU, des algorithmes sont en cours de définition pour étrangler, notifier et répartir uniformément la charge sur des trajets multi-path, en améliorant l'utilisation et le coût total de possession de ces GPU coûteux avec une structure VoQ », a indiqué Mme Ullal. La structure VoQ (Virtual Output Queuing) d'Arista comporte un mécanisme d'ordonnancement distribué qui garantit l'acheminement des flux de trafic dans les ports de commutation encombrés.

Analyse du trafic au niveau de la microseconde

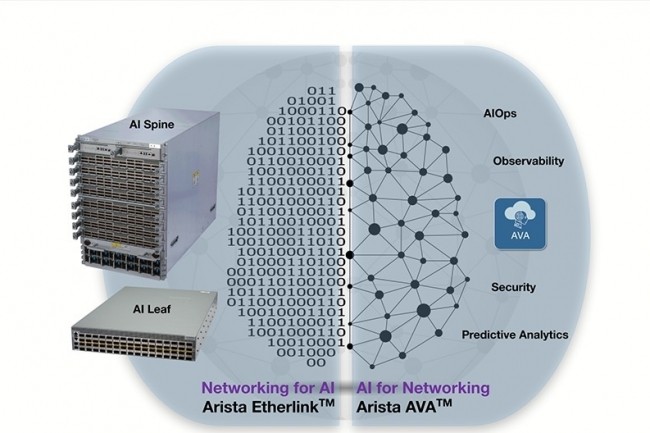

« Le réseau AI d'Arista dépend également d'une combinaison de notre système d'exploitation de base EOS et de son système d'assistance virtuelle autonome Autonomous Virtual Assist (AVA) basé sur le langage naturel et l'IA générative pour fournir des informations sur le réseau », a ajouté la CEO. « Grâce à un système expert basé sur l'IA qui automatise les tâches complexes de dépannage, d'analyse des causes profondes et de protection contre les cyber-menaces, Arista AVA imite l'expertise humaine à l'échelle du cloud », a-t-elle encore déclaré. « Le système d'assistance virtuelle autonome commence par des données de base en temps réel sur l'état des périphériques réseau et, si nécessaire, les paquets bruts. AVA combine notre vaste expertise en matière de réseaux avec un ensemble de techniques d'IA/ML, y compris le ML supervisé et non supervisé et le NLP (Natural Language Processing). L'application d'AVA à la mise en réseau de l'IA augmente la fidélité et la sécurité du réseau grâce à la détection et à la réponse autonomes du réseau et à l'observabilité en temps réel ».

En ce qui concerne la pile logicielle EOS d'Arista, M. Ullal a déclaré qu'elle pouvait aider les clients à construire des clusters d'IA résilients. « EOS offre des algorithmes d'équilibrage de charge améliorés et des mécanismes de hachage qui mappent le trafic des ports d'entrée de l'hôte vers les liaisons montantes afin que les flux soient automatiquement rééquilibrés en cas de défaillance d'une liaison », a écrit Mme Ullal. « Nos clients peuvent désormais choisir les champs d'en-tête des paquets pour une meilleure entropie et un équilibrage efficace des charges de travail d'IA ». Toujours selon la CEO d’Arista, la visibilité du réseau de l'IA est un autre aspect essentiel de la phase de formation pour les grands ensembles de données utilisés pour améliorer la précision des LLM. « En plus de l'analyseur de latence Latency Analyzer basé sur EOS qui surveille l'utilisation de la mémoire tampon, l'analyseur d'IA, AI Analyzer d'Arista, surveille les compteurs de trafic au niveau de la microseconde, ce qui permet d’identifier et de traiter les micro-rafales difficiles à détecter à des intervalles de quelques secondes », a souligné Mme Ullal.

Repenser les réseaux pour l'IA

D'une manière générale, « compte tenu des charges de travail massivement parallélisées » qui peuvent provoquer des encombrements, les clusters de formation à l'IA nécessitent une approche fondamentalement nouvelle de la construction des réseaux. « La congestion du trafic dans un seul flux peut entraîner un effet d'entraînement qui ralentit l'ensemble du cluster d'IA, car la charge de travail doit attendre que la transmission retardée se termine. Les clusters d'IA doivent être architecturés avec une capacité massive pour accueillir ces modèles de trafic à partir de GPU distribués, avec une latence déterministe et des fabrics Deep Buffer sans perte, capables de supprimer la congestion indésirable », a encore expliqué Mme Ullal.

Commentaire