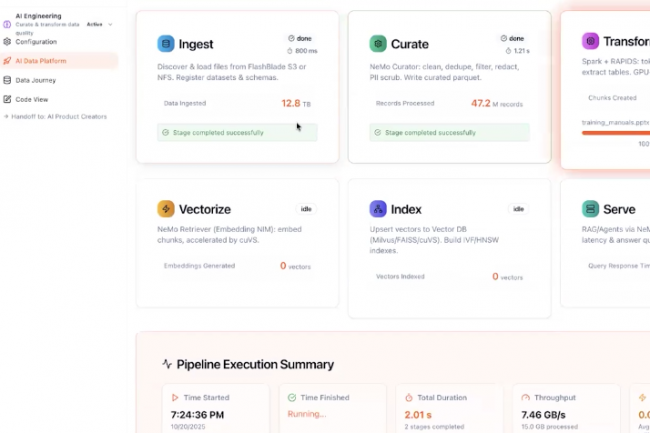

Pour aider les entreprises à organiser la collecte, le traitement et l'envoi de toutes leurs données pertinentes pour alimenter des LLM ou des agents IA, Pure Storage a présenté sa dernière offre, Data Stream. Celle-ci prend en charge toutes sortes de données au travers d'un pipeline centralisé doté de capacités d'ingestion, de transformation, de vectorisation, d'indexation... Cet outil peut être couplé à plusieurs types de baies du fournisseur, dont la dernière FlashBlade EXA taillé pour le traitement des métadonnées IA (présenté en mars dernier) ou la plus petite FlashBlade S. « Data Stream est une pile matérielle et logicielle intégrée, centrée sur le GPU et alimentée par l'IA, conçue pour automatiser et accélérer l'ingestion, la transformation et l'optimisation des données pour les pipelines d'IA d'entreprise », explique le fournisseur de stockage. Ce dernier a conçu sa solution Data Stream sur la base du design de référence AI Data Platform de Nvidia combinant du calcul accéléré, de la mise en réseau et le logiciel AI Enterprise couplée à différentes solutions de stockage dont les siennes.

Data Stream dispose de capacités variées à commencer par de l'ingestion et de la structuration automatisée des données en temps réel. « Data Stream ingère des données brutes provenant de diverses sources, notamment des documents texte, des fichiers PDF, des images et des tableaux structurés. Il effectue un découpage et une transformation intelligents, en divisant le contenu en segments sémantiquement cohérents tels que des phrases ou des paragraphes, afin de préserver l'intégrité contextuelle et le contrôle d'accès granulaire tout en minimisant la perte d'informations », explique l'entreprise. Ce produit s'intègre par ailleurs aux microservices Nemo Retriever de Nvidia pour orchestrer les workflows IA de bout en bout de la préparation des données à l'inférence des modèles. « Retriever permet la génération d'intégrations vectorielles accélérées par GPU, où des blocs de données brutes sont transformés en vecteurs sémantiques de haute dimension à l'aide de modèles d'intégration personnalisés et efficaces de Nvidia », poursuit la société. Les microservices NIM (inférence) « pour le déploiement d'une inférence optimisée, permettant une mise à l'échelle transparente dans les environnements sur site ou dans le cloud via des API standardisées », précise le fournisseur

Réduire la latence pour l'inférence

Data Stream est notamment optimisé pour les GPU RTX Pro 6000 Blackwell Server Edition et diverses bibliothèques logicielles telles que Spark Rapids et cuVS (open source) de Nvidia. Cette capacité doit aider à garantir une synchronisation précise entre la transmission des données et leurs cycles de traitement. L'architecture de ce produit est par ailleurs taillée pour les cartes d'interconnexion réseau ConnectX-7 de Nvidia pour un accès au stockage en réseau à faible latence. « Cette synchronisation évite les goulots d'étranglement informatiques dans le serveur RTX Pro, ce qui se traduit par des gains de performances significatifs en matière d'ingestion vectorielle lorsqu'il est associé à FlashBlade S », assure Pure Storage. « L'orchestration se fait au niveau de la couche de stockage, où des transformations telles que l'enrichissement des métadonnées et le reclassement par pertinence sont exécutées en parallèle, ce qui réduit significativement la latence de bout en bout pour l'inférence ».

Commentaire