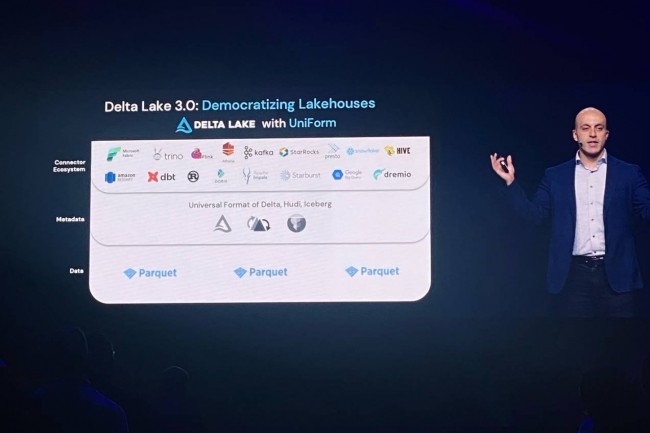

Présentée en début de semaine, la version Delta Lake 3.0 de l’offre de data lakehouse de Databricks a pour ambition d'uniformiser les formats de table de données. « Cette mise à jour comprend un format de table universel, appelé UniForm, qui offrira aux entreprises d'utiliser le data lakehouse avec d'autres formats de table comme Apache Iceberg et Apache Hudi », a déclaré l’entreprise. Contrairement aux concepts de data lake, qui stockent les données en format natif, et de data warehouses, qui stockent des données structurées (souvent au format SQL), l’architecture de données data lakehouse offre à la fois des capacités de stockage et d'analyse. « UniForm évite la conversion manuelle des fichiers provenant de différents lacs de données et entrepôts de données lors de la réalisation d'analyses ou de la construction de modèles d'IA », souligne le fournisseur. Selon les analystes, l’introduction de ce nouveau format de table est une réponse de Databricks à son rival Snowflake qui a fait le choix des tables Iceberg, comme de plus en plus de fournisseurs.

« Avec UniForm, Databricks dit essentiellement : s'ils sont impossibles à battre, rejoignez-les », a déclaré Tony Baer, analyste principal chez dbInsight, qui compare la bataille entre les formats de table à celle entre iOS d'Apple et Android de Google. Cependant, ce dernier estime que l'adoption des lakehouse dépendra de l'écosystème qu'ils offrent et pas seulement des formats de table. Et cette adoption est « est encore très préliminaire, car les écosystèmes ne se sont cristallisés que récemment et la plupart des entreprises commencent à peine à savoir ce que sont les lakehouses », a encore déclaré Tony Baer, prévoyant une amélioration dans l'année qui vient. Contrairement à Tony Baer, Databricks a déclaré que son Delta Lake a été téléchargé près d'un milliard de fois en un an. Selon le fournisseur, le passage de son offre Delta Lake en open source téléchargeable sur Github aurait permis à lakehouse de bénéficier de mises à jour de la part d'ingénieurs d'AWS, d'Adobe, de Twilio, d'eBay et d'Uber.

Delta Kernel et Liquid Clustering

Deux autres fonctionnalités appelées Delta Kernel et Liquid Clustering ont aussi été introduites dans la mise à jour 3.0 de Delta Lake. Le premier a pour ambition de résoudre le problème de la fragmentation des connecteurs en veillant à ce qu'ils soient construits à l'aide d'une bibliothèque Delta centrale qui met en œuvre les spécifications Delta. « Cela évite aux utilisateurs d’avoir à mettre à jour les connecteurs Delta à chaque nouvelle version ou changement de protocole », a déclaré Databricks.

Selon Sanjeev Mohan, analyste principal chez SanjMo, le noyau Delta s'apparente à un kit de développement de connecteurs qui fait abstraction de nombreux détails sous-jacents et fournit à la place un ensemble d'API stables. « C’est plus simple et il faut moins de temps pour construire et déployer les connecteurs. C’est pourquoi, nous pensons que les intégrateurs systèmes pourront accélérer le développement et le déploiement des connecteurs, ce qui va contribuer à élargir l'écosystème de partenaires de Databricks », a déclaré le consultant. « Quant au Liquid Clustering, il va résoudre les problèmes de performance liés aux opérations de lecture et d'écriture des données », a déclaré Databricks. Contrairement aux méthodes traditionnelles comme le partitionnement de type Hive, qui est complexe du fait de la disposition fixe des données pour améliorer les performances de lecture et d'écriture, Liquid Clustering offre un format de disposition des données flexible qui, selon Databricks, rendra le clustering plus rentable à mesure que la taille des données augmentera.

Commentaire