Afin d'aider les entreprises à résoudre les problèmes de performance de ces systèmes, AWS travaillent au développement d'un débogueur de base de données reposant sur un LLM maison. « Baptisé Panda, le framework de débogage a été conçu pour fonctionner de façon similaire à celle d'un DBE (ingénieur de base de données) », a écrit le fournisseur dans un blog, ajoutant que le dépannage des problèmes de performance dans une base de données peut s'avérer « notoirement difficile ».

Contrairement aux administrateurs de bases de données, qui sont chargés de gérer plusieurs bases de données, le rôle des DBE est de concevoir, développer et maintenir les bases de données. En effet, Panda fournit une base contextuelle aux LLM pré-entraînés afin de générer des recommandations de dépannage plus « utiles » et « contextualisées », ont expliqué les chercheurs.

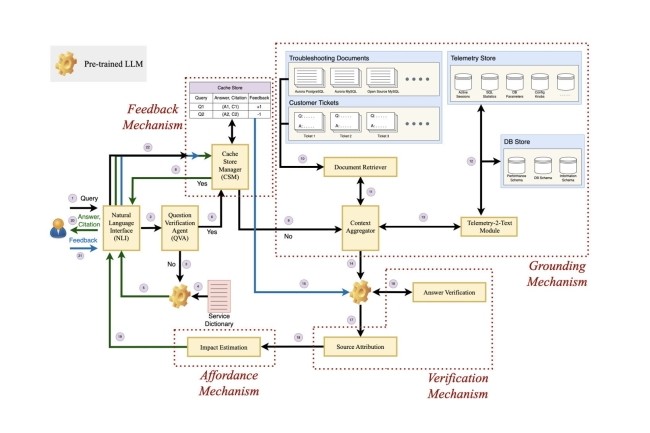

Composants et architecture de Panda

Le framework comprend quatre éléments clés : l'ancrage, la vérification, l'accessibilité et le feedback. Le premier est décrit comme la capacité du modèle à vérifier la réponse générée à l'aide de sources pertinentes et à produire la citation avec sa sortie afin que l'utilisateur final puisse la vérifier. « Ensuite, l'accessibilité peut être décrite comme la capacité du framework à informer l'utilisateur des conséquences de l'action recommandée suggérée par un LLM tout en soulignant explicitement les actions à haut risque, telles que DROP ou DELETE », ont déclaré par ailleurs les chercheurs. Quant au composant de feedback de Panda, « il permet au débogueur basé sur le LLM d'accepter le feedback de l'utilisateur et d'en tenir compte lors de la génération des réponses », selon les chercheurs.

Ces quatre composants constituent à leur tour l'architecture du débogueur, qui comprend l'agent de vérification des questions (Question Verification Agent, QVA), les mécanismes d’ancrage, de vérification, de feedback et d'accessibilité. Alors que l'agent QVA identifie et filtre les requêtes non pertinentes, le mécanisme d'ancrage comprend un extracteur de documents, Telemetry-2-text, et un agrégateur de contexte pour fournir plus de contexte à une invite ou à une requête. « Le mécanisme de vérification comprend la vérification de la réponse et l'attribution de la source », a encore déclaré AWS, ajoutant que tous ces mécanismes, ainsi que ceux de feedback et d'accessibilité, fonctionnent en arrière-plan d'une interface en langage naturel avec laquelle l'utilisateur de l'entreprise interagit.

Panda contre le modèle GPT-4 de l'OpenAI

AWS a également opposé Panda au modèle GPT-4 d'OpenAI, qui sous-tend actuellement ChatGPT. « Quand on demande à ChatGPT de répondre à des questions sur les performances des bases de données, on obtient souvent des recommandations « techniquement correctes » mais très « vagues » ou « génériques », généralement inutiles et non fiables pour les ingénieurs de bases de données expérimentés », précise le fournisseur en présentant un résultat obtenu lors du dépannage d'une base de données Aurora PostgreSQL. Selon l'article, pour cette expérience, AWS a réuni un groupe d'ingénieurs de bases de données de trois niveaux de compétence et la plupart d'entre eux se sont prononcés en faveur de Panda. En outre, les chercheurs affirment que, même si dans leur expérience, ils ont utilisé Panda sur des bases de données cloud, le débogueur peut être étendu à n'importe quel système de base de données.

Commentaire