En plein boom de l’IA, Apple est régulièrement pointé du doigt pour retard. Pourtant, la firme de Cupertino travaille sérieusement sur le sujet pour améliorer les réponses de son assistant vocal Siri. C’est ce qui ressort des travaux de chercheurs de la société en mettant au point un système d’intelligence artificielle capable de comprendre des références ambiguës et le contexte de la conversation. Par exemple, à la question de trouver une pharmacie près de chez soi, l’assistant va fournir une liste, puis la personne va demander « appelle celui qui se trouve sur Rainbow Road » ou « appelle celle du bas » ou « appelle ce numéro ». Ces « ce » et « celle-ci » sont difficiles à comprendre pour un assistant vocal.

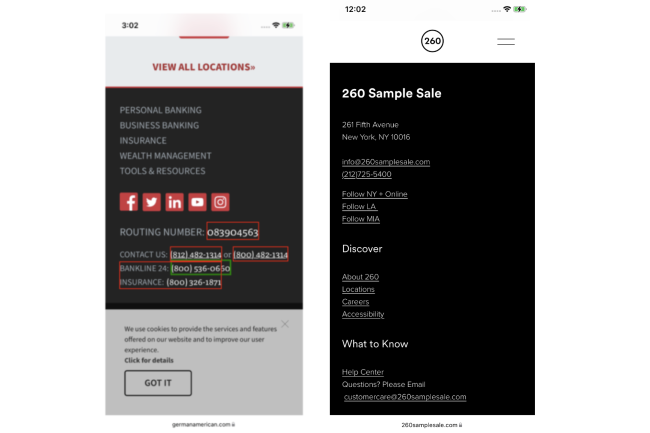

Baptisé ReALM (Reference Resolution As Language Modeling), le service s’appuie sur des LLM pour convertir la tâche complexe de la résolution de références, y compris dans des images, en un problème de modélisation du langage. Concrètement, l’outil découpe l’image à l’écran en petites entités pour générer une représentation textuelle en capturant l’agencement visuel. Les chercheurs ont démontré que cette approche, combinée à un réglage fin des LLM spécifiques à la résolution des références, permettait de surpasser GPT-4 dans cette tâche.

Des modèles plus petits et plus performants

Le LLM d’OpenAI table sur l'analyse d'images pour comprendre les informations affichées à l'écran. « La plupart des données d'apprentissage par l'image sont construites sur des images naturelles, et non sur des pages web artificielles codées et remplies de texte, de sorte que l'OCR directe est moins efficace », souligne les chercheurs. Apple a constaté que ses plus petits modèles ReALM (80 millions, 250 millions, 1 milliard et 3 milliards de paramètres) fonctionnaient de manière similaire à GPT-4 et qu'ils étaient donc mieux adaptés à une utilisation sur un terminal mobile.

Par exemple, si vous parcourez un site web et que vous décidez d'appeler l'entreprise, le simple fait de dire « appeler l'entreprise » oblige Siri à analyser ce que vous voulez dire compte tenu du contexte. Il serait capable de « voir » qu'il y a un numéro de téléphone sur la page qui est étiqueté comme celui de la société et de l'appeler sans autre demande de l'utilisateur. Cette orientation montre que la firme américaine continue à investir dans son assistant vocal Siri. On prête à Apple de dévoiler plusieurs innovations en matière d’IA dans iOS 18 lors de la conférence développeur WWDC qui se déroulera du 10 au 14 juin.

Commentaire