En mars dernier lors de la GTC, Jensen Huang, CEO de Nvidia, avait dévoilé la roadmap des futures puces et systèmes avec un focus sur le GPU Rubin succédant à l'architecture Blackwell. Aujourd’hui, le fournisseur a présenté l’accélérateur Rubin CPX qu’il réserve pour les traitements d’inférence pour l’IA. Pour rappel, cette tâche est la capacité pour un modèle d’IA formé à faire des prédictions précises basées sur d’autres sources de données. Pour cela, Rubin CPX va combiner des CPU sur base Arm Vera, succédant aux puces Grace actuelles, avec 88 cœurs et 176 threads et des GPU Rubin remplaçant les Blackwell. Les performances annoncées frisent les 30 pétaflops en FP4 (un peu moins que les 50 pétaflops annoncés à la GTC). On notera par ailleurs que Nvidia fait l’impasse sur la performante et très couteuse mémoire HBM pour intégrer 128 Go de GDDR7 à ses puces Rubin CPX. La firme ne donne pas de raisons particulières pour ce choix indiquant simplement que la GDDR7 offre des performances adéquates.

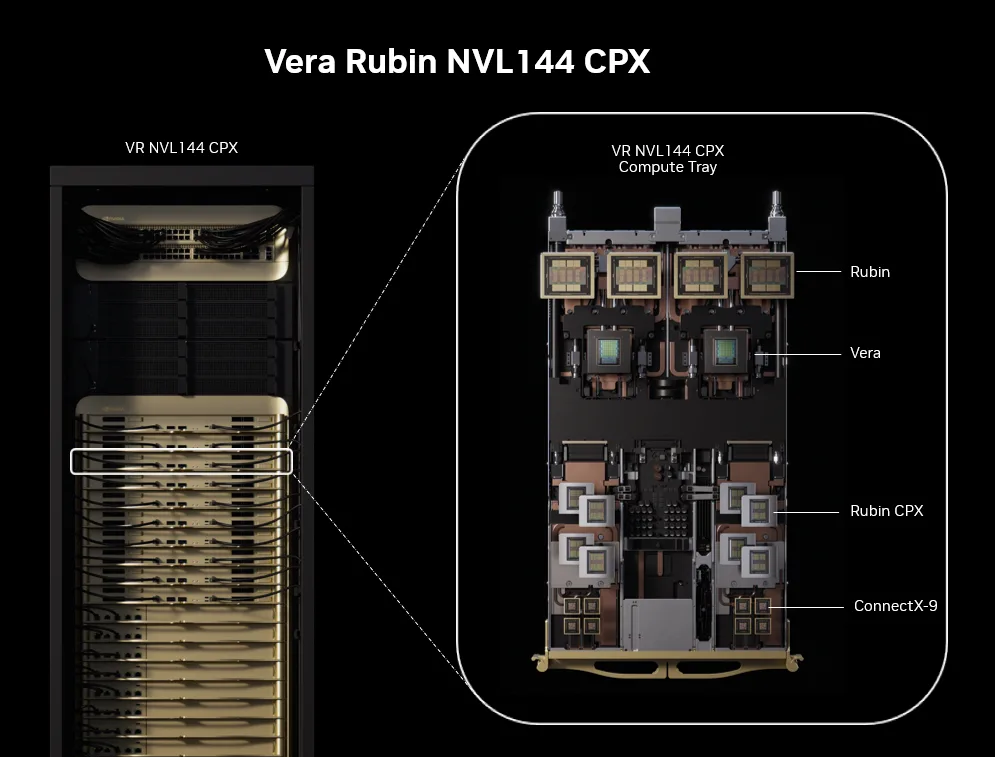

Les puces Rubin CPX fonctionneront en tandem avec les processeurs Vera et les GPU Rubin pour le traitement en phase de génération, formant ainsi une plateforme désagrégée et haute performance, explique la firme de Santa Clara. Le cluster NVL144 CPX de Nvidia intègre ainsi 144 puces Rubin CPX, 144 GPU Rubin et 36 CPU Vera pour offrir une puissance de calcul de 8 exaFLOPs en FP4 de, soit 7,5 fois plus que le GB300 NVL72, avec 100 To de mémoire HMB et 1,7 Po/s de bande passante mémoire. Ce système sera proposé en plusieurs configurations avec Quantum-X800 InfiniBand ou la plate-forme réseau Ethernet Spectrum-XTM avec la technologie Spectrum-XGS et les SuperNIC ConnectX-9.

Dans son système NVL144 CPX, Nvidia combine des puces Rubin CXP (CPU et GPU) avec des CPU Vera et des accélérateurs Vera. (Crédit Nvidia)

Taillé pour l’inférence

Selon Shar Narasimhan, directeur des produits datacenter de Nvidia, « l'inférence est souvent considérée comme une étape unique du processus d'IA, mais il s'agit en réalité de deux charges de travail ». Et de les décrire, « elles comportent une phase de contexte ou de pré-remplissage et une phase de décodage ». Pour lui, « la première est gourmande en calcul, tandis que la seconde est gourmande en mémoire, mais jusqu'à présent, on demandait au GPU d'effectuer les deux tâches alors qu'il n'en maîtrise vraiment qu'une seule ». Rubin CPX a été spécialement conçu pour ces deux phases en offrant une puissance de traitement, un débit élevé et une grande efficacité. Nvidia annonce une disponibilité de sa puce pour la fin de l’année 2026.

Commentaire