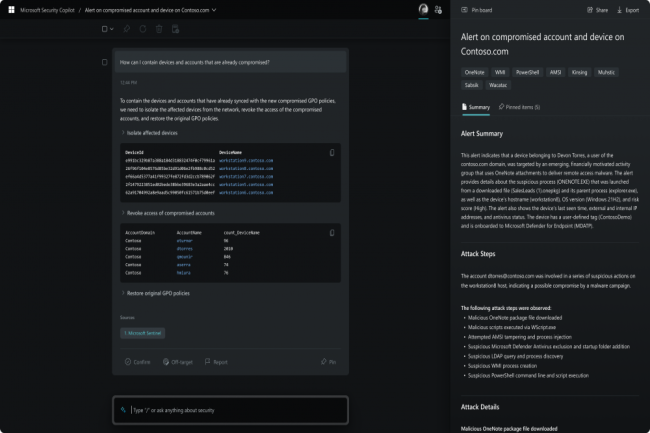

Après Teams, la suite Microsoft365, c’est au tour des solutions de sécurité de la firme d’être infusée à l’IA générative d’OpenAI. Elle vient de lever le voile sur Security Copilot qui propose une multitude de fonctions et d’analyse. Son interface est similaire à celle de ChatGPT et peut répondre à des questions sur la sécurité IT de manière naturelle. Mais le plus impressionnant est l’intégration étroite avec les différents services de sécurité de Microsoft, notamment Defender, Sentinel, Entra, Purview, Priva et Intune.

Copilot peut interpréter les données de l’ensemble de ces services et fournir des explications automatisées et approfondies (y compris des visualisations), et suggérer aussi des solutions. De plus, le système pourra prendre des mesures contre certains types de menaces, par exemple en supprimant les messages électroniques dont le contenu malveillant a été identifié lors d'une analyse précédente. Microsoft prévoit d'étendre les capacités Security Copilot au-delà de ses propres produits, mais le fournisseur n'a pas donné d'autres détails à ce sujet, ni dans sa communication, ni dans le billet de blog officiel sur le service. Microsoft a également fait remarquer qu'en tant que produit d'IA générative, Security Copilot ne donnera pas des réponses correctes à 100 % et qu'il aura besoin d'un entraînement supplémentaire et des apports des premiers utilisateurs pour atteindre son plein potentiel.

Les données cyber pour l’entraînement de l’IA, un sujet délicat

Selon les experts en IA, même s'il n'est pas aussi novateur que Microsoft l'a présenté, Security Copilot est un système puissant. Selon Avivah Litan, vice-présidente et analyste chez Gartner, cela fait des années qu’IBM dispose de capacités similaires via Watson AI. « L'IA de Copilot est plus rapide et meilleure, mais la fonctionnalité est la même », a-t-elle déclaré. « C'est une offre intéressante, mais elle ne résout pas les problèmes que rencontrent les utilisateurs avec l'IA générative. Indépendamment de ces problèmes, dont le plus important est l'incapacité reconnue de Security Copilot à fournir des informations précises dans tous les cas, les avantages potentiels du système sont toujours impressionnants », a déclaré pour sa part Chris Kissel, vice-président de la recherche d'IDC. « Le grand avantage est qu’il est possible d’automatiser un bien plus grand nombre de choses », a-t-il déclaré. « L'idée qu'un ChatGPT puisse écrire quelque chose de manière dynamique et que l'analyse puisse le juger dans son contexte, dans la même couche, est convaincante », a-t-il ajouté.

Les deux analystes se sont toutefois montrés quelque peu sceptiques quant à la politique de Microsoft en matière de partage des données, en particulier que les données privées ne seront pas utilisées pour entraîner les modèles d'IA fondamentaux et que toutes les informations relatives aux utilisateurs resteront sous leur contrôle. Le problème, selon eux, est que les données relatives aux incidents sont essentielles pour former des modèles d'IA comme celui utilisé pour Security Copilot, et que l'entreprise n'a pas donné beaucoup d'indications sur la manière dont ces données seront traitées. « C'est une préoccupation », a déclaré M. Kissel. « Si l’on essaye de faire quelque chose qui implique, par exemple, un élément spécifique de la propriété intellectuelle, y a-t-il des garanties que ces données seront maintenues en place ? », a-t-il demandé. « Comment savoir si les données sont réellement protégées s'ils ne fournissent pas les outils nécessaires pour les examiner », a ajouté Avivah Litan. Pour l’instant, Microsoft n'a pas annoncé de date de disponibilité pour Security Copilot, mais le fournisseur a déclaré qu’il partagerait bientôt plus d’information à ce sujet.

Commentaire