Start-up prometteuse fondée en 2015 et historiquement spécialisée dans les puces et systèmes IA, Cerebras Systems a levé depuis sa création 720 M$ dont 250 M$ en 2021. Co-créée par Andrew Feldman son CEO et ex dirigeant de SeaMicro (revendu à AMD en 2012 pour 355 M$) Sean Lie, architecte matériel en chef, la jeune pousse a multiplié depuis sa création les produits. Après la plus grande puce au monde WSE, un processeur taillé pour le deep leearning en 2019 et en novembre dernier un supercalculateur baptisé Andromeda, Cerebras annonce avoir formé et poussé auprès de la communauté des chercheurs sept grands modèle de langage basés (LLM) pour l'IA générative.

« Cerebras-GPT a des temps et des coûts de formation plus rapides et consomme moins d'énergie que n'importe quel autre modèle disponible à ce jour », a expliqué Cerebras. Le fournisseur met par ailleurs en avant que sa technologie est « ouverte et accessible », étant proposée sous licence Apache 2.0. « Nous avons entraîné tous les modèles Cerebras-GPT sur un cluster 16x CS-2 Wafer-Scale Andromeda. Ce cluster a permis de réaliser toutes les expériences rapidement, sans l'ingénierie traditionnelle des systèmes distribués et le réglage parallèle des modèles nécessaires sur les clusters GPU. Plus important encore, il a permis à nos chercheurs de se concentrer sur la conception du ML plutôt que sur le système distribué », a précisé la firme.

7 LLM formés sur 16 systèmes CS-2

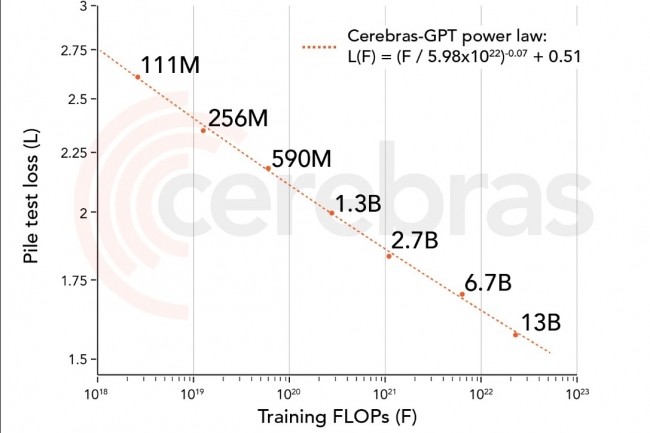

Ces nouveaux LLM ont été formés à l'aide de 16 systèmes CS-2 du supercluster d'IA Andromeda tournant sur la dernière puce WSE-2 du fournisseur, spécialement conçue pour exécuter des logiciels d'IA. Ils sont disponibles sur GitHub et Hugging Face. Ces différents modèles ont chacun un nombre particulier de paramètres : 111 millions, 256 millions, 590 millions, 1,3 milliard, 2,7 milliards, 6,7 milliards et 13 milliards. La formation de ces modèles prendrait normalement plusieurs mois, mais Cerebras a déclaré que la vitesse des systèmes Cerebras CS-2 dans Andromeda, combinée à une architecture unique, a permis de réduire ce temps à quelques semaines seulement. Sans surprise, dans le cadre de son comparatif maison, Cerebras a fait ressortir ses LLM en tête par rapport à OpenAI GPT-4, Deepmind Chinchilla, Meta OPT et Pythia.

Pour en profiter l'entreprise doit donc s'équiper en systèmes IA ce qui apparait comme une très bonne stratégie pour le groupe : mettre en avant les capacités du modèle tournant sur ses propres systèmes et pour profiter de cette performance du modèle open source disponible pour tous il faut donc se tourner vers les équipements et matériels du fournisseur. Le cas échéant, le fournisseur qui a décidément pensé à tout propose aux entreprises de faire tourner son LLM dans... son cloud. « Nous pensons que la capacité d'entraîner facilement de grands modèles est un facteur clé pour la communauté élargie, c'est pourquoi nous avons rendu le Wafer-Scale Cluster disponible sur le cloud à travers le Cerebras AI Model Studio », précise la société. Une intention louable mais qui, contrairement à Cerebras-GPT, est cette fois payante.

Commentaire