En direct de Las Vegas. La conférence Re :Invent 2019 d’AWS (du 2 au 6 décembre à Las Vegas) tient ses promesses avec une pluie d’annonces. Andy Jessy, CEO d’AWS, est à la manœuvre et assure la keynote d’ouverture pendant 3 heures durant devant près 30 000 personnes. Si le discours porte sur plusieurs sujets, dont les infrastructures et les bases de données, sur lesquels nous reviendrons dans d’autres articles, la part du lion revient au machine learning. « Aujourd’hui, il y a des blocages pour son utilisation, l’entraînement, le déploiement, les compétences, les ressources. La grande interrogation est comment passer de la data au modèle de machine learning », explique le patron d’AWS. Pour lui, la réponse est « de rendre plus facile le recours au machine learning et de le démystifier ».

Pour cela, le fournisseur de services cloud s’attaque au problème autour de trois axes. Le premier est clairement orienté vers les datascientists avec la prise en charge des différents frameworks d’apprentissage automatique, TensorFlow (développé par Google), PyTorch et MxNet. Un moyen pour AWS de tacler son concurrent Google : « 85% des instances TensorFlow fonctionnent sur AWS, mais 90% des datascientists déclarent utiliser plus d’un framework », constate Andy Jessy. En écho, Vasi Philomin, directeur des développeurs de Transcribe, observe que « TensorFlow est très utilisé pour la vision par ordinateur, PyTorch est apprécié pour sa facilité d’appréhension et son évolutivité. Enfin, MxNet est réputé plus performant ». Sur l’ensemble de ces frameworks, AWS revendique de meilleures performances que ses concurrents avec les instances P3 (dopées au GPU Nvidia v100).

Sagemaker passe en mode IDE et gagne des fonctionnalités

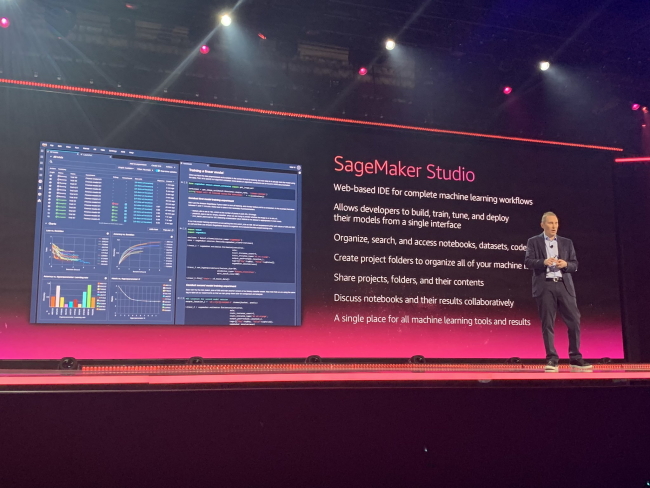

Le second axe de travail est à destination des développeurs pour créer, entraîner et déployer des modèles de machine learning. C’est dans cet esprit qu’en 2017 AWS avait lancé la plateforme Sagemaker qui devient aujourd’hui Sagemaker Studio, un IDE (environnement intégré pour le développement) avec plusieurs fonctionnalités supplémentaires à la clé.

AWS a dévoilé l'IDE Sagemaker Studio pour les modèles de machine learning.

« L’objectif est que les développeurs s’approprient l’IDE comme pour les applications classiques avec un seul point de contact », glisse Andy Jessy. Pas moins de cinq solutions ont été intégrées à Sagemaker Studio :

- Notebooks (en mode preview), il permet de créer et de partager des blocs-notes Jupyter, une application client-serveur open source utilisée pour le machine learning,

- Experiments permet d’organiser, de suivre et de comparer des milliers de tâches de machine learning

- Debugger automatise l’analyse des problèmes sur les modèles d’entraînement complexes et l’envoi d’alerte. Par ailleurs, le service analyse en temps réel les algorithmes et propose des solutions pour optimiser les temps d’entraînement des modèles.

- Model Monitor scrute les modèles ML pour détecter les écarts et les dérives de données. Lors de la création d’un modèle des statistiques de performance sont relevées, puis le service analyse l’évolution du modèle dans le temps et vérifie que cette performance n’est pas altérée ou modifiée. Il préconise des ajustements pour garantir une efficacité des modèles à long terme.

- Autopilot s’appuie sur le service AutoML pour générer automatiquement des modèles d’apprentissage automatique. Ce service est disponible via « une API ou un clic dans Sagemaker Studio ». Il analyse les différents jeux de données puis identifie les combinaisons optimales pour le pré-traitement des données, les algorithmes ML et les hyperparamètres. Au total, une cinquantaine de modèles sont ainsi automatisées. En complément, Autopilot donne un aperçu plus profond sur la façon dont le système a construit le modèle. « Le monde du machine learning est opaque », reconnait Andy Jessy et ajoute « les gens voient ce système comme une boîte noire ». D’où l’idée de donner de « la visibilité et du contrôle » en décrivant au sein d’un bloc-note la « recette » du modèle.

Des services pré-packagés

Dernier étage de la stratégie sur le machine learning, la mise à disposition de modèles pré-packagés pour des usages spécifiques. Dans ce domaine, AWS profite à fond de sa relation avec la maison-mère, Amazon. Ainsi, pour le service de détection de la fraude (en mode preview), le fournisseur de cloud s’appuie sur un modèle de ML déjà éprouvé auprès du e-commerçant. « Analyse des emails, des adresses IP, de l’historique des transactions et des données sur les comptes, nous avons acquis de l’expérience avec Amazon », concède le CEO d’AWS. Cet échange se retrouve également sur un autre service à destination des développeurs, CodeGuru, qui vise à automatiser la revue de code. Depuis plusieurs années, Amazon a entraîné des modèles d’apprentissage automatique avec des centaines de milliers de projets internes et un peu plus de 10 000 projets open source sur GitHub. Ce service lui a permis de détecter « les lignes de code les plus onéreuses » et de réaliser de substantielles économies (des dizaines de millions de dollars). Sur le plan tarifaire, il faudra compter 0,75 dollars par mois pour 100 lignes de code analysées.

Par ailleurs, le fournisseur a présenté le service Kendra, un moteur de recherche pour l’entreprise concurrent d'Elastic Search. Il se connecte à différentes sources de données SharePoint, Exchange, OneDrive, Box, Dropbox, Google Drive, Salesforce et Confluence. Il indexe ensuite les données et ajoute une couche de machine learning pour répondre à des requêtes en langage naturel. « Le challenge est de ne pas uniquement faire de la recherche de mots, mais de comprendre le contenu, le contexte dans une variété de documents avec des données non structurées », constate Matt Wood, vice-président en charge des services d’intelligence artificielle.

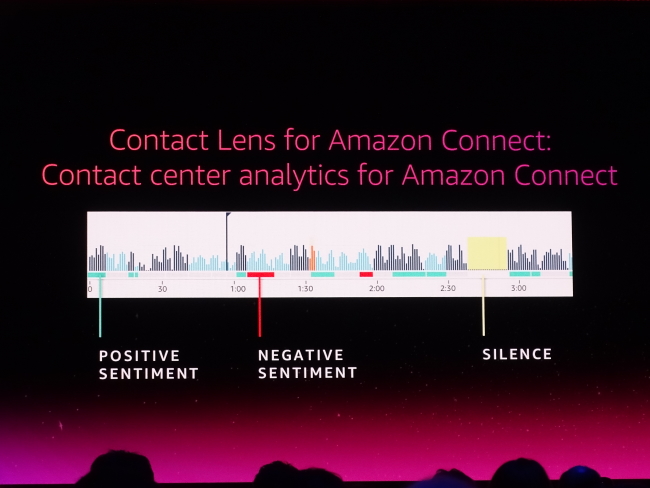

Enfin, AWS lance le service Contact Lens pour Amazon Connect, l’offre de centre de contact en mode cloud. Contact Lens apporte l’expérience du NLP (Natural Langage Processing) au centre de contact. En un seul clic, la conversation est traduite et analysée pour comprendre le ressenti du client (énervé, déçu, content, inquiet, silencieux). « L’année prochaine, Contact Lens sera capable de traduire et d’analyser un appel téléphonique en temps réel », assure Andy Jassy.

Le service Contact Lens permet d'enregistrer et d'analyser la conversation avec un client et d'en dégager les tendances.

Commentaire