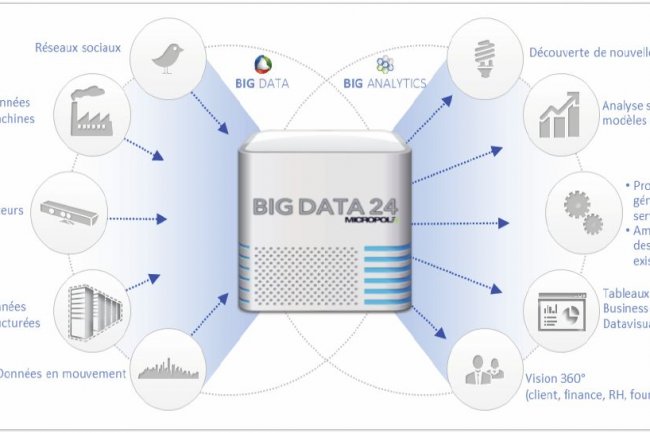

La diversité des sources de données à traiter est l'une des principales caractéristiques des projets big data. Pour les directions métiers qui veulent les exploiter et pour les spécialistes de l'analyse prédictive, « cela change la donne », souligne Chrystel Galissié, directrice de la connaissance client chez Wide. Cette filiale du groupe Micropole, qui dispose d'une équipe de data scientists, a contribué à bâtir l'offre Big Data 24 de la société de conseil. Celle-ci donne accès en 24 heures à un environnement cloud avec la distribution Hadoop de son choix et différents logiciels de manipulation de données. Spécialisé dans le marketing relationnel, Wide accompagne les entreprises qui veulent combiner à leur CRM (système de gestion de la relation client) la multiplicité des informations externes, notamment issues des réseaux sociaux, pour mieux connaître ceux qui achètent leurs produits et évaluer comment leur marque est perçue sur le marché.

Jusque-là, les statisticiens qui effectuaient les modélisations travaillaient sur des données de bonne qualité. Désormais, avec la multiplication des sources, la qualité des données est très différente d'une origine à l'autre. « Nous avons donc beaucoup changé l'approche de notre métier ces deux dernières années », a expliqué Chrystel Galissié lors d'un point presse. Wide a structuré une démarche. « Nous avons un catalogue d'indicateurs que nous utilisons en fonction des différentes sources et des enjeux métiers des entreprises ». En plus des algorithmes classiques de datamining, Wide a développé ses propres outils, adaptables par problématique et par pays, pour approfondir les parcours des clients et contribuer à en reconstituer une vision unique : contexte social et culturel, canaux et supports empruntés, données d'usage comme le SAV ou les avis de consommation, programme de fidélité, etc.

Maîtriser les outils traditionnels et Open Source

Chrystel Galissié cite en particulier deux algorithmes qui se sont avérés performants. Le premier, sequential pattern analysis, permet de définir des séquences avec une notion de temporalité pour élaborer des parcours client adaptés. Il combine notamment des données des réseaux sociaux et de géolocalisation. Le deuxième algorithme a été mis au point pour évaluer le patrimoine client et effectuer un calcul prédictif de la valeur client. Il met en oeuvre le modèle probabiliste Pareto/NDB et les modèles « Buy till you die ». Pour l'instant, ils n'existent pas dans les outils de datamining du marché. Mais il semble qu'IBM s'y intéresse et pourrait les embarquer dans ses outils d'analyse prédictive.

Interrogée sur les compétences recherchées pour les data scientists, Chrystel Galissié a insisté sur l'importance de connaître les outils Open Source (tels que le langage d'analyse statistique R, par exemple), au-delà de la maîtrise des outils traditionnels de l'analyse prédictive (SPSS, Kxen, SAS, etc.). Ce sont des éléments qu'elle regarde lorsqu'elle recrute un data scientist. « On se doit de programmer différemment », a-t-elle indiqué.

Big data : Wide a conçu des algorithmes adaptés au parcours client

0

Réaction

La filiale de Micropole spécialisée dans le marketing relationnel, Wide, a développé ses propres outils de datamining. Elle les propose dans le cadre de l'offre cloud Big Data 24 permettant aux métiers de lancer rapidement un projet big data.

Newsletter LMI

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire