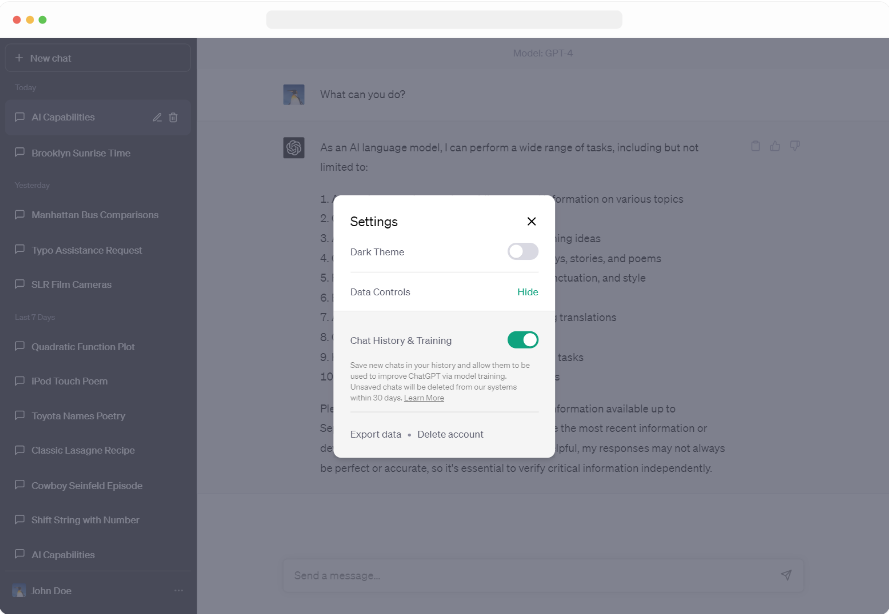

C’est un changement de taille pour les utilisateurs de ChatGPT. Ces derniers peuvent désormais désactiver l'historique des discussions, notamment dans le but de sélectionner les conversations à utiliser pour former ses modèles. « Nous avons introduit la possibilité de désactiver l'historique des conversations dans ChatGPT. Les conversations entamées lorsque l'historique est désactivé ne seront pas utilisées pour entraîner et améliorer nos modèles, et n'apparaîtront pas dans la barre latérale de l'historique » annonce OpenAI. Disponible pour tous les utilisateurs dès aujourd’hui, cette fonction de contrôle se trouve dans les paramètres de ChatGPT et peut être modifiée à tout moment.

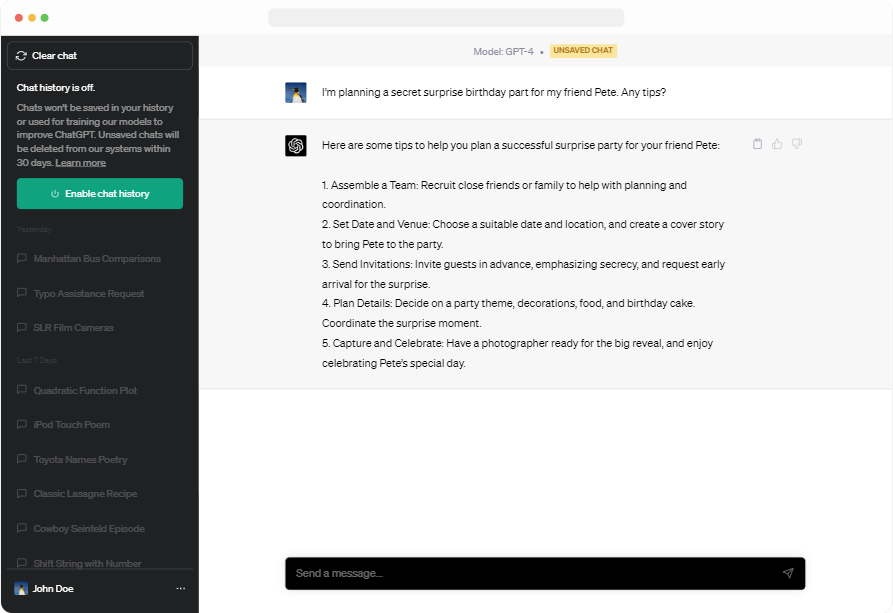

Lorsqu’un utilisateur désactive l’historique, il est informé à la fois en haut du chat – informant qu’il n’est pas sauvegardé – et au niveau de la barre latérale gauche. Il est également précisé que ces discussions, qui ne sont ni sauvegardées ni utilisées dans l’entraînement du modèle pour améliorer ChatGPT, sont supprimés du système d’OpenAI au bout de 30 jours. « Nous ne les consultons qu'en cas d'abus, avant de les supprimer définitivement » ajoute la firme. Dans le même temps, la firme a ajouté option d'exportation dans les paramètres afin d'exporter plus facilement ses données ChatGPT et de comprendre quelles informations ChatGPT stocke. Une fois l’exportation faite, l’utilisateur reçoit un fichier avec ses conversations et toutes les autres données pertinentes par email.

Illustration de la désactivation de l'historique dans ChatGPT. (Crédit : OpenAI)

Dans les paramètres, il est possible d'activer ou non l'historique et l'entraînement du modèle. (Crédit : OpenAI)

Un abonnement business à venir

La firme travaille également sur une souscription ChatGPT Business « pour les professionnels qui ont besoin de plus de contrôle sur leurs données ainsi que pour les entreprises qui cherchent à gérer leurs utilisateurs finaux ». Cet abonnement suivra les politiques d'utilisation des données de l’API, ce qui signifie que les données des utilisateurs finaux ne seront pas utilisées pour entraîner les modèles d’OpenAI par défaut. Il devrait être disponible dans les mois à venir.

Se plier aux exigences des régulateurs

En mettant à disposition des utilisateurs davantage d’outils pour contrôler les données qui passent par OpenAI et son chatbot, la firme cherche évidemment à apaiser les tensions avec les régulateurs. Pour rappel, fin mars, la FTC aux Etats-Unis a été saisie d'une plainte d'une association l'exhortant à agir contre OpenAI et sa solution jugée trompeuse, biaisée et constituant un risque pour la sécurité publique. De son côté, le garant italien pour la protection des données personnelles (GPDP) a bloqué le site Web d'OpenAI hébergeant le modèle.

En début de mois, le Comité européen de la protection des données (CEPD) a même lancé un groupe de travail sur ChatGPT, après concertation quant au choix fait par le GPDP. La structure qui réunit les organismes nationaux de surveillance de la vie privée en Europe a déclaré qu’il s’agit d’une première étape potentiellement importante vers une politique commune sur l'établissement de règles de confidentialité sur l'intelligence artificielle. « Le CEPD a décidé de lancer un groupe de travail dédié pour favoriser la coopération et échanger des informations sur d'éventuelles actions d'application menées par les autorités de protection des données ». L’objectif est, avant tout, de créer des politiques transparentes et communes aux États membres.

Commentaire