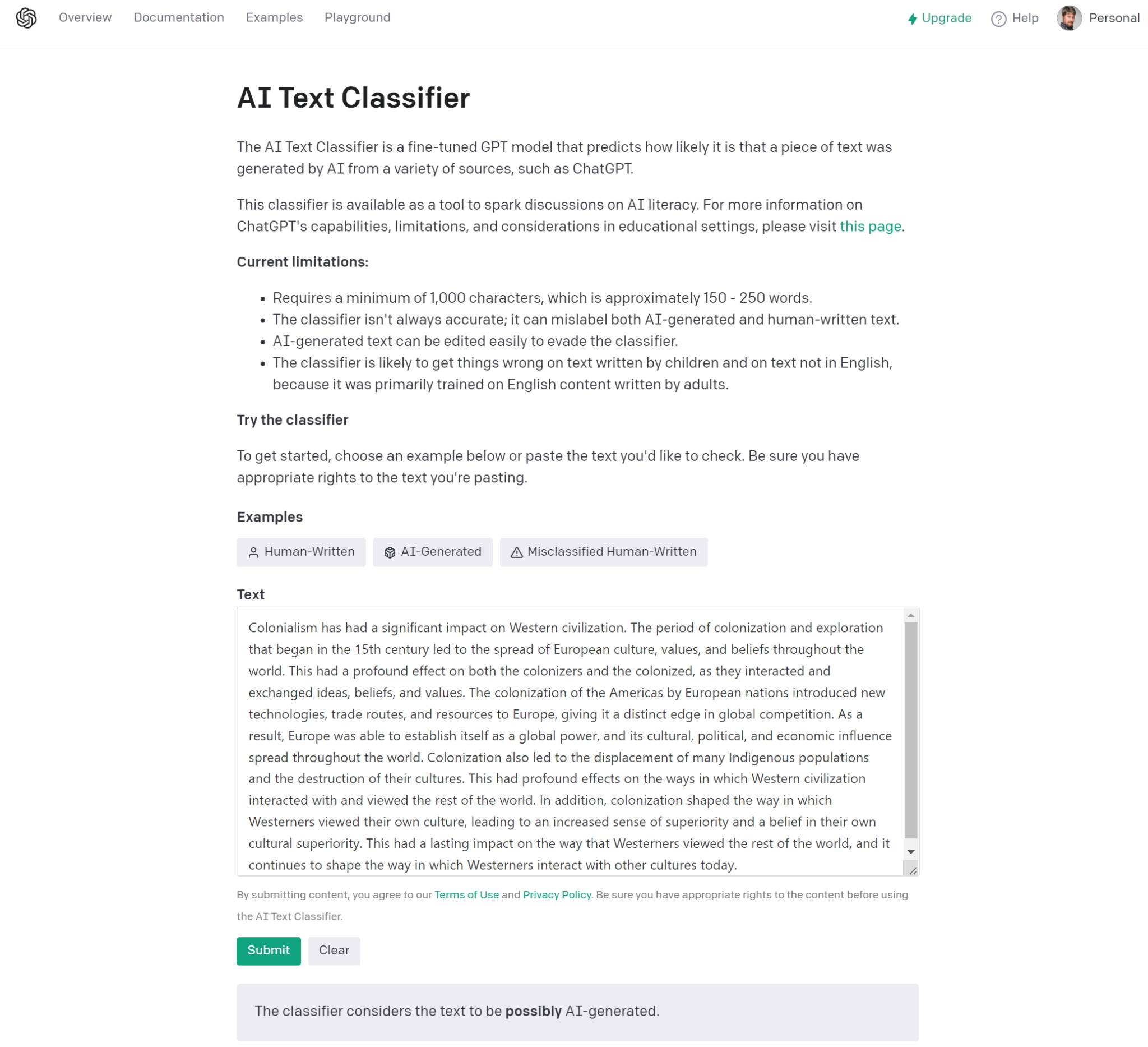

Avec Text Classifier pour ChatGPT, OpenAI entre dans la danse des vérificateurs de contenu généré par son chatbot conversationnel qui fascine autant qu’il inquiète. Le monde enseignant est particulièrement exposé à ce problème où les élèves ont rapidement perçu les avantages de ChatGPT. Une aide qui peut être assimilée à de la triche dans certains cas. Le problème est d'essayer de déterminer quelles réponses ont été écrites par un humain et lesquelles par une IA. Or, l'outil de détection d'OpenAI a une faiblesse : il est assez facile à tromper. Dans un communiqué, la start-up a déclaré que Text Classifier avait identifié 26 % des textes rédigés par l'IA comme authentiquement humains, et il a considéré que 9 % des textes écrits par un humain étaient rédigés par l'IA. Dans le premier cas, cela signifie que le service n'a pas réussi, en moyenne, à détecter environ un quart des personnes qui ont utilisé l'IA sans le signaler.

De plus, il est assorti d'un certain nombre de réserves. D’abord, plus il y a de mots, mieux c'est : « En deçà de 1 000 caractères, l'outil a de fortes chances de se tromper », déclare OpenAI. Autre contrainte, il ne fonctionne qu'avec l'anglais et ne peut absolument pas déterminer si du code a été écrit par une IA ou un humain. « Enfin, les textes rédigés par l'IA peuvent être modifiés pour échapper au Text Classifier », a précisé la firme. Bref, elle reconnait sans ambages dans son communiqué « il n'est pas totalement fiable ».

Des tests peu concluants

Lors d'un test rapide par notre confrère de PC World, l’analyseur n'a pas pu dire si un passage choisi au hasard de « L'attrape-cœurs » de J.D. Salinger avait été écrit par l'IA, mais il a déclaré qu'il était très peu probable qu'un passage similaire d'« Alice au pays des merveilles » de Lewis Carroll ait été généré par l'IA. L’outil a également accepté un article pris au hasard rédigé par Brad Chacos, le rédacteur en chef de PCWorld. Malheureusement, ChatGPT était hors service quand nous avons essayé d'y accéder, mais le moteur de recherche émergent You.com, qui intègre son propre chatbot IA, a servi de plateforme de test supplémentaire.

L'outil de détection d'OpenAI en action. (Crédit : OpenAI)

You.com est diffèrent de ChatGPT dans le sens où il cite (désormais) ses sources. Ainsi, la commande : « Écrire un texte expliquant comment le colonialisme a façonné la civilisation occidentale », a cité Wikipédia, Britannica.com et un séminaire d'honneur de l'université du Tennessee dans son chatbot YouChat. Classifier Text d'OpenAI l'a identifié comme pouvant être généré par l'IA. Il a trouvé le même résultat pour une histoire courte générée par l'IA sur un émeu qui pouvait voler. Plus tard, cependant, nous avons pu repéré une réponse similaire à notre question sur le colonialisme sur ChatGPT. « L’outil considère que le texte n'est pas clair s'il est généré par l'IA », a-t-il conclu. Une requête similaire de test de fiction sur ChatGPT, à savoir « Écrire une histoire courte sur un chien qui construit une fusée et vole vers la lune », a également généré la même réponse peu claire. Donc, non seulement l'outil d'OpenAI génère des conclusions floues, mais il n'est pas suffisant pour déterminer quels résultats sont générés par l'IA.

Essayez Hive Moderation

OpenAI n’a pas le monopole de la détection de contenu généré par l’IA. Il existe d’autres solutions comme DetectGPT ou ZeroGPT. C’est le cas aussi de Hive Moderation, une solution créée par un ingénieur ML de Hive AI, et qui semble fonctionner. D'une part, elle renvoie un pourcentage de confiance, c'est-à-dire la probabilité que l'échantillon de texte contienne du texte généré par une IA. Dans notre question sur le colonialisme (voir plus haut), avec des réponses provenant à la fois de ChatGPT et de You.com, Hive Moderation a indiqué qu'il était probable qu'elle contienne du texte IA, avec un pourcentage de confiance de 99,9 %. L'histoire courte du chien et de sa fusée a généré la même probabilité de 99,9 %. L’outil a également estimé à 0 % la probabilité que les extraits d'« Alice au pays des merveilles » et de « L'attrape-cœurs » soient générés par l'IA, comme on pouvait s'y attendre. L’article sur Nvidia rédigé par Brad Chacos de PCWorld.com a aussi été acceptée, avec une probabilité absolue de 0 % qu'elle ait été rédigée par une IA.

Hive Moderation, en revanche, a fourni des résultats clairs et sûrs. (Crédit : Hive Moderation)

Nous avons même testé cette question dans ChatGPT : « Rédiger un texte expliquant comment le colonialisme a façonné la civilisation occidentale, mais de manière à ce qu'il ne soit pas évident qu'une IA l'ait écrit ». La modération Nope-Hive l'a également détecté. En fait, dans tous les tests que nous lui avons fait subir, Hive Moderation a identifié à chaque fois, avec un pourcentage de confiance clair, les échantillons générés par l'IA et ceux qui ne l’étaient pas. Ainsi, même si Text Classifier doit être regardé en raison de son lien avec OpenAI, il semble que Hive Moderation est meilleur pour détecter les textes rédigés par une IA et ceux qui ne le sont pas. A noter qu’Open AI promet dans les prochaines versions de ChatGPT d’intégrer des « watermark » (empreintes) pour faciliter cette détection.

j'ai fait le test avec deux court paragraphe un trés court que j'ai écrit et un par chat gpt ( en changeant deux, trois mot max ) et plusieurs comparateur disent que mon texte est plus problable d'être fait par une ia ( 30 % pour celui de chat gpt et 99.9 pour le mien ...

Signaler un abus