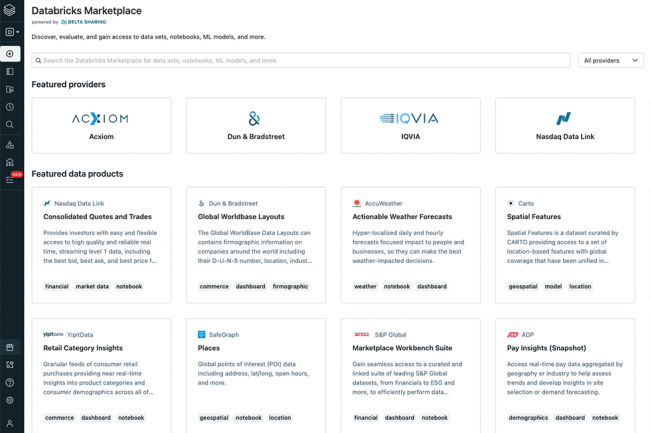

Parallèlement à la mise en open source de toutes les API de Delta Lake (voir encadré), Databricks a lancé une marketplace de données et complété les fonctions d'ingénierie de sa dataplatform lors de son sommet annuel Data+AI. La place de marché sera disponible dans les mois à venir. Elle devrait donner aux entreprises les moyens de partager des données et des actifs analytiques tels que des tableaux, des fichiers, des modèles d'apprentissage automatique, des notebooks (pour la data science) et des tableaux de bord, a déclaré l'éditeur américain, en ajoutant que les données partagées n'auront pas besoin d'être déplacées du stockage cloud ni répliquées. La place de marché accélérera le travail sur les données et le développement d'applications, car les entreprises accéderont à des jeux de données déjà créés qu'elles n'auront donc pas à construire elles-mêmes et pourront également s'abonner à des tableaux de bord analytiques. Un autre volet mis en avant par l'éditeur est la monétisation du patrimoine informationnel

Selon les analystes, la place de marché dévoilée par Databricks s'apparente à celle de son concurrent Snowflake en termes de conception et de stratégie. « Chaque grande plateforme d'entreprise (y compris Snowflake) doit disposer d'un écosystème d'applications viable pour être véritablement une plateforme et Databricks ne fait pas exception. Elle cherche à devenir un marché central pour les actifs de données et doit être considérée comme une opportunité immédiate pour les éditeurs de logiciels indépendants et les développeurs d'applications qui cherchent à s'appuyer sur Delta Lake », a déclaré Hyoun Park, analyste en chef chez Amalgam Insights.

Dans le sillage de Snowflake

Comparant les marketplaces de Databricks et de Snowflake, Doug Henschen, analyste principal chez Constellation Research, constate que, dans sa forme actuelle, celle de Databricks est très récente et ne concerne que le partage des données, à la fois en interne et en externe, contrairement à celle de Snowflake qui a ajouté des intégrations et un support pour la monétisation des données. Dans un effort pour promouvoir la collaboration sur les données avec d'autres entreprises de manière sécurisée, la société a déclaré qu'elle préparait un environnement, baptisé Cleanrooms, qui sera disponible dans les mois à venir.

Une Cleanroom se présentera comme un environnement sécurisé au sein duquel une entreprise va pouvoir anonymiser, traiter et stocker des informations personnellement identifiables, afin de pouvoir mettre celles-ci à disposition pour transformer les données de manière à ne pas enfreindre les règles de confidentialité. Les salles d'anonymisation de Databricks apporteront un moyen de partager et de joindre les données entre les entreprises sans avoir besoin de les répliquer, a déclaré la firme, ajoutant que les entreprises pourront ainsi collaborer avec leurs clients et partenaires sur n'importe quel cloud avec la flexibilité d'exécuter des calculs et des charges de travail complexes en utilisant à la fois SQL et des outils de datascience, y compris Python, R et Scala. La promesse d'être conforme aux normes de confidentialité est une proposition intéressante, a déclaré M. Park, d'Amalgam Insights, ajoutant que le test décisif pour la technologie sera son adoption dans les services financiers, par les services gouvernementaux, les secteurs juridiques et de la santé qui ont des directives réglementaires strictes.

Des outils de traitement et de gestion des données mis à jour

L’éditeur a également ajouté à sa plateforme d'autres outils de traitement des données. L'un des derniers services, Enzyme, est une couche d'optimisation supplémentaire destinée à accélérer le processus d'extraction, de transformation et de chargement (ETL) dans Delta Live Tables, que Databricks a généralisé en avril de cette année. « La couche d'optimisation est axée sur la prise en charge des pipelines d'intégration de données incrémentiels automatisés utilisant Delta Live Tables par une combinaison d'analyse du plan de requête et des exigences de modification des données », explique Matt Aslett, directeur de recherche chez Ventana Research. Et cette couche, selon l’analyste Doug Henschen, devrait « cocher une autre série de capacités attendues par les clients, ce qui la rendra plus compétitive en tant qu'alternative aux plateformes conventionnelles d'entrepôts de données et de datamarts ».

Databricks a également annoncé la prochaine génération de Spark Structured Streaming, baptisée Project Lightspeed, sur sa plateforme Delta Lake qui, selon lui, réduira les coûts et la latence en utilisant un écosystème élargi de connecteurs. Databricks présente Delta Lake comme un data lakehouse, construit sur une architecture de données qui offre à la fois des capacités de stockage et d'analyse, par opposition aux lacs de données, qui se contentent de stocker les données au format natif, et aux entrepôts de données, qui de leur côté stockent des données structurées (souvent au format SQL) pour une interrogation rapide. « Le streaming de données est un domaine dans lequel Databricks se différencie de certains autres fournisseurs de datalakes et qui suscite de plus en plus d'intérêt à mesure que les applications en temps réel basées sur le streaming de données et d'événements deviennent plus courantes », a déclaré M. Aslett, de Ventana Research. La deuxième itération de Spark, selon M. Park, montre l'intérêt croissant de Databricks pour la prise en charge de sources de données plus petites pour l'analyse et l'apprentissage automatique. « Le machine learning n'est plus seulement un outil pour le big data massif, mais aussi un précieux mécanisme de retour et d'alerte pour les données en temps réel et distribuées », a déclaré l'analyste d'Amalgam Insights.

La gouvernance des données au cœur des solutions

En outre, afin d'aider les entreprises en matière de gouvernance des données, la société a lancé le Data Lineage for Unity Catalog, qui sera généralement disponible sur AWS et Azure dans les semaines à venir. « La disponibilité générale d'Unity Catalog permettra d'améliorer les aspects de sécurité et de gouvernance des actifs du lakehouse, tels que les fichiers, les tables et les modèles ML. C'est essentiel pour protéger les données sensibles », a déclaré Sanjeev Mohan, ancien vice-président de recherche pour le big data et l'analytique chez Gartner.

La société a également lancé Databricks SQL Serverless (sur AWS) pour offrir un service entièrement géré pour maintenir, configurer et mettre à l'échelle l'infrastructure cloud sur le lakehouse. Parmi les autres mises à jour, citons une fonction de fédération de requêtes pour Databricks SQL et une nouvelle fonctionnalité pour SQL CLI, pour exécuter des requêtes directement depuis un ordinateur local. La fonction de fédération permet aux développeurs et aux spécialistes des données d'interroger des sources de données distantes, notamment PostgreSQL, MySQL et AWS Redshift, sans avoir à extraire et à charger les données à partir des systèmes sources.

Commentaire