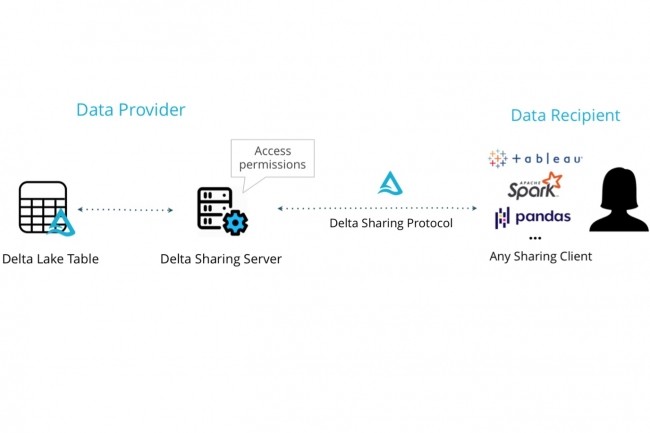

Partager des données de façon sécurisée est un besoin récurrent dans de nombreux secteurs d’activité. Comment les mettre à disposition d’utilisateurs ou de partenaires qui viendront les consommer au sein de l’entreprise ou depuis l’extérieur ? Sur ce terrain, un éditeur comme Snowflake développe sa technologie Secure Data Sharing, avec l’ambition de créer un vaste écosystème de partage de données. Databricks de son côté vient de lancer, sous le nom de Delta Sharing, un projet open source portant sur un protocole ouvert pour un partage de sécurisé en temps réel entre entreprises, indépendant de la plateforme où ces données résident.

Cette initiative, qui fait partie de son projet Delta Lake de création d’une architecture lakehouse, est soutenue par plusieurs fournisseurs de données, tels le Nasdaq, Intercontinental Exchange (ICE), Standard & Poor, SafeGraph et autres, ainsi que par AWS, Google Cloud et Tableau. Elle a été annoncée à l’occasion de la conférence Data + AI Summit. Pour Databricks, qui a été fondé par les créateurs d’Apache Spark et qui a depuis lancé Delta Lake, MLflow et Koalas, il s’agit du 5ème projet open source. Il sera confié à la fondation Linux.

Des jeux de données au format Apache Parquet

« Il y a un réel besoin de trouver un moyen de partager de la donnée, en toute sécurité, entre des entités internes et externes, providers et consommateurs, avec un traçage complet d’un point de vue gouvernance et fraîcheur de la donnée, et ce en limitant à la fois les éléments de copie de la donnée ou la nécessité de mettre en place des systèmes de partage comme on a pu le faire par le passé », nous a exposé Nicolas Maillard, directeur senior architecte solution de Databricks pour les régions Central & SEMEA. Il met en avant la volonté de s’appuyer sur des standards existants pour faciliter l’adoption du protocole et favoriser un écosystème d’échange de données ouvert, indépendamment de l’utilisation de la plateforme de gestion de données Databricks.

Le protocole Delta Sharing s’appuie sur la version 1.0 du projet open source Delta Lake (piloté par la fondation Linux) qui vient d’être livrée sur Apache Spark 3.1. Il peut être utilisé avec SQL et par des langages de programmation comme Python et R. Parmi les standards mis en oeuvre figure le format de stockage en colonnes Apache Parquet ce qui permettra d’exploiter le protocole dans les logiciels qui le prennent en charge. L’interrogation et la visualisation de données peut se faire avec des outils comme Azure Purview, Big Query de Google, AtScale, Collibra, Dremio, Immuta, Looker, Privacera, Qlik, Power BI et Tableau, énumère Databricks.

Bonjour ; je suis comme un certain nombre de français qui n'ont pas eu de notions d'Anglais ,j'ai lu votre texte ou beaucoup de mots Anglais qui ne signifient rien ou alors il faudrait les noter et passer de longues heures a chercher leurs signification (trop déroutant ) ;pour ma part je cherchais s'il existait une revue papier pour donner des directives pour débuter dans ZORIN .OS qui ressemble assez a Windows qui lui devient trop envahissant dans les ordinateurs et qui décide de couper le fonctionnement de certains programmes comme skype parce que l'on n'utilise pas les appels téléphoniques payants alors qu'en utilisant le portable ou la ligne ADSL ,les communications font partie de l'abonnement ;J'ai donc mis zorin.os sur un de mes appareils pour voir si je peux le maîtriser ,si oui je passerais mes autres appareils sur ce systeme mais pour l'instant je rame pas mal car je ne trouve pas de mode d'emploi ; merci de m'avoir lu .

Signaler un abus