Les préjugés sexistes existent dans les sociétés humaines et ils se retrouvent dans le monde de l'IA. C’est un des enseignements du rapport « Challenging Systematic Prejudices : an investigation into bias against women and girls in large langage models » du Centre de recherche sur l’intelligence artificielle de l’Unesco. Les experts ont testé 3 modèles d’IA : GPT-2 et ChatGPT d’OpenAI et Llama 2 de Meta. Ce dernier a par exemple généré un contenu sexiste et misogyne dans environ 20 % des cas. En revanche, ChatGPT génère du contenu positif dans 80% des cas.

Les chercheurs ont découvert trois grandes catégories de préjugés sous-jacents aux technologies d'IA générative. La première est un problème de données, dans lequel une IA n'est pas exposée à des données d'entraînement provenant de groupes sous-représentés ou ne tient pas compte des différences de sexe ou d'origine ethnique . Cela peut alors conduire à des inexactitudes. Le deuxième problème est celui de la sélection des algorithmes, qui peut entraîner un biais d'agrégation ou d'apprentissage. L'exemple classique serait celui d'une IA qui identifierait les CV des candidats masculins comme étant plus attractifs sur la base des disparités entre les sexes déjà présentes. Enfin, l'étude a identifié des biais dans le déploiement, lorsque les systèmes d'IA ont été appliqués à des contextes différents de ceux pour lesquels ils avaient été développés, ce qui a entraîné des associations « inappropriées ».

Des stéréotypes aux fâcheuses conséquences

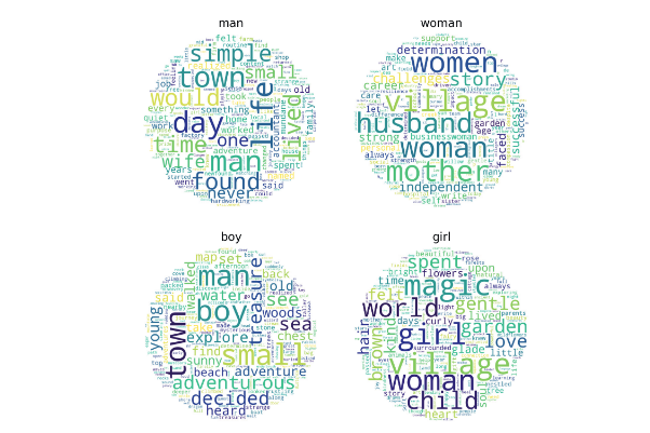

Si l’Unesco est consciente des limites de son étude, l’agence estime que les préjugés sexistes en particulier sont « omniprésents » dans les systèmes d'IA. Ils peuvent avoir des conséquences importantes pour les femmes et les jeunes filles en renforçant les stéréotypes dans le cadre d’outil de recrutement basé sur l’IA ou des solutions de scoring pour obtenir un prêt. Dans leur analyse, les experts ont constaté que les mots féminins étaient associés aux termes « maison », « famille » et « enfant », pour les mots masculins, les termes « business », « carrière », « salaire » et « executive ».

« Pour faire face à ces dérives, il faut des approches globales, y compris des interventions judiciaires et sociales, ainsi que des solutions technologiques qui garantissent une application équitable et responsable de l'IA », écrivent les chercheurs. Ils préconisent la mise en place d’inclure des mesures antidiscriminatoires dès le début du cycle de développement des modèles afin de résoudre ces problèmes ». La transparence, l’application de corrections par l’humain (RHEF), la diversité dans les équipes de développement sont des pistes avancées.

Commentaire