Selon Rishi Bommasani, diplômé de Institute for Human-Centered AI (HAI) à Stanford, les éditeurs modèles de fondation sont de moins en moins transparents. Par exemple, l’entreprise OpenAI, qui a le mot « ouvert » dans son nom, a clairement déclaré qu'elle ne serait pas transparente sur la plupart des aspects de son modèle phare, GPT-4. Et ce manque d'information a des implications pour toutes les parties prenantes. Il est par exemple plus difficile pour les autres sociétés de savoir si elles peuvent créer en toute sécurité des applications reposant sur ces modèles ainsi que pour les universitaires de s'appuyer sur ces derniers pour leurs recherches. Il en va de même pour les décideurs politiques qui ont du mal à concevoir des cadres réglementant cette technologie et les consommateurs peuvent difficilement comprendre les limites des modèles ou demander réparation pour les préjudices subis en l’état. Ainsi, dans un objectif d’évaluation de la transparence, Rishi Bommasani et le directeur du Center for Research on Foundation Models (CRFM), Percy Liang, ont réuni une équipe multidisciplinaire de Stanford, du MIT et de Princeton pour concevoir un système de notation appelé Foundation Model Transparency Index (indice de transparence des modèles de fondation ou FMTI).

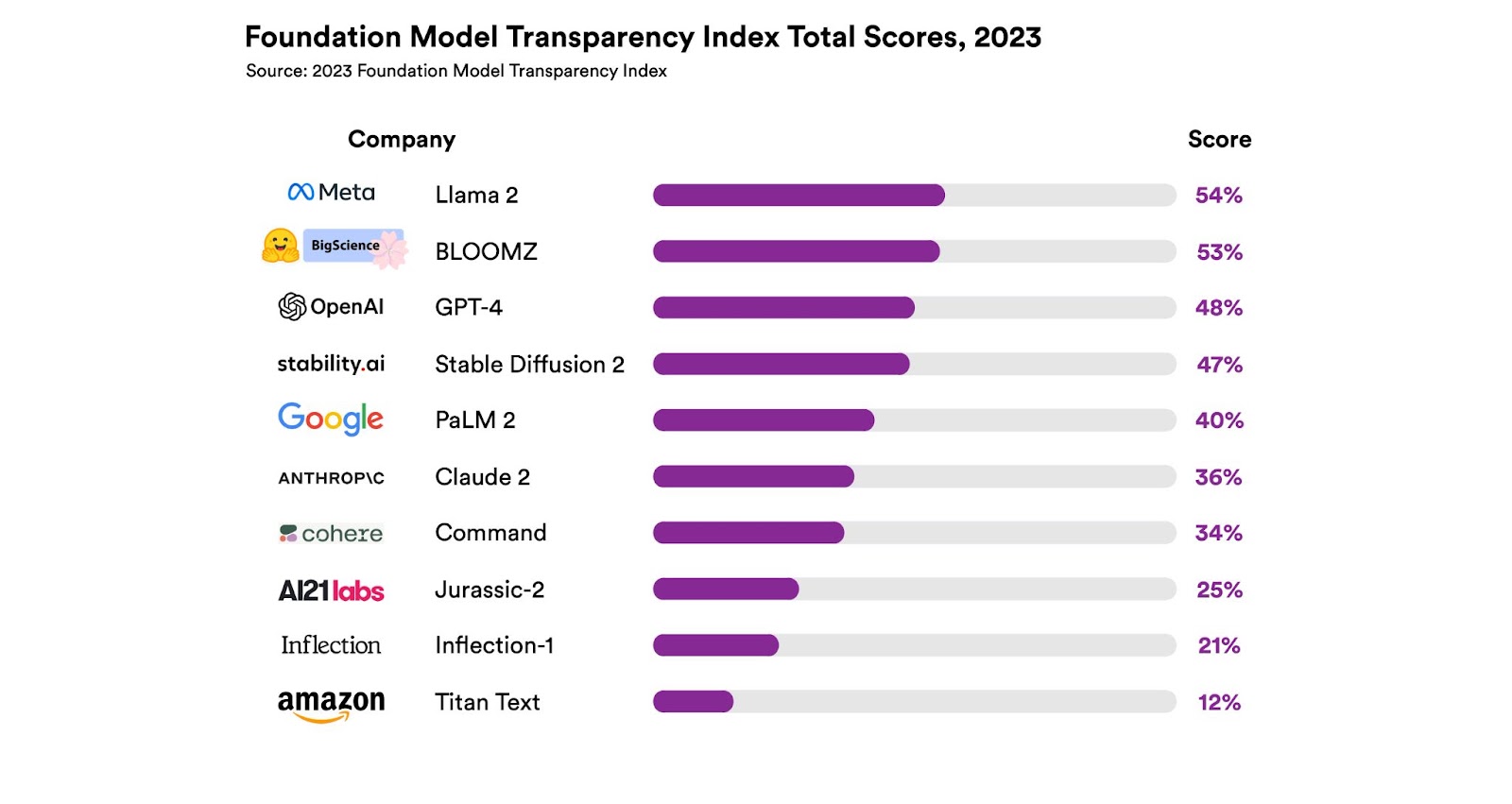

Cet indice évalue 100 aspects différents de la transparence, depuis la manière dont une entreprise construit un modèle de fondation, son fonctionnement et son utilisation en aval. Pour ce travail, l’équipe précise avoir évalué 10 grands acteurs du secteur en s’appuyant sur ces critères. Anecdote amusante : les entreprises évaluées n’ont pas été choisies au hasard. Neuf d’entre elles se sont volontairement engagées auprès de l'administration Biden à gérer les risques posés par l'IA. Et pourtant, les actes n’ont pas suivi la parole. Le constat est le suivant : il y a beaucoup de place pour l'amélioration. En effet, les scores les plus élevés, compris entre 47 et 54, ce qui montre clairement une carence d'information, tandis que le score le plus bas se situe à 12. « Il s'agit d'une indication assez claire de la façon dont ces entreprises se comparent à leurs concurrents, et nous espérons qu'elle les incitera à améliorer leur communication », commente Rishi Bommasani.

Meta, bien meilleur élève qu’Amazon en matière de transparence

Sur les 100 indicateurs, environ un tiers concernent la manière dont les acteurs construisent leurs modèles, y compris les informations sur les données d'entraînement, la main-d'œuvre utilisée pour les créer et les ressources informatiques impliquées. Un autre tiers concerne le modèle lui-même, notamment ses capacités, sa fiabilité, ses risques et leur atténuation. Enfin, le dernier tiers concerne la manière dont les modèles sont utilisés en aval, y compris la divulgation des politiques de l'entreprise concernant la distribution des modèles, la protection des données des utilisateurs et le comportement des modèles, et si l'entreprise offre des possibilités de retour d'information ou de réparation aux personnes concernées.

Après avoir élaboré une première version des notes du FMTI, l'équipe a donné aux entreprises la possibilité d'y répondre. L'équipe a ensuite examiné leur contre-expertise et apporté les modifications nécessaires. À l’issue de ce travail, c’est Meta qui obtient le score le plus élevé, soit de 54 %, jugé toutefois « peu impressionnant » par les chercheurs. « Nous ne devrions pas considérer Meta comme le but à atteindre, comme si tout le monde devrait essayer d'atteindre Meta », explique Rishi Bommasani. « Nous devrions estimer que tout le monde essaie d'atteindre 80, 90, voire 100 » ajoute-t-il. Meta est suivi de Hugging Face et son modèle Bloomz puis OpenAI et son modèle GPT-4. Bon dernier de la liste établie de dix entreprises technologiques, Amazon et son modèle Titan obtiennent le score médiocre de 12 %. Peut mieux faire donc.

Graphique classant les 10 entreprises de modèles de fondations, avec le Llama 2 de Meta en haut et le Titan Text d'Amazon en bas. (Crédit : HAI Stanford)

Face à un marché qui mûrit, les éditeurs doivent faire preuve de transparence

Dans l’article publié, les chercheurs estiment qu’au-delà de ces résultats, ce qui s’avère être plus important, ce sont les indicateurs pour lesquels presque toutes les entreprises ont obtenu des résultats médiocres. « Par exemple, aucune entreprise ne fournit d'informations sur le nombre d'utilisateurs dépendant de son modèle ou de statistiques sur les zones géographiques ou les secteurs de marché qui utilisent son modèle. La plupart des sociétés ne divulguent pas non plus la mesure dans laquelle du matériel protégé par des droits d'auteur est utilisé comme données de formation. Elles ne divulguent pas non plus leurs pratiques en matière de travail, ce qui peut être très problématique » est-il indiqué.

Jugées essentielles, ces informations relatives aux technologies que nous pourrions tous, être, un jour, amenés à utiliser régulièrement, doivent être publics. « À mesure que le marché des modèles de fondation mûrit et se consolide, et que les entreprises progressent peut-être vers une plus grande transparence, il sera important de tenir l’indice à jour, précise Rishi Bommasani. Pour faciliter cette tâche, l'équipe demande aux entreprises de divulguer les informations relatives à chacun des indices du FMTI en un seul endroit, ce qui leur permet par ailleurs d'obtenir un point supplémentaire dans cette notation. « Ce sera beaucoup mieux si nous n'avons qu'à vérifier les informations plutôt que de les rechercher », ajoute Rishi Bommasani.

La transparence jugée primordiale dans la régulation de ces modèles

Qui parle de clarté doit soi-même en faire preuve. L’équipe de chercheurs a appliqué à la lettre ses principes et publié un document détaillé de 100 pages sur la méthodologie et les résultats, en complément de l’indice lui-même, qui comporte toutes les données sur l'ensemble des indicateurs, le protocole utilisé pour la notation, et les scores des développeurs avec leurs justifications. « Pour de nombreux décideurs politiques de l'UE, mais aussi des États-Unis, du Royaume-Uni, de la Chine, du Canada, du G7 et d'un grand nombre d'autres gouvernements, la transparence est une priorité politique majeure », explique Rishi Bommasani. Ainsi, via cet indice, l’équipe de chercheurs espère aider les décideurs politiques dans la construction d’une règlementation adaptée. Un clin d’œil à l’Union européenne qui travaille actuellement à l'adoption d'un réglement sur l'IA. La position du Parlement européen au moment d'entamer les négociations exige la divulgation de certains des indicateurs couverts par le FMTI, mais pas tous. En mettant en évidence les lacunes des entreprises, Rishi Bommasani espère que l’indice contribuera à orienter l'approche de l'UE vers le prochain projet.

« Le manque de transparence est depuis longtemps un problème pour les consommateurs de technologies numériques, note Rishi Bommasani. Nous avons vu des publicités et des prix trompeurs sur Internet, des modèles obscurs qui incitent les utilisateurs à faire des achats à leur insu, et une myriade de problèmes concernant la modération du contenu qui ont conduit à un vaste écosystème de fausses informations et de désinformation sur les réseaux sociaux », ajoute-t-il, avant de conclure : « En tant qu'utilisateurs finaux des systèmes d'IA, les consommateurs doivent savoir sur quels modèles de base ces systèmes reposent, comment signaler les préjudices causés par un système et comment demander réparation ».

Commentaire