L'agence de recherche du ministère de la défense américaine (Darpa) a l'IA dans le sang. Investissant tous azimuts des milliards de dollars dans de nombreux projets, cette dernière vient de confier à Intel en tant que principal fournisseur pour 4 ans et au Georgia Institute of Technology (Georgia Tech) un programme de pointe. Baptisé Guaranteeing Artificial Intelligence Robustness against Deception (GARD), ce dernier d'un montant de plusieurs millions de dollars constitue une initiative conjointe pour améliorer les défenses de cybersécurité contre les attaques de tromperie sur les modèles d'apprentissage automatique. « Grâce à des recherches innovantes sur les techniques de cohérence, nous collaborons à une approche visant à améliorer la détection d'objets et à améliorer la capacité de l'IA et du ML à répondre aux attaques adversaires », a expliqué Jason Martin, ingénieur principal chez Intel Labs et chercheur principal pour le programme Darpa GARD d'Intel.

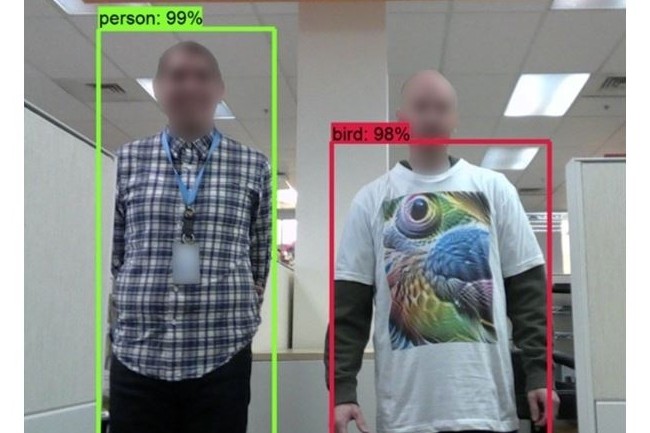

« Bien que rares, les attaques contradictoires tentent de tromper, altérer ou corrompre l'interprétation des données de l'algorithme ML. Comme les modèles AI et ML sont de plus en plus incorporés dans des systèmes semi-autonomes et autonomes, il est essentiel d'améliorer en permanence la stabilité, la sûreté et la sécurité des interactions inattendues ou trompeuses », explique le fondeur américain. « Par exemple, des classifications erronées et des interprétations erronées de l'IA au niveau des pixels pourraient conduire à des scénarios d'interprétation erronée et d'étiquetage erroné, ou des modifications subtiles d'objets réels pourraient confondre les systèmes de perception de l'IA ».

Améliorer la détection d'objets dans l'espace et la cohérence sémantique dans les images et vidéos

Les travaux menés conjointement par Intel et Georgia Tech portent en particulier sur l'amélioration de la détection d'objets dans l'espace ainsi que la cohérence sémantique aussi bien dans des images que des vidéos. « Les efforts de défense actuels sont conçus pour protéger contre des attaques adverses prédéfinies spécifiques, mais restent vulnérables aux attaques lorsqu'ils sont testés en dehors de leurs paramètres de conception spécifiés. GARD a l'intention d'aborder la défense ML différemment en développant des défenses à large base qui répondent aux nombreuses attaques possibles dans des scénarios donnés qui pourraient amener un modèle ML à classer ou à interpréter les données de manière erronée », précise Intel.

Commentaire