Anciennement connu sous le nom de Yottabyte, Verge.io a ajouté la virtualisation GPU à son logiciel de datacenter virtuel. Cela signifie qu’il peut dorénavant répartir les tâches de traitement basées sur le GPU, exactement comme le fait un hyperviseur avec les ressources CPU. L'infrastructure hyperconvergée (HCI) permet de construire un datacenter informatique étroitement intégré et configuré à partir de serveurs, de stockage et de réseaux standard, tout étant virtualisé. Mais le logiciel Verge-OS de Verge.io va plus loin, puisqu’il est capable de partitionner les ressources mises en commun dans ce qu'il appelle des datacenters virtuels (Virtual Data Centers, VDC). Un grand pool peut donc être partitionné en nombreux VDC constitués chacun de différentes configurations matérielles et logicielles. Une opération que réalise déjà un concurrent comme Liqid avec sa plateforme désagrégée.

Une fois que Verge-OS est installé, il met en commun les ressources matérielles, ou, comme le dit Yan Ness, le CEO de Verge.io, il les « liquéfie ». Ce pool de CPU, de mémoire, de stockage, et maintenant de GPU, peut être réparti entre plusieurs datacenters virtuels individuels. Ces VDC sont indépendants les uns des autres et peuvent passer d’un matériel physique à un autre ou être déplacés d’un datacenter physique à un autre. Les VDC sont capables d’exécuter une ou plusieurs applications et être sauvegardés sous forme de blueprint afin de charger immédiatement une configuration donnée, les datacenters virtuels étant commutables à la volée. Par exemple, il est possible de configurer un datacenter d'entreprise pour exécuter des applications métier pendant la journée, puis, la nuit, quand personne n'utilise le réseau, d’affecter le VDC à des tâches de calcul haute performance pour prendre le relais.

Le GPU après le stockage

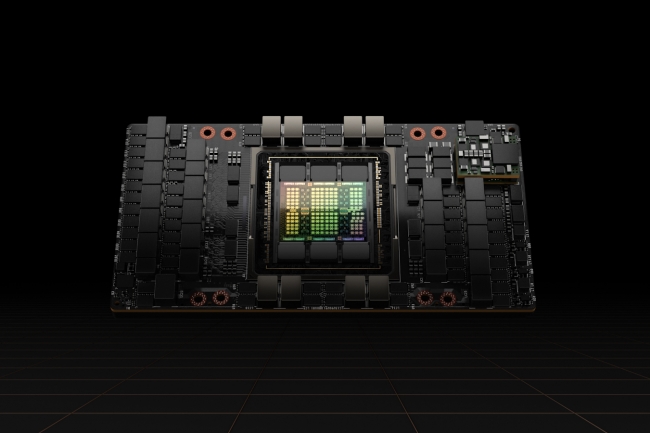

Grâce à la prise en charge des GPU par Verge-OS, les clients utilisent déjà les GPU pour les postes de travail à distance durant la journée et, la nuit, ils exécutent des charges de travail de ML et d'IA. « Les GPU ne représente qu’une ressource liquéfiée supplémentaire que l’on peut affecter à une VM ou à un datacenter virtuel n'importe où dans la pile », a déclaré M. Ness. À l'époque de Yottabyte, l'entreprise se concentrait sur le stockage défini par logiciel et le réseau défini par logiciel. Depuis, elle a élargi son offre pour inclure un hyperviseur, des outils de sauvegarde et de récupération, de gestion des systèmes et d'intégration. Le principal argument de vente de Verge-OS était que le client pouvait exploiter tous ces logiciels à partir d'une seule source plutôt que de plusieurs. Le vGPU n'est que le dernier élément matériel pris en charge par le VDC.

Verge.io n'exige pas du client de disposer du matériel le plus moderne pour exécuter son logiciel de virtualisation. « N’importe quel matériel le plus basique est compatible. Certaines de nos démonstrations fonctionnent sur des ordinateurs portables », a déclaré M. Ness. Pour utiliser les GPU de Nvidia avec Verge-OS, il faut une licence dite vGPU de Nvidia, qui permet d'utiliser leurs GPU dans un cloud ou un framework virtuel. Selon M. Ness, la technologie du logiciel offre des capacités d'auto-surveillance, d'auto-réparation et d'auto-optimisation. « On peut donc se passer de tous ces ingénieurs en stockage et autres pour s’assurer que les paramètres sont adaptés à ses charges de travail », a-t-il affirmé. Le CEO a déclaré que dans un avenir proche, Verge-OS prendra en charge les cartes AMD Instinct, mais Nvidia étant tellement dominant que Verge lui a donné la priorité. Á terme cependant, AMD sera pris en charge dans le partitionnement logiciel VDC. « Nous voulons faire un peu plus de tests », a dit le CEO. Le logiciel Verge-OS avec support vGPU est disponible dès maintenant sur Verge.io.

Commentaire