« Les modèles linguistiques (LM) présentent des capacités remarquables pour résoudre de nouvelles tâches à partir de quelques exemples ou instructions textuelles, surtout à grande échelle. Paradoxalement, ils se heurtent aussi à des difficultés avec des fonctionnalités de base, comme l'arithmétique ou la recherche de faits, où des modèles beaucoup plus simples et plus petits excellent ». Tel est le constat fait par une équipe de chercheurs de Meta la semaine dernière. Ces derniers ont publié un article sur arXiv – l’archive ouverte de prépublications électroniques d'articles scientifiques – et démontre que les modèles de language peuvent apprendre à utiliser des outils externes via des API simples et obtenir le meilleur des deux mondes.

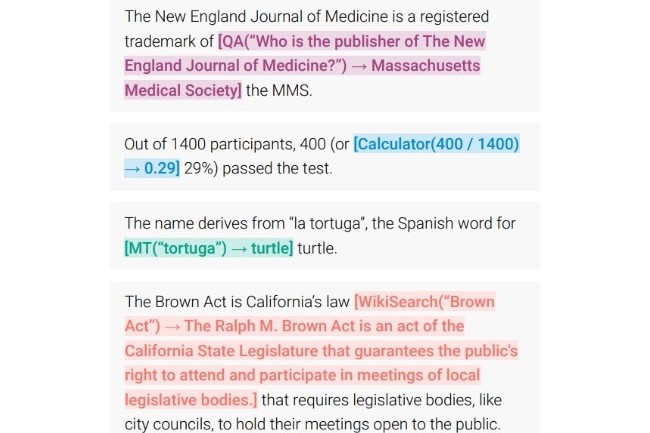

« Nous présentons Toolformer, un modèle entraîné à décider quelles API appeler, quand les appeler, quels arguments passer, et comment incorporer au mieux les résultats dans la prédiction de jetons futurs ». Il est précisé que ce travail de recherche est réalisé de manière auto-supervisée, ne nécessitant rien de plus qu'une poignée de démonstrations pour chaque API et donc sans conseil humain explicite. Pour l’expérience, les chercheurs ont incorporé une gamme d'outils, dont une calculatrice, un système de Q&A, deux moteurs de recherche différents, un système de traduction et un calendrier (les noms des outils n’ont pas été précisés). Le résultat est probant : Toolformer obtient des performances nettement améliorées pour une variété de tâches en aval, souvent en concurrence avec des modèles beaucoup plus grands, sans pour autant sacrifier ses capacités de modélisation du langage.

Les performances de GPT-3 dépassées

Pour rappel, Toolformer est basé sur un modèle GPT-J (un modèle de langage causal de type GPT-2 formé sur l'ensemble de données Pile) pré-entraîné avec 6,7 milliards de paramètres. Les expériences menées par les chercheurs sur diverses tâches utilisant des outils semblent démontrer que Toolformer atteint des performances bien meilleures que le modèle GPT-3 pourtant beaucoup plus grand, qui contient 175 milliards de paramètres. François Yvon, chercheur au CNRS, commente la capacité à spécialiser des LLM via le renforcement sur des corpus de données particuliers : « On arrive effectivement à spécialiser ces modèles, en réduisant leur taille et en les entraînant sur des corpus de données spécifiques. Par exemple, pour effectuer des tâches spécifiques dans un contexte professionnel ou pour produire des textes dans des langues particulières. Sur le projet Bloom (un projet scientifique de LLM mené sur une plateforme de science ouverte, auquel participe largement la recherche française dont le CNRS, NDLR), des versions plus petites, avec 7 milliards de paramètres contre 176 pour le modèle général, ont ainsi été mises en œuvre. »

L’utilisation d’outils comme Toolformer constitue, certes, une avancée majeure dans l’usage des modèles de langage d’IA, mais comporte malgré tout une part de risque. En effet, la capacité à faire appel à des API pourrait nuire aux données des utilisateurs dans les applications. De même, le recours à des moteurs de recherche peut être une source de partage de fausses informations ou d’informations erronées en l'absence de système de fact-checking.

Commentaire