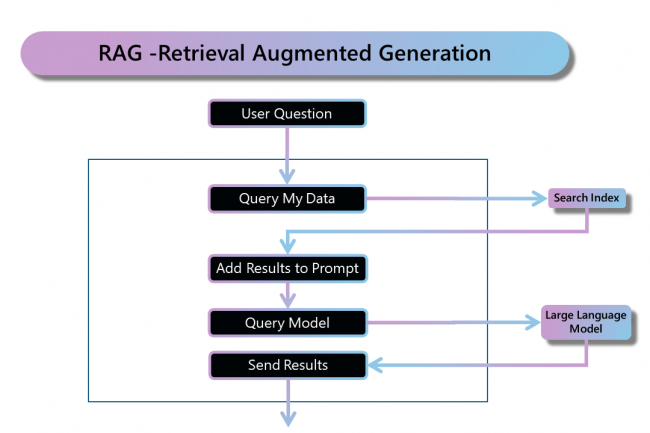

Avec l'essor de l'IA, les entreprises s’approprient progressivement les grands modèles de langage (LLM). Toutefois, l’intégration de ces outils restent un défi de taille en raison de leur complexité ainsi que du besoin de maintien de la gouvernance. Dans ce sens, Microsoft Azure a introduit GPT-RAG, une bibliothèque pour utiliser la technologie RAG (Retrieval Augmentation Generation) dans le cloud. Ce service utilise « Cognitive Search pour la recherche et les LLM d'Azure OpenAI pour alimenter les expériences de type ChatGPT et Q&A » précise Microsoft sur la page GitHub dédiée.

Cet accélérateur dispose d'un framework de sécurité robuste et de principes zero trust, pour garantir que les données sensibles sont bien traitées. Pour cela, GPT-RAG se sert de plusieurs outils : Azure Virtual Network, Front Door pour le WAF (Web Application Firewall), Bastion pour l'accès sécurisé au bureau à distance, et Jumpbox pour l'accès aux VM dans les sous-réseaux privés. Microsoft présente son outil comme « idéal pour les organisations qui passent des phases d'exploration et de PoC à la production à grande échelle et aux MVP ». Notons également que GPT-RAG offre une mise à l'échelle automatique, une adaptabilité aux charges de travail de pointe et un stockage analytique potentiel, notamment en intégrant des éléments tels que Cosmos DB. RAG facilite par ailleurs les mises à jour périodiques des données sans qu'il soit nécessaire de procéder à un réglage fin, ce qui en fait un atout de taille.

GPT-RAG, un garant fiable pour utiliser les LLM en entreprise

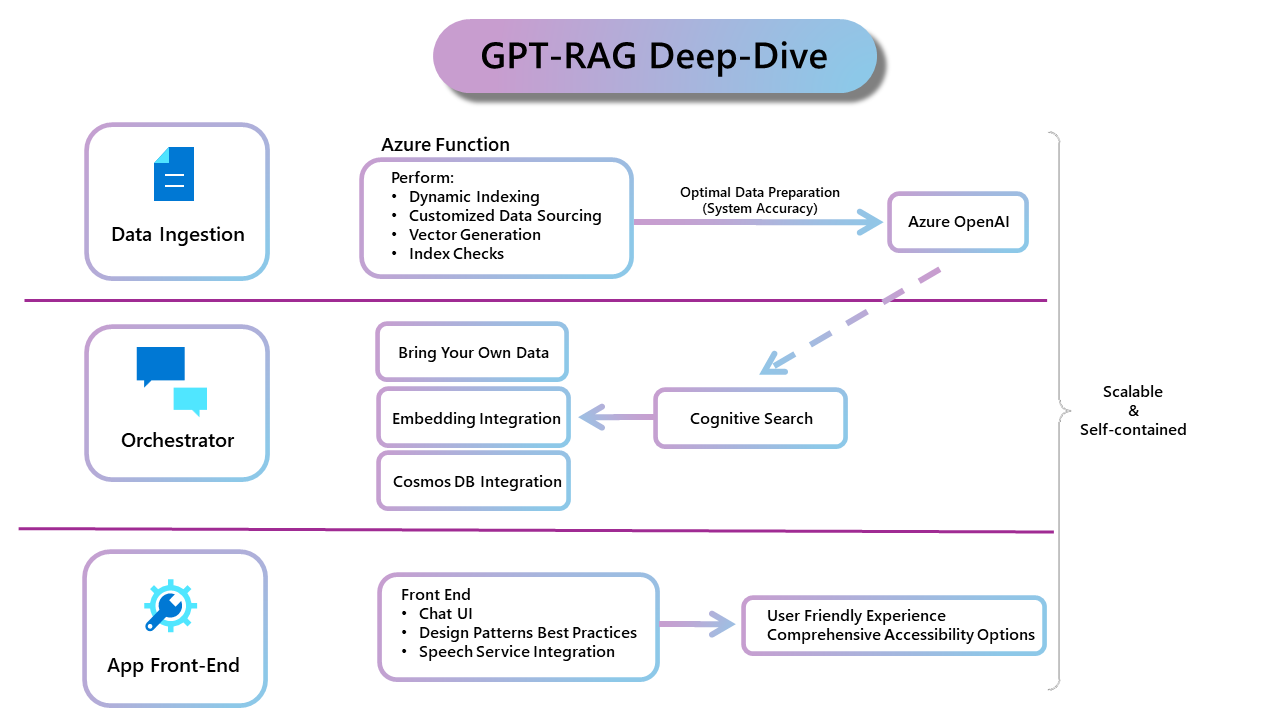

En complément, les chercheurs de GPT-RAG soulignent qu'il dispose d'un système d'observabilité complet, garantissant ainsi une optimisation du déploiement des LLM en entreprise. La base de GPT-RAG comprend trois composants clés : l'ingestion de données, un Orchestrator et une application frontale. L’ingestion de données aide à optimiser la préparation des données pour Azure OpenAI tandis que l’Orchestrator garantit l’évolutivité et la cohérence des interactions utilisateur. Enfin, l’application frontale, construite avec Azure App Services, offrant une interface utilisateur fluide et évolutive.

Zoom sur l'architecture de GPT-RAG : ingestion des données, Orchestrator et une interface utilisateur "App front-end". (Crédit : Microsoft)

Microsoft ajoute que Databricks est l'un de ses partenaires les plus stratégiques avec certains des services de données sur Azure. Une co-innovation qui se traduit notamment par l'interopérabilité d'Azure Databricks avec Microsoft Fabric, et la façon dont le premier tire parti d'Azure OpenAI pour offrir des expériences d'IA. « Cela signifie que les clients peuvent profiter des LLM dans Azure OpenAI lorsqu'ils construisent des capacités d'IA telles que des applications RAG sur Azure Databricks, puis utiliser Power BI dans Fabric pour analyser les résultats », précise la firme. Finalement, GPT-RAG s’avère être un outil garant d’une utilisation rationnelle des LLM par les entreprises, aidant ces dernières à intégrer et à mettre en œuvre les moteurs de recherche, évaluer les documents et créer des robots de qualité. Le tout en mettant l’accent sur la sécurité, l'évolutivité, l'observabilité et l'IA responsable.

Commentaire