Le sujet de la reconnaissance faciale est délicat et polémique. Les fournisseurs de solutions s'interrogent au point de prendre du recul sur leurs propres outils. C'est ce que vient de décider Microsoft dans un message publié sur son blog en supprimant l'accès à un certain nombre de ses outils de reconnaissance faciale alimentés par l'intelligence artificielle. Cela inclut un de ses services conçu pour identifier les émotions des personnes à partir de vidéos et d'images. Intitulé « Investissements responsables dans l'IA et mesures de protection pour la reconnaissance faciale », le message signé par Sarah Bird, chef de produit principal du groupe et responsable de l’IA pour Azure AI, vient compléter le document « règles d’IA responsable » de 27 pages également publié par l'éditeur. L’entreprise fait ainsi un point sur les objectifs de la firme en matière d’IA équitable et digne de confiance et plus précisément en matière de reconnaissance faciale. Elle précise que dans le cadre de l’alignement de ses produits sur ces règles, elle limitera l'accès aux outils de reconnaissance faciale disponibles via ses services AzureFace API, Computer Vision et Video Indexer.

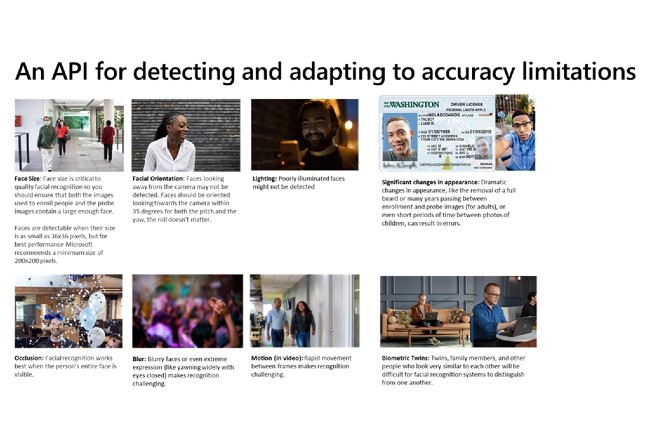

« À partir d'aujourd'hui, les nouveaux clients doivent demander un accès pour utiliser les opérations de reconnaissance faciale dans Azure Face API, Computer Vision et Video Indexer. Les clients existants ont un an pour demander et recevoir l'autorisation de continuer à accéder aux services de reconnaissance faciale en fonction des cas d'usage qu'ils ont fournis » est-il précisé. En introduisant l'accès limité, Microsoft ajoute une couche supplémentaire de contrôle à l'utilisation et au déploiement de la reconnaissance faciale et veut garantir un usage responsable. De plus, à partir du 30 juin 2023, les clients existants ne pourront plus accéder aux fonctionnalités de reconnaissance faciale si leur demande n'a pas été approuvée. Cependant, les capacités de détection du visage (y compris la détection du flou, de l'exposition, des lunettes, de la pose de la tête, des points de repère, du bruit, de l'occlusion et de la boîte de délimitation du visage) resteront généralement disponibles et ne nécessitent pas de demande.

Une controverse autour de la reconnaissance faciale

L’usage de la reconnaissance faciale a maintes fois été sujet à controverse, du fait des biais qui lui sont attribués. Par le passé, plusieurs études ont démontré que cette technologie est loin d'être parfaite, et qu'elle identifie souvent de manière erronée les femmes et les personnes à la peau plus foncée, et ce de manière disproportionnée. Lorsque l’IA est utilisée à des fins de surveillance, cela peut s’avérer compliqué et dangereux. En ce sens, AWS et Facebook ont de leur côté annoncé réduire leur utilisation de ces outils.

« Nous retirerons les capacités d'analyse faciale qui visent à déduire des états émotionnels et des attributs d'identité tels que le sexe, l'âge, le sourire, la pilosité faciale, les cheveux et le maquillage » précise la firme de Redmond. « Le potentiel des systèmes d'IA à exacerber les préjugés et les inégalités sociétales est l'un des préjudices les plus largement reconnus associés à ces systèmes », a déclaré Natasha Crampton, responsable de l'IA chez Microsoft, dans un blog, avant de poursuivre : « [Nos lois] n'ont pas résolu les risques uniques de l'IA ni les besoins de la société. En complément de l'action gouvernementale, nous reconnaissons également notre responsabilité d'agir ».

L’API Visage et le service Azure AI impactés

Dans le cadre d’une collaboration avec des chercheurs internes et externes à Microsoft, un travail sur les limites et les avantages potentiels de cette technologie a été réalisé afin de trouver des compromis. « Dans le cas spécifique de la classification des émotions, ces efforts ont soulevé d'importantes questions concernant la confidentialité, l'absence de consensus sur la définition des « émotions » et l'incapacité à généraliser le lien entre l'expression faciale et l'état émotionnel à travers les cas d'utilisation, les régions et les données démographiques » explique la firme sur son blog.

L'accès par API à des capacités de prédiction d'attributs sensibles ouvre également la voie à un large éventail de possibilités d'utilisation abusive de ces capacités, y compris l'exposition des personnes à des stéréotypes, à la discrimination ou à un refus injuste de services. Ainsi, la firme a pris la décision de ne pas prendre en charge, dans l'API Visage, un système à usage général qui prétend déduire les états émotionnels, le sexe, l'âge, le sourire, la pilosité faciale, les cheveux et le maquillage. La détection de ces attributs n’est plus disponible pour les clients qui ont jusqu'au 30 juin 2023 pour cesser de les utiliser avant retrait. Autre changement notoire, Microsoft a déclaré que ses règles d'IA responsable s'appliqueront également à la voix neuronale personnalisée d'Azure AI, un service de conversion de la parole en texte utilisé pour les outils de transcription. L'entreprise a expliqué qu'elle avait pris des mesures pour améliorer ce logiciel à la lumière d'une étude de mars 2020 qui a révélé des taux d'erreur plus élevés lorsqu'il était utilisé par des communautés afro-américaines.

Commentaire