A l’occasion du Computex 2024, à Taiwan du 4 au 7 juin avec des conférences de presse en amont, Nvidia a dévoilé des systèmes HPC GB200 NLV2 reposant sur son architecture GPU Blackwell qui, selon lui, permettront aux entreprises de « construire des usines d'IA et des centres de données pour conduire la prochaine vague d'innovations en IA générative ». La plateforme serveur modulaire MGX du fournisseur, annoncée l'année dernière au Computex 2023, prend désormais en charge les produits Blackwell. Les serveurs MGX annoncés au salon taïwanais disposent d’un ou plusieurs GPU Blackwell, de processeurs x86 ou Arm basés sur Grace, et de refroidissement par air ou par liquide pour répondre aux exigences des applications.

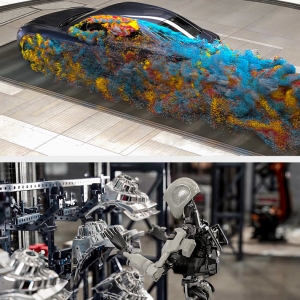

Lors d'une conférence de presse avant le salon, Nvidia a mis en avant la plateforme GB200 NVL2, une version plus petite de la GB200 NVL72 introduite en mars dernier, qui accélérera le traitement des données jusqu'à 18 fois, avec une efficacité énergétique 8 fois supérieure par rapport à l'utilisation de processeurs x86, grâce à l'architecture des puces Grace et des GPU Blackwell. Ce dernier, annoncé lors de l'événement GTC de Nvidia en mars dernier, est le successeur de l'architecture GPU Hopper, tandis que Grace est son design processeur basé sur Arm. Les systèmes GB200 contiennent des GPU Blackwell et des CPU Grace. « La plateforme GB200 NVL2 apporte l'ère de la GenAI à chaque centre de données », a déclaré Dion Harris, directeur de l'informatique accélérée chez Nvidia, lors du briefing presse. Le fournisseur a précisé que dix autres partenaires proposent désormais des systèmes avec l'architecture Blackwell. ASRock Rack, Asus, Gigabyte, Ingrasys, Inventec, Pegatron, QCT, Supermicro, Wistron et Wiwynn fourniront des systèmes pour l’IA en mode cloud, sur site, embarqués et en périphérie utilisant ses GPU et son réseau.

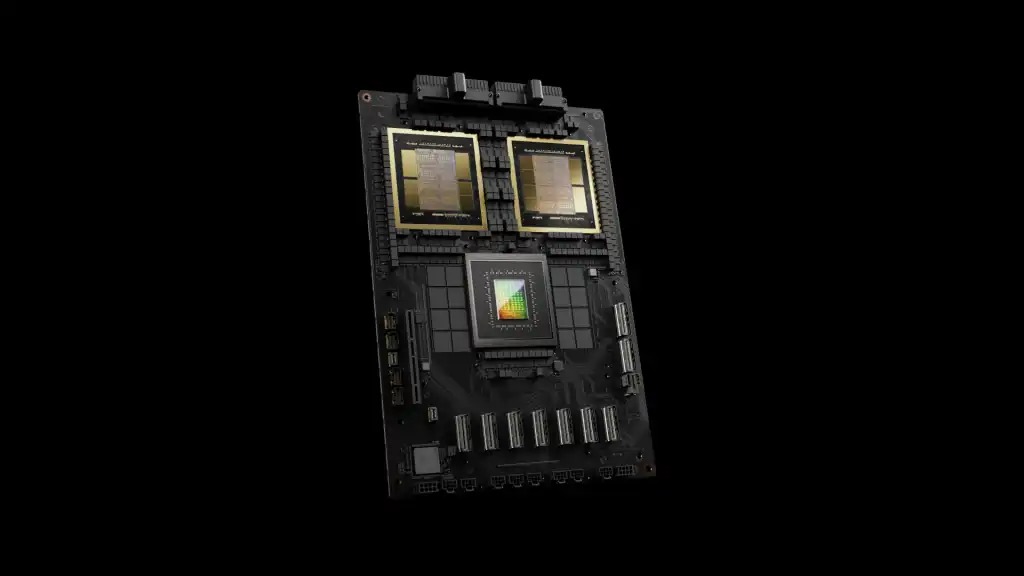

Les cartes GB200 combinent une puce Grace (sur base Arm) et des GPU Blackwell. (Crédit Nvidia)

« Nvidia a dominé et façonné l'architecture et l'infrastructure fondamentales nécessaires pour alimenter les innovations en intelligence artificielle », a déclaré Thomas Randall, directeur de la recherche sur le marché de l'IA à l’Info-Tech Research Group, dans un courriel. « Les annonces d'aujourd'hui renforcent cette affirmation, avec la technologie Nvidia intégrée au cœur de la fabrication informatique, des usines d'IA, et rendant l'IA générative largement accessible aux développeurs. »

Anxiété de performance

Cette performance, cependant, apportera de nouvelles préoccupations aux gestionnaires de centres de données, a déclaré Alvin Nguyen, analyste principal chez Forrester. « Je m'attends à ce que les systèmes alimentés par Blackwell soient le choix préféré pour les accélérateurs d'IA, tout comme les précédents accélérateurs Nvidia », a déclaré M. Nguyen dans un courriel. « Les variantes à puissance plus élevée nécessiteront un refroidissement liquide et cela entraînera des changements sur le marché des centres de données : tous les datacenters ne peuvent pas être mis à jour pour fournir l'électricité et l'eau nécessaires pour supporter ces systèmes en grand quantité. Cela entraînera des dépenses pour la mise à niveau des centres de données, la construction de datacenters, le recours à des partenaires (colocation, services cloud), et l'adoption d'accélérateurs moins gourmands en énergie de la part des concurrents. »

Sur le front des réseaux, Nvidia a annoncé que Spectrum-X, son accélérateur réseau Ethernet associant notamment son commutateur Spectrum-4 et sa carte SmartNIC BlueField-3, conçue pour les clouds IA dévoilée au Computex l'année dernière, est maintenant disponible. De plus, Amit Katz, vice-président du réseau chez Nvidia, a déclaré que le fournisseur accélère le rythme des mises à jour : des produits seront lancés chaque année pour offrir une bande passante et des ports accrus, ainsi que des ensembles de fonctionnalités logicielles améliorées et une programmabilité accrue.

L'architecture de la plateforme, avec ses DPU (unités de traitement de données) optimisées pour le trafic nord-sud et son SuperNIC optimisé pour le trafic est-ouest, de GPU à GPU, a du sens, a noté M. Nguyen de Forrester, mais elle ajoute de la complexité. « C'est une solution complémentaire qui aidera à favoriser l'adoption de solutions d'IA plus importantes comme les SuperPod et les usines d'IA », a-t-il dit. « Il y a une complexité supplémentaire à utiliser cela, mais cela aidera finalement les clients de Nvidia qui mettent en œuvre une infrastructure d'IA à grande échelle. » Mais, a-t-il ajouté, « Nvidia pousse l'infrastructure d'IA avec une autre norme technologique qui finira par être propriétaire, mais ils doivent le faire pour rester en avance sur la concurrence. »

Commentaire