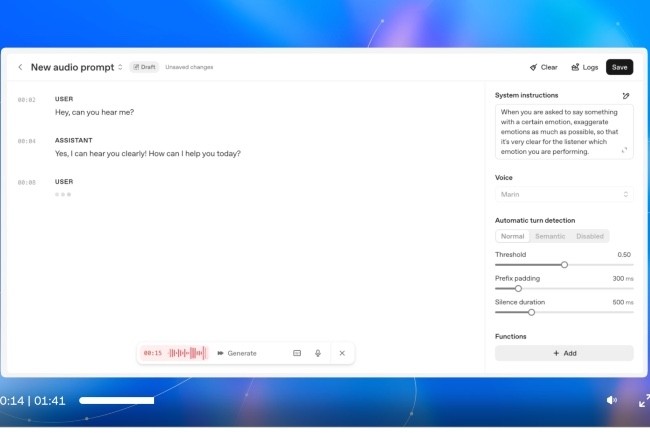

Sur l'IA adaptée à la voix, Microsoft et OpenAI ont décidé de ne pas faire cause commune. Chacun vient de livrer un modèle spécifique pour générer des paroles plus fluides, personnalisables et moins gourmandes en ressource matérielle. En premier lieu, OpenAI a lancé gpt-realtime, présenté comme son modèle vocal le plus avancé. Il génère une voix plus naturelle que les versions précédentes et peut changer de ton ou de langue en cours de phrase. Pour rendre les interactions encore plus réalistes, OpenAI a ajouté deux voix, Marin et Cèdre, tandis que les huit voix existantes ont été mises à jour pour bénéficier de ces améliorations. Le modèle se distingue dans le suivi des instructions, permettant aux développeurs de l’adapter à des tâches spécifiques, comme citer des articles d’une base de connaissances pour un assistant technique. Il prend également en charge un outil de téléchargement d’images, qui autorise un chatbot à recevoir des captures d’écran de logiciels défectueux, facilitant le diagnostic et l’assistance. gpt-realtime est accessible via l’API Realtime d’OpenAI, désormais disponible pour tous, avec la possibilité de sauvegarder et réutiliser des prompts complexes d’une session à l’autre.

Microsoft lance Mai-Voice-1 et Mai-1-preview

De son côté, Microsoft a présenté Mai-Voice-1, intégré à son assistant Copilot. Le modèle rend possible le résumé d’informations, comme la météo, ou de générer des podcasts à partir de textes. Selon la société, Mai-Voice-1 figure parmi les modèles vocaux les plus performants en termes de consommation matérielle, capable de générer une minute d’audio en moins d’une seconde sur un seul GPU. Le modèle alimente déjà les fonctionnalités Copilot Daily et Podcasts, et est également disponible dans Copilot Labs, où les utilisateurs peuvent tester des démonstrations expressives de synthèse vocale et de narration.

La société a également dévoilé Mai-1-preview qu'elle définit comme étant un modèle "entraîné de bout en bout et offre un aperçu des futures offres de Copilot". Un pas de plus pour Microsoft pour réduire la dépendance de Copilot à GPT d'OpenAI. Mai-1-Preview a été entraîné sur 15 000 accélérateurs H100 de Nvidia. Grâce à une architecture « mixture-of-experts », le modèle n’active qu’une partie de ses paramètres pour traiter une requête, réduisant ainsi la consommation matérielle. Mai-1-preview est actuellement accessible à un nombre limité de testeurs via une API et sera intégré progressivement à Copilot. Une version améliorée est prévue dans les prochains mois, entraînée sur un cluster GB200 de Nvidia.

Commentaire