Disponibles pour la plupart en open source, les grands modèles de langage peuvent être triturés dans tous les sens par des chercheurs de tous horizons. Une équipe de Microsoft s'est jeté à l'eau en dévoilant ses travaux autour d'un petit modèle de langage (small language model aka SML) développé à partir du 7B de la start-up Mistral AI. Baptisé Orca-Math, ce modèle a bénéficié de paramétrages et de personnalisation avec à la clé un rapport performances et précision très intéressant. « Orca-Math atteint 86,81% sur GSM8k pass@1, dépassant les performances de modèles beaucoup plus grands, y compris des modèles généraux (par exemple LLAMA-2-70, Gemini Pro et GPT-3.5) et des modèles spécifiques aux mathématiques (par exemple MetaMath-70B et WizardMa8th-70B). Notez que le modèle de base (Mistral-7B) atteint 37,83 % sur GSM8K », annoncent les chercheurs.

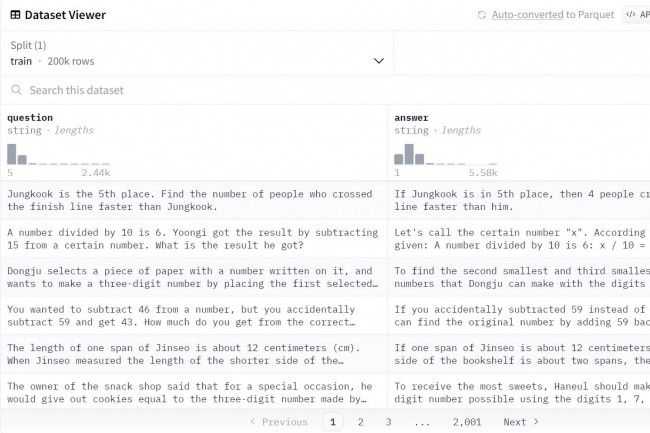

Selon leur point de vue, les performances de ce SML peuvent s'expliquer grâce à deux facteurs. Tout d'abord sur une formation des données synthétiques comprenant 200 000 problèmes mathématiques, créées à l'aide de multi-agents (AutoGen). Ce nombre est inférieur à celui d'autres ensembles de données mathématiques, qui peuvent contenir des millions de problèmes, mais le modèle et l'ensemble de données étant plus petits, la formation est plus rapide et moins coûteuse. Et en plus de la mise au point supervisée traditionnelle, Orca-Math a été formé à l'aide d'un processus d'apprentissage itératif pour s'entraîner à résoudre des problèmes et continuer à s'améliorer en fonction des remarques des chercheurs.

Des petits modèles taillés pour des besoins verticaux

« Nos résultats montrent que les modèles plus petits sont utiles dans des contextes spécialisés, où ils peuvent égaler les performances de modèles beaucoup plus grands, tout en soulignant le potentiel de l'apprentissage continu et de l'utilisation du retour d'information pour améliorer les modèles de langage », font savoir les chercheurs. « Nous mettons l'ensemble de données à la disposition du public, ainsi qu'un rapport décrivant la procédure de formation, afin d'encourager la recherche sur l'amélioration et la spécialisation des petits modèles de langue ». Ces éléments sont respectivement accessibles ici et à cette autre adresse.

Commentaire