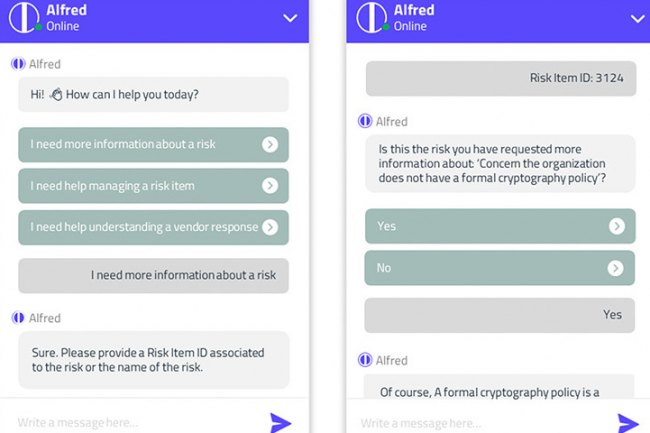

Poussé par le fournisseur de produits en gestion des risques liés aux tiers (Third Party Risk Management, TPRM) Prevalent, le chatbot Alfred alimenté par un grand modèle de langage (LLM) doit aider les utilisateurs à effectuer des tâches de gestion des risques liés aux tiers. Il répond à des questions courantes d'évaluation et de gestion des risques pour lesquelles les utilisateurs peuvent avoir une expertise humaine limitée en interne, et peut aussi réduire le temps de prise de décision, tout comme améliorer la précision des choix. En coulisses, l’outil est basé sur la technologie d'IA générative d'OpenAI, soutenue par Microsoft, qui utilise des données généralisées sur les événements et les observations en matière de risque pour générer des informations précises sur le profil de risque d'un client donné. Prevalent précise que toutes les données sont anonymisées et que les conseils fournis par Alfred s'appuient sur des normes industrielles telles que NIST, ISO et SOC2. « L'IA est intégrée de manière transparente à la solution TPRM existante », a aussi ajouté Prevalent.

Dans un communiqué, l’entreprise a déclaré que les résultats de l'IA sont continuellement vérifiés et examinés pour s'assurer de leur exactitude, et que les données utilisées pour l'entraîner ont été « validées par plus de 20 ans d'expérience dans l'industrie », sans préciser toutefois leur nature et leur volume. Brad Hibbert, directeur des opérations et responsable des recherches scientifiques de Prevalent, a déclaré que, en dépit d'une prudence naturelle, la clientèle de l'entreprise avait exprimé sa curiosité quant à l'utilisation de l'IA dans l'évaluation des risques. Prevalent a donc adopté ce que Brad Hibbert appelle une « approche axée sur les cas d’usage ». « Il est important de noter que, depuis un certain temps déjà, les capacités liées à l'IA font partie des fonctionnalités de la plateforme Prevalent, comme l'analyse ML et l'analyse de documents NLP, mais il s'agit de la première fonctionnalité d'IA conversationnelle/générative », a fait savoir Brad Hibbert.

L'examen amélioré des artefacts de sécurité pour bientôt

Même si la prise de décision d'Alfred ne dépend pas, pour l'instant, des informations fournies par le client, Brad Hibbert a précisé que l'interface utilisateur et le workload avaient été développés en tenant compte, en partie, des commentaires des utilisateurs. Il a également fait remarquer que l'entreprise prévoyait d’ajouter d’autres fonctionnalités d'IA générative à sa plateforme, y compris un examen amélioré des artefacts de sécurité et un ensemble d'évaluation automatisée (essentiellement en remplissant des formulaires de sécurité complexes), mais que celles-ci n'étaient pas encore disponibles. « Le développement reste focalisé sur la résolution des problèmes réels des clients », a déclaré Brad Hibbert. « Alfred résout le problème du manque de contexte ou de ressources qualifiées pour comprendre la signification d'un risque et ce qu'il faut faire à ce sujet ». Alfred est disponible dès à présent pour tous les clients de la plateforme Prevalent, sans frais supplémentaires.

Le logiciel vient s’ajouter à la série d'outils basés sur l'IA que l’on retrouve désormais dans les produits de sécurité d'un grand nombre de fournisseurs. Cette semaine, AuditBoard a ajouté des capacités d'IA et d'analyse de risque et de conformité, et la semaine dernière, Vanta a annoncé l’intégration d'IA générative dans son principal produit de sécurité et de conformité. Certains des plus grands fournisseurs de technologie intègrent également de l'IA générative dans leurs offres de sécurité. C’est le cas par exemple de Microsoft, qui a annoncé en mars Copilot Security, un assistant d’IA pour la cybersécurité basé sur GPT-4.

Commentaire