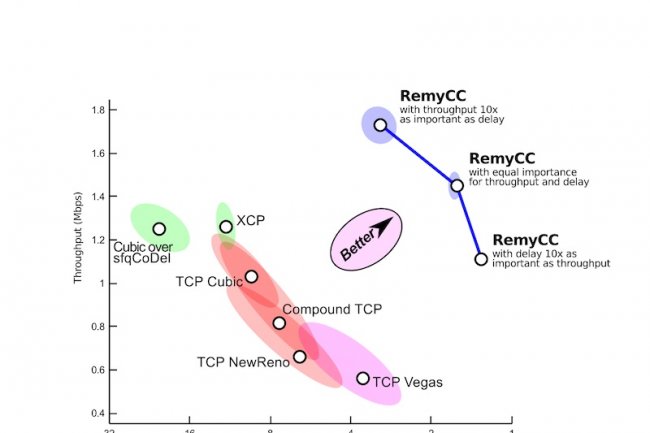

Sur un ordinateur intégrant 80 coeurs de processeurs, des ingénieurs du MIT (Massachusetts Institute of Technology) ont construit un outil qui pourrait rendre les réseaux beaucoup plus rapides, simplement grâce à de meilleurs algorithmes. Le système, appelé Remy, génère ses propres algorithmes pour traiter le framework TCP (Transmission Control Protocol), qui sert à éviter les embouteillages sur la plupart des réseaux. « Les algorithmes générés par Remy sont différents de tout ce que les développeurs « humains » ont pu écrire, et jusqu'ici, ils semblent fonctionner beaucoup mieux », selon les chercheurs, puisque, sur un réseau simulé, les dits algorithmes ont permis de doubler le débit.

« Remy n'est pas conçu pour tourner sur des ordinateurs individuels et des serveurs, mais un jour, il pourra être utilisé pour développer de meilleurs algorithmes qui fonctionneront sur ces systèmes », a déclaré Hari Balakrishnan, professeur en génie électrique et en science informatique au MIT. Pour l'instant, le système fabrique des millions d'algorithmes possibles et les testent sur des réseaux simulés pour identifier l'algorithme le plus adapté à un objectif donné. Les réseaux IP (Internet Protocol) n'obligent pas les ordinateurs reliés à Internet à envoyer leurs paquets de données à une vitesse imposée ou ne disent pas s'ils doivent continuer ou non leur transmission quand le réseau est surchargé. Actuellement, chaque système prend ses propres décisions en utilisant une implémentation du framework TCP. Chaque version de TCP utilise son propre algorithme pour déterminer la meilleure façon d'agir dans des conditions différentes.

Choisir la bonne version de TCP

Au cours des 30 dernières années, ces implémentations du TCP ont subi plusieurs améliorations et parfois certains réseaux et applications ont bénéficié de mises au point particulières. Par exemple, un navigateur web choisira, en priorité, de transmettre rapidement les bits sur le réseau, alors qu'une application VoIP cherchera plutôt à limiter les retards. « Aujourd'hui, sur les 30 à 50 versions de TCP possibles, seules 5 à 8 sont couramment utilisées », a déclaré Hari Balakrishnan. « Mais jusqu'à présent, ces algorithmes ont tous été développés par des ingénieurs humains », a-t-il ajouté. Remy pourrait changer la donne. « Le problème, au premier abord, est en fait terriblement difficile à résoudre pour les ordinateurs », a déclaré le professeur du MIT. « Parce qu'il y a tellement de variables et parce que les conditions du réseau changent constamment, pour obtenir que l'algorithme le plus efficace soit utilisé demande autre chose que de l'informatique « naïve » par force brute », a-t-il aussi expliqué.

« Le partage du réseau nécessite des choix stratégiques et pose des problèmes que l'on peut comparer à ceux des cyclistes dans une course de vélo. Par exemple décider si le coéquipier doit aller en tête et prendre les devants ou coopérer avec un autre coureur », a déclaré Keith Winstein, diplômant et collègue de Hari Balakrishnan. « Il y a un grand nombre d'ordinateurs différents, et tous veulent que leurs utilisateurs puissent naviguer sur le web, et pourtant ils doivent coopérer pour partager le réseau », a encore expliqué Keith Winstein. « Cependant, Remy pourrait bien faire quelque chose que les développeurs « humains » n'ont pas été en mesure de réaliser», a ajouté le professeur du MIT. Par exemple, les algorithmes TCP actuels imposent un petit nombre de règles aux ordinateurs en matière de performance du réseau. Ils pourraient notamment demander aux machines de ralentir la vitesse de transmission quand la perte de paquets passe en dessous d'un certain seuil. Selon les chercheurs, Remy pourrait créer des algorithmes contenant plus de 150 règles.

Remy, un système capable de créer des algorithmes IP plus performants

1

Réaction

Les chercheurs du MIT ont mis au point un système qui permet d'écrire de meilleurs algorithmes pour lutter contre la congestion du réseau.

Newsletter LMI

Recevez notre newsletter comme plus de 50000 abonnés

> Ils pourraient notamment demander aux machines de ralentir la vitesse de transmission quand la perte de paquets passe en dessous d'un certain seuil

Signaler un abusPlus vraisemblablement en dessUs