Un petit coup de fouet en début d’année pour les services d’OpenAI. En effet, la start-up a présenté plusieurs évolutions sur ses LLM phares : GPT 3.5 et GPT 4 Turbo. Pour ce dernier, la mise à jour est nommé gpt-4-0125-preview. Dans l’article de présentation, OpenAI explique que cette actualisation « accomplit des tâches de génération de code de manière plus approfondie que le modèle précédent et vise à réduire la « paresse » quand le modèle n'accomplit pas une tâche ». En effet, plusieurs utilisateurs ont remarqué que le LLM ne répondait plus à certaines requêtes et leur demandait de faire une tâche eux-mêmes. Sans donner d’explications, OpenAI semble avoir pris à bras le corps ce problème.

Parmi les autres changements, le modèle comprend n correctif pour un bogue affectant les générations UTF-8 non anglaises. L'entreprise a aussi introduit un nouveau modèle GPT-3.5 Turbo appelé gpt-3.5-turbo-0125 et revu à la baisse les prix d'utilisation de GPT-3.5 Turbo. La mise à jour améliore la précision des réponses du modèle dans les formats demandés et corrige un bogue qui provoquait un problème d'encodage de texte pour les appels de fonction dans une langue autre que l'anglais.

Des modèles d’embedding dévoilés et une gestion des clés d’API améliorée

En parallèle de l’actualisation, OpenAI a dévoilé deux modèles d’intégration sur le texte. , il s’agit d'un modèle text-embedding-3-small « plus petit et très efficace » et d'un modèle text-embedding-3-large « plus grand et plus puissant ». Selon OpenAI, le modèle text-embedding-3-large est son modèle le plus performant. « Un embedding est une séquence de nombres représentant des concepts au sein d'un contenu comme un code ou un langage naturel », a expliqué OpenAI. Les embeddings permettent aux modèles d'apprentissage machine et à d'autres algorithmes de comprendre la relation entre les contenus et d'effectuer des tâches de recherche ou de regroupement. Ils alimentent des applications de recherche de connaissances dans ChatGPT ou les Assistants API.

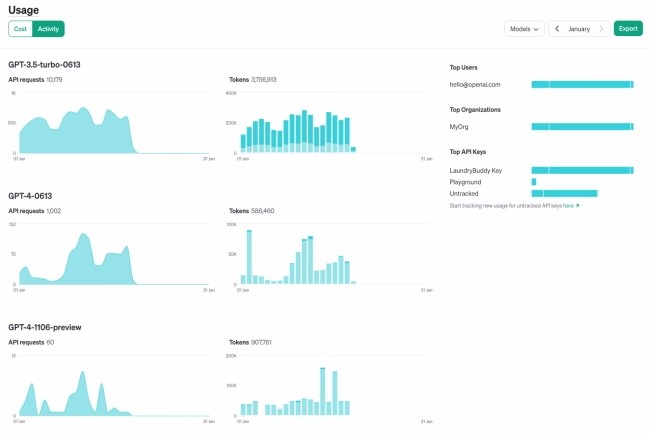

Enfin, la société a fait un focus sur les clés API. Deux améliorations apportées à la plateforme de gestion de celles-ci permettront aux développeurs d’avoir plus de visibilité sur l'utilisation et le contrôle des API. Tout d'abord, les développeurs peuvent désormais attribuer des permissions aux clés d'API à partir de la page dédiée. Par exemple, une clé peut se voir attribuer un accès en lecture seule pour alimenter un tableau de bord de suivi interne ou être restreinte à l'accès à certains points d'extrémité. Ensuite, le tableau de bord de l'utilisation de l'API et la fonction d'exportation exposent à présent les métriques d'une clé d'API après l'activation du suivi, ce qui facilite l’examen de l'utilisation par équipe, fonctionnalité, produit ou projet en ayant des clés d'API distinctes pour chacune d'entre elles. « D'autres évolutions sont prévues pour améliorer la capacité des développeurs à visualiser l'utilisation de l'API et à gérer les clés », souligne la société.

OpenAI annonce des évolutions majeures pour ses modèles de langage naturel vedettes, notamment GPT 3.5 et GPT 4 Turbo. Cette mise à jour vise à dynamiser le modèle GPT 4 Turbo pour résoudre un phénomène de « paresse » du modèle, où il ne répondait pas à certaines requêtes. En plus de cela, OpenAI a introduit des améliorations significatives dans la gestion des clés d'API, offrant aux développeurs une meilleure visibilité et un contrôle accru sur l'utilisation de ces clés.

Signaler un abusCette actualisation comprend également des correctifs pour des bogues affectant les générations UTF-8 non anglaises, ainsi qu'un nouveau modèle GPT-3.5 Turbo. OpenAI a également dévoilé deux nouveaux modèles d'intégration sur le texte, text-embedding-3-small et text-embedding-3-large, offrant une meilleure performance et une plus grande efficacité.