Il vous reste 94% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte? Connectez-vous

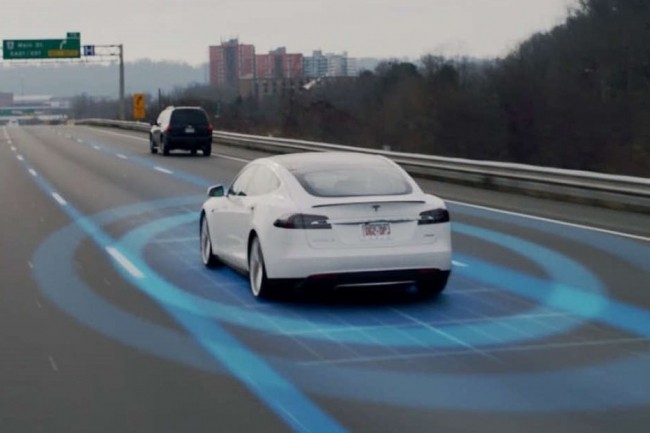

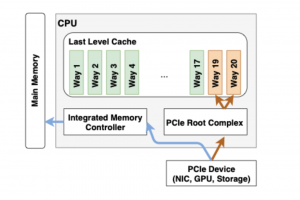

Malgré le battage médiatique, autour des véhicules autonomes notamment, l'IA écrit du code, conçoit le design des prochaines puces d'apprentissage machine de Google et nous dit même dans quelle mesure on peut lui faire confiance.

Il vous reste 94% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Commentaire