Flux RSS

Administration de systèmes

304 documents trouvés, affichage des résultats 61 à 70.

| < Les 10 documents précédents | Les 10 documents suivants > |

(29/10/2010 16:20:02)

CA renforce son portefeuille d'outils d'automatisation

Si quatre de ces outils sont des mises à jour des solutions Automation déclinées en Workload, Virtual, Server et Client de CA, deux autres - Process et Configuration Automation - sont nouveaux. Les produits sont accessibles séparément, de manière à laisser aux entreprises la possibilité de réaliser des déploiements à la carte et à leur rythme, quitte à ajouter d'autres fonctionnalités par la suite. CA propose aussi trois formules sous forme de kits d'outils préintégrés.

A mesure que les entreprises augmentent leurs déploiements en matière de virtualisation et ajoutent des solutions cloud à leurs configurations, les équipes de management doivent affronter de nouveaux défis et les équipes informatiques sont sous pression en vue de l'automatisation des processus. « Les activités traditionnelles comme l'allocation serveur, la gestion et le suivi des performances, deviennent plus complexes dans des environnements virtualisés et de cloud, » explique Mary Johnston Turner, directrice de recherche pour les logiciels de gestion système chez IDC. « Les solutions d'allocation automatisée sont nécessaires pour aider les équipes IT à relever ces enjeux,» souligne encore Mary Turner. « La suite CA Automation vise à répondre à plusieurs de ces exigences, tout en offrant aux clients des options pour une mise en oeuvre modulaire. »

Le service Process Automation permet de rationnaliser certains processus à travers des plates-formes, des applications et des groupes. Le logiciel comprend plus de 50 types de procédures prédéfinies, dont certaines développées par CA et d'autres par des vendeurs tiers comme IBM, BMC, Microsoft et VMware. Quant à Configuration Automation, qui effectue l'inventaire de l'environnement informatique, il comprend 1 000 modèles. « L'automatisation de la configuration des systèmes informatiques peut conduire à une plus grande standardisation des services, ce qui peut en retour aider les entreprises à réduire les temps d'interruption et à mieux respecter les politiques réglementaires et de sécurité, » explique CA.

A l'unité ou en package

Le module Workload, qui contrôle la répartition des charges de travail, peut être hébergé et géré à partir de plates-formes mainframe et distribuées. Elément nouveau, il permet désormais de planifier la charge de travail dans les clouds publics de type Amazon EC2, et de gérer les flux mixtes pour les ressources virtualisées. Sur le plan des infrastructures, Virtual Automation offre la capacité, grâce à un système intégré de réservation, « d'effectuer l'attribution de serveur virtuel en libre-service et de manière automatisé, » explique l'éditeur. Les fonctionnalités incluent le support de l'hyperviseur Hyper-V de Microsoft et de VPC d'Amazon. Server Automation gère le provisionnement, l'application de correctifs et le déploiement des applications et des services à travers les systèmes physiques et virtuels, en utilisant des modèles standards. Enfin, Client Automation (anciennement connu sous le nom de IT Client Manager) automatise les tâches de gestion client, notamment les hyperviseurs de type Bare Metal, la gestion des correctifs, les migrations de Windows 7. « Les nouvelles fonctionnalités incluent la gestion VMware VDI (Virtual Desktop Infrastructure) et des options de reporting avancées, » indique CA.

Pour les plus pressés, l'éditeur propose aussi des packages de services. Par exemple, Automation Suite for Hybrid Clouds comprend les outils à destination des environnements cloud privé et public. Il se compose de trois modules - Process, Server et Virtual Automation, ainsi que du logiciel Service Catalog.

Automation Suite for Data Centers, quant à lui, est destiné aux sociétés qui doivent gérer une infrastructure physique et virtuelle intégrée et démarrent dans le cloud computing. Le bundle, connu sous le nom de CA Spectrum Automation Manager, comprend pour sa part quatre modules: Configuration, Process, Server et Virtual Automation.

Le dernier bundle d'outils pré-intégrés, CA Automation Suite for Cisco UCS, offre les mêmes modules que ceux présents sont dans le pack Data Centers mais avec en plus des outils pour la fourniture et la migration des serveurs vers la plate-forme de l'équipementier américain.

Conférence LMI/CIO : Innovations et défis 2011 de la DSI

Des compagnies d'assurances mobilisent la géo-localisation et le dialogue de machine à machine (M2M) pour créer des formules inédites d'assurance automobile. Les distributeurs d'eau ou d'électricité s'appuient sur les smart grid et les compteurs intelligents afin d'instaurer des usages et des modèles de tarification qui rentabiliseront mieux leurs réseaux.

Pour se renouveler, l'entreprise doit non seulement identifier ces nouvelles approches, mais aussi améliorer sa capacité à les mettre en oeuvre rapidement et efficacement. En première ligne, la DSI constitue le levier d'action de la direction générale et des métiers. Pour assumer ses responsabilités, elle sera amenée à opter pour de nouveaux modes de fonctionnement et à repenser ses relations avec les métiers.

La DSI doit délivrer rapidement les ressources et les applicatifs demandés avec la qualité de service attendue. Elle peut s'appuyer sur des offres packagées récentes telles que le SaaS ou le cloud computing accompagnées de nouvelles approches comme les méthodes agiles ou l'optimisation par le Lean. Sans oublier de tirer le meilleur parti de la convergence entre les réseaux informatiques, le stockage et la téléphonie - fixe et mobile -, la vidéoconférence en mode téléprésence tout en s'arcboutant sur des serveurs surpuissants au nombre de coeurs démultiplié qui devront être exploités au mieux par les applications critiques.

Venez discuter avec vos pairs le 23 novembre prochain

Pour discuter de ces thèmes, nous vous invitons à une matinée sur l'innovation et les défis de la DSI le mardi 23 novembre au pavillon Dauphine à Paris dans le 16e arrondissement.

Vous pourrez ainsi réfléchir aux avantages de la « Blue Ocean Strategy », aux moyens de transformer l'innovation IT en atout concurrentiel et de cultivez l'innovation IT avec des experts comme Jean-François Caenen, directeur de l'innovation chez Capgemini, des témoignages de DSI et des tables rondes avec notamment : Christophe Bardet, directeur central marketing & développement de MMA, Patrick Hereng, DSI du groupe Total, Eric Legal, directeur d'Issy Media, Jean-Claude Saussaye, DSI de MMA, et Frédéric Tapissier, responsable études et développements à la direction des réseaux, de l'innovation et des nouvelles technologies de TF1.

Pour découvrir le programme détaillé et vous inscrire à cette conférence organisée par Le Monde Informatique et CIO cliquer sur ce lien.

(...)(28/10/2010 11:26:02)La migration vers Windows 7 gourmande en ressources, mais nécessaire

Quelques 1 360 responsables informatiques ont été interrogés pour une étude, commandée par la firme de sécurité Symantec. Le rapport publié par l'éditeur montre que près d'un quart des entreprises (23%) dans le monde sont passés à Windows 7 depuis Windows Vista, trois ans seulement après le lancement de ce dernier. Symantec a constaté que la planification et le processus de migration implique activement la moitié de tous le personnel. Dans une autre étude, le Gartner a constaté que les entreprises consacrent de 12 à 18 mois sur le seul processus de planification. L'enquête de Symantec a également montré que la migration a pris plus longtemps que prévu, en raison d'une incompatibilité de certaines applications (citée par 52 %).

La même étude constate que les responsables informatiques sont contents de l'ensemble des avantages tirés de cette évolution. Interrogés sur les facteurs qui avaient été " quelque peu ou beaucoup améliorés " depuis la migration, la performance arrive en tête à 79%, suivi d'une expérience utilisateur final et de la sécurité (76% pour chaque). Les autres facteurs positifs sont la fiabilité (74%), la facilité d'utilisation (69%) et de la gestion (66%).

D'autres conclusions du rapport de migration vers Windows 7:

- La préparation : les sondés ont expliqué que leurs équipes informatiques ont dépensé en moyenne dix heures pour préparer la mise à jour - y compris la planification, la formation et des pilotes.

- Le processus de migration : la durée moyenne du temps consacrée à la migration de chaque machine existante disposant d'un ancien OS est de 5 h, mais elle est réduite à 4 h dans le cadre du déploiement d'un nouveau PC.

- L'automatisation : des commentaires des répondants ont indiqué que si une organisation avait au moins dix ordinateurs, cela valait la peine d'automatiser le processus de migration.

- Rajeunir à l'ensemble du parc : de nombreuses sociétés ont déclaré avoir utilisé leur mise à niveau vers Windows 7 comme une occasion pour mettre en oeuvre certains standards. Déployer une interface de bureau virtuelle et des mesures de sécurité supplémentaires. Afin de gérer les applications qui incompatibles avec Seven, 71% des répondants les ont tout simplement remplacé.

- Résultat : dans l'ensemble, 78% des équipes informatiques ont déclaré que le processus de migration s'était passé «en douceur», et 63% qu'il était plus facile que leur dernière mise à jour d'OS. Sur les 62% des sociétés qui s'étaient fixés des objectifs de ROI (retour sur investissement), 90% les ont atteint.

" Pour de nombreux responsables IT, la migration vers Windows 7 est le projet le plus important de l'année 2010 ", a déclaré Christine Ewing, directrice marketing produit chez Symantec. " Notre enquête démontre que, tandis que si certaines sociétés ont pris du retard en raison d'incompatibilité applicative et/ou des contraintes budgétaires, la plupart des compagnies interrogées ont atteint leurs objectifs lors de cette transition, à savoir une plus grande fiabilité, des performances améliorées et une meilleure expérience pour l'utilisateur final" conclut la responsable. (...)

Mainframes : 57% des utilisateurs voient croître le nombre de Mips

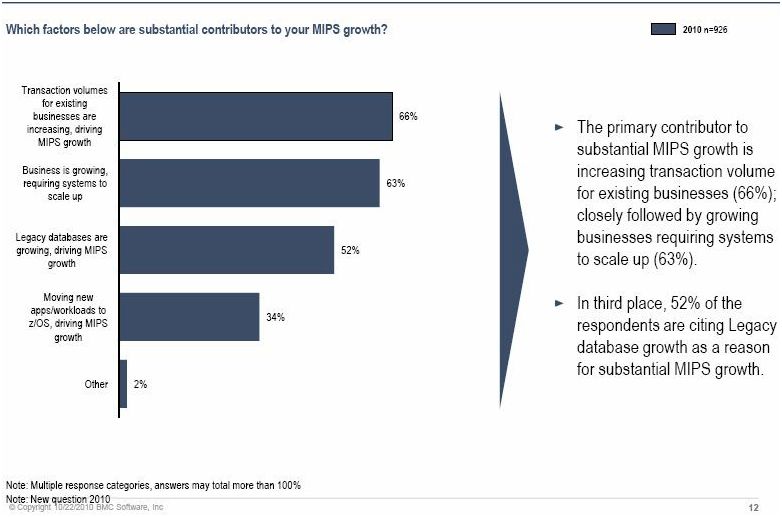

Conduite auprès de 1 700 utilisateurs de mainframes, la dernière enquête réalisée par BMC Software montre d'abord que 84% des personnes interrogées s'attendent à voir progresser ou se maintenir le nombre de Mips (million d'instructions par seconde) sur ces plateformes. Ensuite, 57% estiment que ces environnements vont continuer à attirer de nouvelles charges de travail contre 4% seulement jugeant qu'ils ne sont pas viables et que leurs utilisateurs devraient songer à changer de stratégie dans les cinq ans. Un peu plus du tiers restant de l'échantillon (37%) considère qu'il s'agit d'une plateforme viable à long terme mais qu'elle se limitera aux applications existantes et n'en attirera pas de nouvelles.

Cliquer ici pour agrandir l'image

Ceux qui augmentent leur consommation de Mips invoquent d'abord la disponibilité de la plateforme (74%) comme principale raison à cela, puis sa robustesse sur le plan de la sécurité (70%) et l'environnement centralisé qu'elle procure (68%). Ils jugent aussi qu'elle est mieux adaptée aux exigences des débits transactionnels (65%). Lorsqu'on leur demande quelles sont leurs priorités sur l'année qui vient, ils sont 65% à citer la réduction des coûts informatiques. Ils énumèrent ensuite la reprise après sinistre (34%), la modernisation des applications (30%) et l'alignement entre les activités métiers avec la IT (29%).

Des outils d'administration pour les plateformes mixtes

L'augmentation de la consommation de Mips est principalement causée par celles des volumes transactionnels sur les activités existantes (à 66%), par le développement de l'activité (63%) et, enfin, par l'augmentation des bases de données existantes (52%). Le transfert de nouveaux traitements vers les environnements zOS est également cité par 34% des personnes sondées.

Cliquer ici pour agrandir l'image

Prêchant pour sa paroisse, BMC Software fait également apparaître la demande des utilisateurs pour des outils d'administration capables de prendre en charge des environnements mixtes faisant tourner à la fois z/OS et z/Linux, et éventuellement d'autres OS à venir. A ce sujet, son enquête détaille le recours aux processeurs spécialisés : zIIP (System z Integrated Information Processor) originellement utilisé pour les tâches liés à DB2 et qui s'est depuis étendu à d'autres domaines, IFL (Integrated Facility for Linux) pour les traitements sous Linux, et zAAP (System z Application Assist Processor) pour les flux Java et XML. Les utilisateurs de mainframes interrogés sont 32% à utiliser un ou deux processeurs zIIP, 20% à recourir à un ou deux processeurs zAAP et 29%, un ou deux processeurs IFL. De 7 à 9% exploitent 3 à 4 de ces processeurs, 5% de 5 à 8, 3% de 9 à 16 et environ 3% plus de 17. Ces moteurs ne sont pas tellement utilisés pour les nouvelles applications, rappelle BMC.

70% des personnes interrogées dans le cadre de cette enquête appartiennent à des entreprises situées sur le continent américain, 21% sont installées sur la zone EMEA et 9 en Asie Pacifique. Un tiers ne sont pas des clients de BMC Software. (...)

Un PCA de longue haleine pour la Compagnie Nationale du Rhône

La première phase (février-avril 2007) est consacrée à la cartographie des processus et au bilan d'impact sur l'activité. D'avril 2007 à novembre 2007, ce sont les aspects formations et continuité métier qui sont abordés. Cela recouvre la gestion de crise, la continuité métier, la relocalisation et le maintien en conditions opérationnelles. De début 2008 à la mi 2009, le plan de continuité du système d'information est progressivement mis en oeuvre. Il est testé intégralement fin 2009.

Un incident grave simulé pour test

En Janvier 2010, la décision est prise de tester en situation réelle le Plan de Continuité d'Activité. Un incident grave est simulé avec l'arrêt des activités et une coupure d'alimentation électrique du siège social. Les équipes opérationnelles et techniques nécessaires au bon fonctionnement des activités stratégiques de la CNR (traders, back-office, middle-office, opérateurs de télé-conduite, système d'information) sont basculées sur un site de repli. Le test dure une journée complète sur le site de repli, puis au bout de 24h, le rapatriement sur le site d'origine s'est opéré sans incident.

Une telle mise en place permet à la CNR d'améliorer des éléments clés de la gouvernance de l'entreprise. La compagnie dispose d'un pilotage par le management des risques au niveau du comité de direction. L'outillage des processus de gestion des risques et de crise est effectivement en place et testé.

Un projet pilote pour GDF Suez

Au niveau organisationnel, des ajustements au sein de la structure ont été nécessaires. Il a fallu assurer la polyvalence des fonctions et former les couches d'encadrement à la gestion de crise. Les processus de l'entreprise ont été redéfinis dans l'objectif de s'adapter à un environnement hostile lors de confrontations à des sinistres majeurs. Le système d'information maintenant en place est tolérant aux pannes et fonctionne en haute disponibilité.

Ce projet fait de la Compagnie Nationale du Rhône un pilote au sein du groupe GDF Suez pour tout ce qui concerne la continuité d'activité. C'est le cabinet Lexsi qui a été retenu afin d'accompagner la CNR lors du développement et du déploiement de ce PCA.

Novell déverrouille l'accès aux hyperviseurs avec Cloud Manager

Les entreprises qui mettent en place des clouds privés doivent faire face à certains problèmes de verrouillage existant entre les offres de virtualisation des différents fournisseurs. Novell espère apporter une réponse concrète à cette situation avec son logiciel Cloud Manager. Ce dernier va permettre aux équipes informatiques de gérer à partir d'un seul outil des ressources virtualisées dans différents hyperviseurs, incluant ceux de VMware, de Microsoft et ceux basés sur Xen (de Citrix). Actuellement, lorsque des clouds privés exploitent des hyperviseurs distincts, il faut gérer chacun séparément, en utilisant les outils fournis par leurs éditeurs respectifs. Cela peut s'avérer compliqué.

Avec une console unique, les entreprises accepteront plus facilement de recourir à une combinaison d'hyperviseurs, choisis en fonction de leurs besoins, explique Ben Grubin, directeur du management du datacenter chez Novell. Selon lui, les choix d'infrastructure pourront ainsi se baser sur ce qu'il est nécessaire de mettre en place pour supporter l'activité, plutôt que de chercher à maintenir un seul environnement unifié.

Microsoft emprunte une direction similaire. Son logiciel Systems Center peut maintenant gérer VMware aussi bien que son offre maison Hyper-V, et la prochaine version du produit, prévue pour l'an prochain, prendra également en charge Citrix XenServer. VMware, en revanche, ne gère avec ses outils que ses propres environnements.

Permettre à l'utilisateur de réserver ses ressources

On peut vouloir utiliser des hyperviseurs différents suivant les applications que l'on exploite, pointe Ben Grubin. Certes, VMware domine le marché et c'est aussi lui qui offre le plus de fonctionnalités, mais c'est également le plus cher et certaines applications ne requièrent pas l'ensemble de ses capacités, souligne le directeur du management du datacenter chez Novell. Dans certains cas, pour limiter les coûts, le choix pourrait donc se porter sur des hyperviseurs plus légers et moins coûteux, estime-t-il.

La solution Cloud Manager de Novell inclut par ailleurs des outils permettant aux utilisateurs eux-mêmes de réserver leurs propres ressources de calcul. Y compris celles qui pourraient être hébergées au travers de plusieurs datacenters sur différents hyperviseurs. La console d'attribution des ressources peut afficher un catalogue de services, de même que les différents niveaux de services avec les prix correspondants, afin que l'utilisateur final puisse choisir.

Habituellement, lorsqu'un département ou bien des utilisateurs veulent accéder à de nouveaux services, ils doivent appeler les équipes informatiques et s'engager dans un processus de mise à disposition des ressources qui peut prendre plusieurs mois. Quelquefois, cela entraîne aussi des dépenses d'investissement pour de nouveaux matériels et logiciels. Autoriser ces utilisateurs à réserver eux-mêmes leurs ressources sur un cloud privé réduit sensiblement le temps de mise en place de nouveaux services. Cela permet en outre de ne payer que pour les ressources utilisées.

Gérer clouds publics et privés depuis la même console

Avec Cloud Manager, l'entreprise connecte le serveur d'application, qui gère le portail en self-service, aux serveurs d'orchestration des datacenters. Chaque serveur d'orchestration peut communiquer avec les infrastructures construites sur les différents hyperviseurs.

Novell a créé un adaptateur qui permettra aux utilisateurs d'insérer des services exploités sur le cloud EC2 d'Amazon, mais cette option technologique n'en est encore qu'au stade des tests, précise Ben Grubin. Il explique que les clients de Novell ont demandé à pouvoir combiner clouds publics et privés au sein d'un même outil de management. Le responsable prévoit qu'à terme le logiciel Cloud Manager supportera l'ensemble des services de cloud public que les clients souhaiteront exploiter.

Aucun prix n'est encore communiqué pour Cloud Manager. Novell va commercialiser une version qui pourra gérer jusqu'à 25 charges de travail (workloads) pour permettre à ses clients de le tester. Il sera ensuite possible d'ajouter des packages additionnels supportant jusqu'à 50 charges de travail.

En dehors de ses arguments portant sur les réductions de coût, Novell considère aussi que sa solution pourrait aider certaines entreprises à avancer dans leur politique de virtualisation. « Certaines ne dépassent pas un taux de 20 ou 30% de serveurs virtualisés parce que leurs différents départements répugnent à abandonner les garanties de visibilité, de sécurité ou de compatibilité qu'ils estiment posséder avec les serveurs physiques, explique Ben Grubin. Or l'une des choses que permet justement Cloud Manager, c'est de rendre les commandes au gestionnaire de l'application, au travers d'éléments tels que le portail en libre-service et la capacité à gérer ses propres charges de travail. Il conserve ainsi la visibilité et la responsabilité, en plus de la transparence des coûts. »

Dassault Aviation bascule sa production informatique dans l'infogérance

La production informatique de Dassault Aviation concerne 600 serveurs Unix, 17 partitions réparties sur deux mainframes, 1100 applications dont 300 en mainframe et 150 000 chaines de traitement. Pour engager cette production dans une démarche continue d'amélioration de qualité et accroître le niveau de service délivré, tout en permettant à la DSI de se concentrer sur les nouveaux projets, Dassault Aviation a décidé d'infogérer sa production informatique.

Prestataire habituel de l'entreprise depuis vingt ans, Sogeti France a remporté ce contrat d'une durée de trois ans. Son montant n'a pas été communiqué. L'infogérant va progressivement mettre en place un pilotage de la production sur un mode industriel, une démarche d'amélioration continue sur la base du référentiel ITIL, la mise en oeuvre de la continuité d'activité, la maintenance des infrastructures et la maîtrise d'oeuvre de ses évolutions.

Le groupe Dassault Aviation est présent dans 70 pays avec 12 000 collaborateurs et génère un chiffre d'affaires de 3,42 milliards d'euros.

Crédit Photo: Dassault Aviation, P.Boewen

(...)(26/08/2010 10:43:31)Thomas Bravo s'empare de LanDesk

Racheté pour la 4ème fois en huit ans, LanDesk, spécialiste des logiciels de gestion informatique est passé successivement entre les mains d'Intel, Avocent, Emerson. Désormais, il appartient à un fonds d'investissements : Thoma Bravo. « Le seul changement, c'est la continuité ! » nous explique Frédéric Pierresteguy, directeur France et Europe du sud, de Landesk. « Thoma Bravo correspond à ce que nous cherchions, on garde les équipes et les structures, notre plan de développement est maintenu et soutenu par un financement, et on redevient Landesk Software, c'est une bonne nouvelle pour nos clients comme pour nos partenaires ».

Landesk peut désormais réaliser son plan de développement et s'orienter vers le cloud et la mobilité. La société va également se porter davantage sur les grands comptes, elle était jusqu'alors vouée au mid market, des entreprises entre 500 et 1 000 postes. Au passage, Landesk confirme son orientation totalement en indirect. Elle va recruter 5 à 10 personnes pour étoffer ses équipes de support, de services et de ventes.

(...)| < Les 10 documents précédents | Les 10 documents suivants > |