Flux RSS

Business

9034 documents trouvés, affichage des résultats 3031 à 3040.

| < Les 10 documents précédents | Les 10 documents suivants > |

(28/05/2010 16:06:25)

Veeam voit dans l'administration la clé de la virtualisation et du cloud

Discret, Veeam est devenu en quelques années, un élément important pour l'environnement VMware. La société, fondée par Ratmir Timashev, affiche une croissance très forte du chiffre d'affaires+ 127% en 2009 et +123% attendue en 2010 pour atteindre près de 50 millions de dollars. « La virtualisation est une rupture technologique et nous avons travaillé pour accompagner les entreprises à cette évolution », souligne le dirigeant. Le point clé pour le fondateur réside dans l'administration de cette virtualisation pour laquelle l'éditeur propose Reporter 4.0, un logiciel de management dédié à Vsphere. Il propose différents rapports sur les performances, les indicateurs de traçabilité des différentes actions et la gestion des allocations de ressources.

Une innovation dans la sauvegarde

L'actualité de l'éditeur s'appelle SureBackup, une solution assurant la sauvegarde de machines virtuelles. Disponible l'été prochain, elle permet selon Ratmir Timashev « de tester la sauvegarde de chaque machine virtuelle en permanence et d'en vérifier la restauration ». Il constate que certaines entreprises ne disposent pas des ressources suffisantes pour réaliser ces tests et que ces derniers peuvent échouer en raison de fichiers corrompus, « notre solution apporte une réponse à leur problématique ». Pour ce faire, Veeam utilise la virtualisation pour créer une zone de test, baptisé Virtual Lab et utilise une technologie propre pour optimiser et automatiser ces tests.

[[page]]

Par ailleurs, SureBackup dispose de fonctionnalités complémentaires comme la restauration universelle au niveau élémentaire de l'application, et la réplication à la demande d'environnements de production pour test ou maintenance. Cette innovation sera intégrée dans la version 5.0 de Veeam Backup & Replication.

Etablir une passerelle avec Microsoft

Pour le futur de Veeam, Ratmir Timashev travaille de concert avec la firme de Redmond pour assurer le lien entre les machines virtuelles sous VMware et celles reposant sur la solution Hyper V. « Il existe plusieurs options pour réaliser une migration d'une machine virtuelle vers une autre, travailler directement sur l'hyperviseur ou alors la gérer depuis un outil d'administration comme System Center, via Operation Manager. Cette deuxième option permet d'englober l'ensemble du datacenter » souligne le fondateur de Veeam. Il travaille donc pour intégrer la solution Nworks (issue d'un rachat), facilitant le dialogue entre VMware et Hyper V. A noter, que ce service est aussi disponible pour Openview d'HP, un partenaire historique de Veeam. Par contre, le dirigeant écarte toute idée de travailler sur Xen.

Accompagner le développement du cloud

En tant que partenaire de VMware, Veeam participe au programme Service Provider (VSPP) du spécialiste de la virtualisation. Il s'agit d'un programme de licences spécifiques pour louer un certain volume de machines virtuelles au lieu de les acheter. Ce programme s'adapte chaque mois en fonction de la demande des prestataires.

« Si le management est la clé de la virtualisation, il le sera également dans le domaine du cloud et nous apportons dans ce programme notre expertise, sous forme de service premium, auprès des fournisseurs et des hébergeurs, en matière de reporting, de facturation, de supervision » affirme Ratmir Timashev. Ce dernier regarde avec intérêt le développement des offres clouds.

Il revendique par contre l'indépendance de sa société, lorsqu'on lui pose la question, d'un possible rachat. « Cela nous permet d'être plus rapide dans l'innovation » indique celui qui avait fondé en 1997, Aelita Software, spécialiste de l'administration de systèmes sous Windows Server et qui a été...racheté en 2004 par Quest Software. A suivre...

L'Arcep demande plus de transparence aux opérateurs mobiles

(Source EuroTMT) Un peu plus d'un mois après l'organisation de son séminaire consacré à la question de la neutralité des réseaux, l'Arcep (Autorité de Régulation des Communications et des Postes) a publié, jeudi 20 mai en fin de journée, ses « éléments de réflexion et premières orientations sur la neutralité de l'internet et des réseaux ». Ce document, soumis à la consultation publique jusqu'au 2 juillet, doit permettre à l'Arcep de préciser ce que veut dire concrètement le concept de « net neutralité ». Il s'agit aussi de savoir ce que l'autorité peut effectivement faire dans le cadre réglementaire actuel, en prenant en compte les évolutions prévues par le Paquet Télécom, et prévoir ou proposer des évolutions de la réglementation aux pouvoirs exécutif et législatif.

Ce projet a le mérite de proposer des définitions communes, permettant ainsi d'évacuer un certain nombre de faux problèmes. Il s'agit par exemple de la nécessaire gestion du trafic par les opérateurs, sans laquelle le réseau pourrait s'effondrer. Ceci dit, l'ensemble du document donne aussi l'impression que ce débat porte moins sur la garantie à offrir à l'Internaute pour lui permettre d'avoir accès aux contenus ou services qu'il souhaite consulter, mais plus sur le bras de fer financier que se livre un certain nombre d'entreprises. Démonstration en trois points.

Point 1 : un débat américain

Sans grande surprise, la notion de « net neutralité », dans son acceptation grand-public, est apparue au début de la décennie aux Etats-Unis. La cause est évidente. La « net neutralité » provient de l'échec de la réforme du cadre réglementaire des télécoms réalisée au milieu des années 90. Contrairement à l'objectif affiché qui était de favoriser la concurrence, le secteur des télécoms aux Etats-Unis a connu une vague de concentrations sans précédent, engagée avant l'explosion de la bulle boursière et conduisant à la création d'un duopole Verizon - AT&T. Comme le marché de la télévision par câble est aussi très concentré autour de trois acteurs principaux, Comcast, Time Warner Cable et Cablevision, l'abonné américain s'est retrouvé face à deux offres concurrentes pour l'accès au haut débit, celle de son opérateur télécom ou celle de son câblo-opérateur.

Crédits photo : D.R.

[[page]]

Une situation qui ne posait guère de problème tant que la vidéo ne constituait pas le moteur de la consommation des services et des contenus en ligne. Mais dès que le décollage de la vidéo en ligne a commencé, les géants de l'internet ont soulevé le problème de la « net neutralité », les câblo-opérateurs, qui contrôlent plus de la moitié du marché du haut débit aux Etats-Unis, pouvant devenir leurs principaux concurrents sur ce marché. Cette situation est très différente de celle de la majorité des pays européens où la concurrence entre FAI est la meilleure garantie contre toute dérive anticoncurrentielle.

Point 2 : un problème mobile

En fait, si la « net neutralité » pose, vis-à-vis du grand public, un problème en Europe et donc en France, c'est bien, comme l'indique l'Arcep, sur la transparence des offres. Sans jamais le dire ouvertement, l'autorité de régulation des télécoms s'attaque là aux discours publicitaires des opérateurs mobiles qui vendent de « l'internet illimité » qui n'est ni de l'internet, ni de l'illimité.

Les abonnés mobiles n'ont pas accès à l'intégralité des services et des contenus disponibles en ligne et la consommation est bridée. Une situation que reconnaissent, en privé, certains opérateurs qui rejettent la faute sur les acteurs de l'internet désireux de mette à disposition des abonnés mobiles les mêmes services que ceux disponibles sur PC avec une connexion fixe. Mais si dans le deuxième cas, les réseaux filaires, notamment d'accès, peuvent supporter la croissance de la consommation, les réseaux mobiles sont eux limités physiquement, obligeant les opérateurs à réinvestir lourdement pour éviter la congestion. Ce qui pose le problème du co-financement par les acteurs de l'internet des infrastructures.

[[page]]

Point 3 : le cofinancement des infrastructures

C'est le coeur du problème. Comme l'explique le document de l'Arcep, le trafic que s'échange les grands acteurs repose sur le principe du « peering », ne donnant lieu à aucune rétribution financière. Un point que remettent en cause aujourd'hui les opérateurs télécoms, notamment mobiles, qui doivent supporter de lourds investissements dans les réseaux d'accès pour supporter la croissance exponentielle du trafic, notamment vidéo.

Si l'Arcep ne juge pas nécessaire de faire évoluer, pour le moment, ce système, elle reconnaît que la demande des opérateurs de mettre en place une terminaison d'appel sur les données relève de son champ de compétences. Mais, cette évolution devrait alors être issue de travaux au niveau européen. Un sujet d'ailleurs qui figure parmi les axes de travail du BEREC (ORECE en français), l'organisme européen créé par le Paquet Télécom et qui a succédé au Groupe des Régulateurs Européens.

Le débat sur la « net neutralité » se pose donc dans des termes différents de part et d'autre de l'Atlantique. Mais des deux côtés, les acteurs s'opposent sur l'évolution du business model pour répartir le coût du financement des réseaux.

Cette question ne peut être réglée que dans un cadre international. Enfin, il reste un point non directement lié à la « net neutralité » : la déstabilisation des modèles économiques des créateurs de contenus par le poids croissant pris par les géants de l'Internet dans les revenus publicitaires. (...)

Imprimantes, le marché européen peine à redémarrer selon IDC

Au 1er trimestre 2010, le marché mondial des imprimantes affiche 9,1% de progression avec 28,7 millions d'unités vendues. En valeur, il est également en hausse, avec +7% et 13,8 milliards de dollars. C'est la première fois depuis 2008 que ce marché progresse en valeur. Selon Ruth Flynn, auteur de l'étude, « c'est très encourageant de voir progresser ce marché en même temps en volume et en valeur et ce, dans tous les segments, la tendance devrait se poursuivre en 2010».

Une fausse note dans cet exercice d'autosatisfaction, et pas des moindres, l'Europe est la seule région à aligner des chiffres négatifs. Que ce soit en volume ou en valeur, elle recule de 2% avec 6,4 millions d'unités vendues représentant 3,2 milliards de dollars. Les Etats-Unis progressent de 5,9% en volumes (6,4 millions d'unités vendues) et de 0,8% en valeur (3,9 milliards de dollars). L'Asie, hors Japon, progresse de 23% en volume et de 28% en valeur. Le Japon de 4% en volume et de 6% en valeur.

C'est une fois encore les MFP laser couleurs qui ont montré la plus forte croissance d'une année sur l'autre avec 25% de progression au 1er trimestre. Ensuite, on retrouve les MFP laser monochrome avec 18% de croissance. Toutefois, en volume, c'est toujours les MFP jet d'encre qui représentent la majeure partie du marché avec 51% des parts. Le marché du jet d'encre et plus spécifiquement du MFP jet d'encre couleur, est la technologie qui détient la majorité des parts dans ce marché des imprimantes avec plus de 19 millions d'unités dans le monde, dont 14,8 en MFP jet d'encre couleur. Le marché du jet d'encre continue d'être dominé par un petit groupe de prestataires, 3 d'entre eux détenant 85% de ce segment de marché.

Illustration : HP Color LaserJet, crédit D.R.

[[page]]

Au Q1, les laser monochrome continuent d 'occuper le second rang en volume avec 7 millions d'unités vendues, mais sont 1er en valeur avec 5,8 milliards de dollars. Ce segment représente 24% du marché en termes d'unités mais 42% en valeur. Les laser couleurs représentent 37% du marché en valeur, mais seulement 6% en volumes.

Par constructeur (et tous segments confondus), Samsung « chippe » la quatrième place à Brother , les trois premiers (HP, Canon, Epson) gardent toutefois leurs places respectives et maintiennent pratiquement les mêmes écarts. HP conserve largement sa première place avec 41,1% des parts et 10,5% de progression. Canon est toujours deuxième avec 16,7% des parts et 6,2% de progression, suivi d'Epson, 15,1% du marché et 10,8% de hausse. Samsung est donc quatrième avec 6,3% du marché mondial, 49,9% de progression, suivi de Brother, 5,9% de parts de marché et un recul de 7,1%.

A la bourse, Apple pèse plus lourd que Microsoft

Cette tendance aura mis 10 ans à se concrétiser, puisque dans le passé Microsoft avait mis au pot (150 millions de dollars en actions sans droit de vote) pour refinancer un Apple au bord du gouffre. En échange, la firme de Cupertino s'était engagé à soutenir le portage des outils de bureautique Office dans ses environnements Mac. On ne donnait alors pas cher de l'avenir d'Apple réduit à la portion congrue sur le marché des entreprises. Accessoirement cet arrangement avait permis à Microsoft de voir s'éloigner des sanctions de la justice américaine pour cause de situation monopolistique.

Mais depuis, le marché grand public des technologies de l'information a balayé en importance le marché des entreprises. Mieux, les technologies grand public sont plébiscitées par les entreprises à l'instar de l'iPhone qui envahit les poches des cadres dirigeants qui poussent leur direction informatique à intégrer ces nouveaux terminaux dans le système d'information. Un succès que n'aura jamais connu Microsoft avec ses smartphones sous Windows Mobile.

De plus, Apple a su créer un éco-système propriétaire très rentable autour de ses produits dans lequel il commercialise autant le matériel (iPhone, iPad, iPod) que les applications et les contenus associés (iTunes, ...) en prélevant sa dîme sur les développeurs et les éditeurs.

Illustration : Steve Jobs, CEO d'Apple, lors de la présentation d'iPhone OS 4.0, crédit IDG NS (...)

IBM prépare des offres analytiques basées sur Apache Hadoop

A l'instar de ses concurrents, IBM s'investit dans la mise au point de solutions capables d'analyser de très importants volumes de données. Séduit par les capacités apportées par le projet Apache Hadoop, consacré au traitement distribué intensif, il vient d'annoncer qu'il intégrait ce framework Open Source à son offre de services analytiques. Hadoop permet de répartir les traitements sur de multiples noeuds et d'en rassembler ensuite les résultats. Il combine plusieurs sous-projets : la base distribuée HBase supportant le stockage de données structurées sur un nombre élevé de tables, l'infrastructure de datawarehouse Hive, le framework MapReduce (mis au point par Google) pour le traitement distribué de grandes quantités de données sur des systèmes en clusters, ou encore Pig (langage de haut niveau pour les traitements parallèles), ZooKeeper (service de coordination d'applications distribuées), HDFS (système de fichiers distribué) et Chukwa (gestion de systèmes distribués de grande envergure).

Nom de code : BigInsights Core et BigSheets

Les offres élaborées par IBM autour d'Hadoop sont réunies sous l'appellation générique d'IBM InfoSphere BigInsights. Le suffixe Big fait ici référence à l'expression « Big data » qui caractérise ces volumes de données augmentant dans des proportions telles qu'ils exigent de nouveaux modes de récupération, de stockage, d'analyse et de visualisation pour parvenir à y repérer les informations importantes (dans les domaines de la finance, de la santé, de la lutte contre la criminalité, etc.). L'analyse et la gestion de l'information constituent pour IBM un secteur stratégique, le groupe prévoyant de générer 16 milliards de dollars d'ici 2015 sur ses activités « Business Analytics and Optimization », ainsi que l'a récemment indiqué le directeur financier Mark Loughridge.

InfoSphere BigInsights comprend d'abord un ensemble de logiciels et services d'Apache Hadoop qu'IBM désigne sous le nom de code BigInsights Core. Celui-ci permettra aux départements informatiques de construire et déployer des traitements analytiques sur mesure, à partir de volumes de données de l'ordre de ceux que peut générer Internet.

[[page]]

Par ailleurs, la technologie logicielle BigSheets est conçue pour extraire et découvrir des informations rapidement et de façon très visuelle, à partir d'une interface web. Il inclut une extension pour les moteurs d'analyse et les logiciels de visualisation tels que ManyEyes. Enfin, IBM prévoit des solutions d'analyse spécifiques pour permettre aux secteurs de la finance, de la gestion des risques, des médias et du loisir de mettre en place des application pour l'analyse d'énormes quantités de données.

[mise à jour : IBM n'a pas indiqué de date de sortie pour ces solutions en développement qu'il a dévoilées à l'occasion de sa conférence "Information On Demand EMEA 2010" qui s'est tenue à Rome, du 19 au 21 mai dernier).

Prédictif : Big Blue conjugue les logiciels d'Ilog et de SPSS

Par ailleurs, IBM développe ses offres conjuguées avec SPSS, le spécialiste du datamining racheté en juillet 2009. Dans ce domaine, il vient cette fois d'annoncer la disponibilité d'une solution qui tire également parti des technologies de l'éditeur français Ilog, acquis par Big Blue en juillet 2008 [ainsi que des logiciels de Cognos].

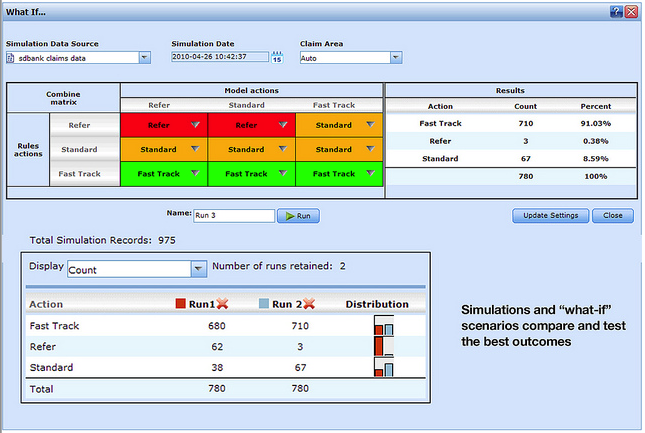

SPSS Decision Management associe ainsi des modèles prédictifs, des règles métiers et des fonctions d'optimisation. L'application aide l'entreprise à prendre des décisions en fonction des habitudes d'achat des consommateurs, et en prenant en compte les évolutions de sa stratégie et de la conjoncture économique. Deux offres verticales sont disponibles, respectivement destinée aux compagnies d'assurance (détection des demandes d'indemnisation frauduleuse) et aux sociétés de marketing (gestion multicanale des interactions entrantes avec les clients).

Capture d'écran de la solution IBM SPSS Data Management.

Cliquer ici pour agrandir l'image.

Yahoo veut stimuler la participation des internautes

Selon ComScore qui mesure la moyenne du temps passé par les visiteurs, a estimé que le nombre d'utilisateurs restant chez Yahoo a chuté de façon significative au cours des 16 derniers mois. En janvier 2009, les utilisateurs ont passé en moyenne 336,4 minutes sur les sites de Yahoo, mais ce nombre est tombé à 247,9 minutes en avril 2010. Une porte-parole de Yahoo n'a pas voulu répondre précisément à une question concernant la manière dont l'entreprise mesurait le taux de participation global des utilisateurs. Carol Bartz a indiqué pour sa part que les différents sites de médias de Yahoo tiennent leur propre comptabilité en termes de participation des utilisateurs, mais a reconnu que Yahoo Mail avait « marqué un peu le pas, entraînant une audience globale à la baisse, d'autant que la messagerie représente un indicateur majeur ». Elle a ajouté que « le mail est le grand prescripteur de participation »

C'est pourquoi Yahoo travaille dur pour apporter des améliorations à son service mail, et se dit confiant dans la hausse que cette réorganisation provoquera en termes d'utilisation. « Vous allez voir de nouvelles fonctionnalités servies par des interfaces très attractives, comme l'intégration de fonctions sociales à chaque session de messagerie, ses photos, ses clips vidéos, ses boîtes de réception intelligentes, » a t-elle dit. « Vous découvrirez des choses passionnantes dans nos produits mail et c'est très important pour la fidélisation ».

[[page]]

Yahoo fait face à la forte concurrence de Google et, plus récemment, de Facebook, dont la base utilisateurs a augmenté à pas de géant au cours des deux dernières années, mais Carol Bartz pense que les trois rivaux proposent des choses différentes aux utilisateurs. « Il y a une place pour chacun d'entre nous sur le Web » a t-elle estimé.

L'Internaute est une personne unique

En plus du lifting opéré sur Yahoo Mail, l'entreprise a engagé une stratégie de «personnalisation intensive » pour accroître la participation des utilisateurs, offrant aux visiteurs « son Web unique » afin de faire de leur visite sur les sites de Yahoo une expérience aussi pertinente que possible. La dirigeant souligne «si nous avons 600 millions d'utilisateurs à travers le monde, pourquoi ne pas avoir 600 millions de pages uniques pour chacun, si unique que chacun aura accès à un contenu différent, verra des publicités différentes, et une présentation personnalisée de toutes les informations ».

Le grand départ de cette stratégie sera donné par l'acquisition d'Associated Content qui publie des articles, des photos et d'autres contenus réalisés par un réseau de 380.000 collaborateurs pigistes, une transaction qui devrait être finalisée au troisième trimestre de cette année. « Yahoo compte sur les actualités locales et nationales, les vidéos et l'accès mobile pour stimuler la participation des utilisateurs » propose t'elle. L'éditeur s'attend aussi à un meilleur engagement des utilisateurs à mesure que son partenariat comme moteur de recherche associé à Microsoft prend forme et avance, l'intégration étant en cours avec une perspective d'achèvement global d'ici la mi-2012. « La modernisation, en cours, de la plateforme technologique permettra également à Yahoo d'innover plus et plus vite, de façon notamment à pouvoir réaliser en douceur des changements complexes sur ses sites Web et ses services lorsque c'est nécessaire » conclut-elle.

L'Europe hausse le ton sur la rétention des données personnelles

Les trois sociétés auraient fait de la rétention d'informations issues des moteurs de recherche sur une durée trop longue et en ne garantissant pas suffisamment l'anonymat, en violation des règles communautaires, explique le groupe de travail Article 29 (organe regroupant les autorités nationales pour coordonner la protection des données privées en Europe).

Depuis 2008, ce groupe demande aux moteurs de recherche de ne pas conserver les informations plus de 6 mois. Les trois acteurs visés ont tous acceptés de modifier leur délai de stockage qui pouvait atteindre 18 mois. Les données collectées par les moteurs de recherche peuvent comprendre plusieurs détails, les termes recherchés, la date et l'heure de la recherche, l'adresse IP et le type de navigateur, le système d'exploitation et la langue utilisée. Le problème de l'organe communautaire est que la directive européenne sur la protection des données ne donne pas une durée précise sur la conservation des données. Par contre, les autorités étatiques peuvent fixer et contraindre les acteurs à respecter un certain délai de rétention.

Ainsi, Google conserve les données complètes pendant neuf mois en effaçant la dernière partie de l'adresse IP. Le groupe de travail a écrit à l'éditeur pour souligner que cette politique n'empêche pas l'identification des personnes concernées. Car Google conserve les cookies - fichiers de données utilisés pour suivre le comportement de l'Internaute sur un site web - pendant 18 mois, ce qui permettrait une identification par corrélation des requêtes de recherche.

[[page]]

Le groupe Article 29 rappelle également qu'avec 95% de part de marché dans certains pays, Google avait une influence significative dans la vie quotidienne des gens. La firme de Mountain View a répondu « nous développons nos politiques fondées sur la meilleure expérience pour les utilisateurs à la fois en termes de respect de leur vie privée, de qualité et de sécurité de nos services ».

Des efforts à poursuivre

Prochainement, Yahoo prévoit un programme de « désidentification » des fichiers log des utilisateurs au bout de 3 mois. Certaines données « identifiables » étaient néanmoins conservées pendant 6 mois pour des raisons de détection de fraudes ou d'obligations légales. Cependant, Yahoo n'a pas fourni d'informations suffisamment claires sur l'identification des utilisateurs et sur les cookies, souligne le groupe de travail.

Fin 2008, Microsoft militait auprès de ses concurrents pour le délai de 6 mois. Aujourd'hui, il propose la suppression de l'adresse IP de l'ensemble des requêtes de recherche datant de 6 mois. Mais le groupe de travail a mis en faute la façon dont Microsoft gère les cookies pour les utilisateurs enregistrés et non enregistrés de son moteur de recherche.

Pour être complet, les trois sociétés ont été appelées à contrôler leurs actions sur la protection des données personnelles par des auditeurs externes. Enfin, le groupe issu de l'article 29, a envoyé un courrier à la Federal Trade Commission pour savoir si les pratiques des entreprises concernées n'étaient pas contraires au Federal Trade Commission Act.

L'investisseur Carl Icahn s'intéresse à Lawson Software

L'éditeur d'ERP Lawson Software constitue-t-il une cible potentielle pour un prochain rachat ? C'est la question que l'on peut se poser à la lecture d'un document récemment adressé par l'un des fonds d'investissement pilotés par l'Américain Carl Icahn (en photo). On y apprend que celui-ci aimerait s'entretenir avec les dirigeants de la société basée à Saint Paul (Minnesota) afin d'améliorer la valeur de l'action.

Engagé dans plusieurs fonds d'investissement, l'homme est connu pour donner de la voix et faire monter les enchères lors de négociations de rachat stratégiques. On se souvient de ses interventions au cours des discussions entre Yahoo et Microsoft, ou encore à la suite de l'offre faite par Oracle à BEA. Carl Icahn porte généralement un regard critique sur les décisions managériales des sociétés dans lesquelles il détient des intérêts. Or, il vient d'entrer au capital de Lawson Software, à hauteur de 8,5% (13,8 millions d'actions). Fin 2009, l'investisseur figurait au 22e rang des plus grosses fortunes aux Etats-Unis.

+28% sur les ventes de licences entre décembre et février

Sur son troisième trimestre fiscal, clos fin février 2010, l'éditeur d'ERP a enregistré une augmentation de 28% sur ses ventes de licences, à 31,87 M$ sur un chiffre d'affaires total de 186,2 M$, en hausse de 7%. Avec la maintenance, les revenus issus des logiciels se sont élevés à 121 M$ (+9%). En revanche, la marge opérationnelle du groupe ne dépasse pas 6,6% du chiffre d'affaires. Le bénéfice net se monte à 1,8 M$ sur le trimestre (+71%).

En janvier dernier, Lawson Software a acquis HealthVision Software, un acteur spécialisé dans les applications et services destinés au secteur hospitalier. L'intégration de la société s'est bien déroulée. Le groupe de Saint Paul a par ailleurs récemment annoncé une offre de déploiement de ses solutions de gestion dans le cloud EC2 d'Amazon.

Illustration : Carl Icahn (crédit photo : The Icahn Report) (...)

| < Les 10 documents précédents | Les 10 documents suivants > |