Flux RSS

Cloud computing

904 documents trouvés, affichage des résultats 341 à 350.

| < Les 10 documents précédents | Les 10 documents suivants > |

(26/04/2011 12:30:21)

Ubuntu Server 11.04 se pare de ses habits Cloud

Le projet Natty Nahrwal se transforme définitivement en Ubuntu 11.04 le 28 avril. A cette date-là, la version server sera aussi disponible. Les grandes nouveautés de cette édition est l'orientation importante autour du cloud computing, comme le confirme Nicolas Barcet, responsable de l'offre cloud chez Canonical « ce marché devient important pour les serveurs et reste ouvert à l'émergence de nouveaux acteurs. Les OS sont un élément essentiel au sein du datacenter et nous devons donc être présent ». Pour ce faire, l'éditeur s'est reposé sur certains savoir-faire « Ubuntu fonctionne sous Eucalyptus (dont nous fournissons une mise à jour) qui est très axé vers les clouds privés, mais aussi avec « Cactus » d'OpenStack qui s'adresse plus à la gestion des serveurs » indique le dirigeant. Vis-à-vis des clouds publics, Ubuntu Server 11.04 fonctionne dans le cloud d'Amazon EC2 où l'éditeur a depuis 1 an intégré un package baptisé cloudinit, qui gère l'initialisation de l'instance dans le cloud.

Sur l'aspect serveur, Nicolas Barcet insiste sur plusieurs améliorations comme « l'installation automatique du matériel physique, l'intégration d'une base de données nommée Cobbler, une solution « Power Map » pour gérer la problématique des économies d'énergie (capable de mettre en veille et de réveiller les serveurs) et l'administration système via MCollective». Le Kernell a été aussi revu avec un meilleur support des puces Intel, des fichiers XFS, etc. L'éditeur indique également avoir renforcé ses partenariats avec Jonas et Java, Nicolas Barcet précise d'ailleurs qu'« Ubuntu 11.04 server a été homologué JEE 1.5 ».

La version deskstop prête pour les tablettes

A côté de la version serveur. La principale évolution est la disponibilité du gnome Unity. Cette interface graphique est l'ancienne netbook édition capable de gérer la 3D avec les cartes graphiques qui supportent OpenGL. Pour les anciens circuits videos, l'éditeur propose une version plus ancienne de l'interface graphique. L'intégration du multitouch laisse penser que l'éditeur est prêt pour une utilisation au sein des tablettes numériques. Si on ajoute à cela Ubuntu One, outil de synchronisation et de sauvergarde du bureau dans le cloud, la distribution Linux entend bien devenir plus accessible.

En matière de déploiement, Canonical inaugure le test d'Ubuntu Server sur Amazon. Le futur utilisateur pourra exécuter sur une instance du cloud d'Amazon la distribution Linux pendant 1 h. Ce service de test sera disponible à partir du 3 mai prochain.

Google détruit ses vieux disques durs afin de prévenir la fuite de données

Google « suit avec rigueur la vie de chaque disque dur, sa localisation et son état, » et les détruit, si nécessaire, en suivant un processus qui s'achève par l'envoi des différents éléments dans des centres de recyclage. « L'appareil qui sert à détruire les vieux disques durs est un concasseur, » explique le narrateur dans une des vidéos de Google. « Un piston en acier traverse le centre du disque et déforme définitivement les plateaux, ce qui les rend illisibles. »

La vidéo montre ensuite un puissant broyeur recracher des morceaux de disques utilisés pour stocker les données. « Comme vous pouvez le constater, personne ne sera en mesure de récupérer les données de nos clients à partir de ces éléments, » affirme encore le narrateur. En sort une demi-douzaine de boîtes remplies de morceaux de l'ancien disque dur, prêtes à être expédiées vers des centres de recyclage.

30 datacenters aux Etats-Unis

Au moment où Google est épinglé pour avoir collecté et stocké des données privées, y compris des fichiers de recherche et des données de localisation sur des téléphones Android, sa vidéo vient montrer que l'entreprise de Mountain View a peu de chance de perdre les données qu'elle entend conserver. Selon un article paru dans Data Center Knowledge, depuis 2008, Google exploite plus de 30 centres de calcul aux États-Unis et à l'étranger. La nouvelle vidéo dans laquelle on peut voir comment se passent les opérations dans le datacenter d'Hamina, en Finlande, rend compte des méthodes pratiquées dans l'ensemble des centres de Google. Néanmoins, Google fait savoir qu'elle utilise « des méthodes de protection supplémentaires » qu'elle ne peut divulguer publiquement.

Chaque datacenter est composé « de milliers et de milliers de machines » qui permettent de délivrer les résultats des recherches, gère les transactions du commerce en ligne, ou les services proposés aux clients de Google Apps. Chaque serveur, monté sur mesure, intègre une version allégée de Linux avec les éléments système et le hardware requis pour exécuter une tâche spécifique, ce qui réduit aussi les risques de vulnérabilités. D'après les informations de Google, toutes ses données client sont « stockées dans des emplacements multiples pour assurer leur fiabilité...

[[page]]

Les fichiers dans lesquels sont conservées les données ont été affectés de noms aléatoires et ne sont pas stockés en clair, de sorte qu'ils ne sont pas lisibles tel quel. » Une fois les anciens lecteurs détruits, Google affirme qu'elle conserve des sauvegardes supplémentaires sur des lecteurs à bande, ce qui lui permet de disposer « d'un niveau supplémentaire de redondance pour protéger les données de ses clients. » Il y a quelques mois, après une panne de Gmail qui avait entraîné la perte des emails de milliers de comptes, le stockage sur bande s'était avéré en effet très utile.

Un pied de nez à Amazon

C'est le 13 avril, juste avant la panne de l'Elastic Compute Cloud d'Amazon intervenue la semaine dernière, que Google a téléchargé sa vidéo sur YouTube, puis l'a mise sur un blog le lendemain de la panne. Les datacenters de Google sont connectés à Internet via de multiples câbles à fibres optiques redondants à haute vitesse pour se protéger contre les pannes, et disposent de générateurs de secours en cas de coupure de courant. En cas d'incendie, il est prévu que l'accès aux données client bascule automatiquement d'un centre à un autre.

Le problème d'Amazon était différent : la panne de l'EC2 résultait de ce qu'Amazon a appelé un « événement réseau, » qui « a déclenché une grande quantité d'opérations de mirroring » sur les volumes de stockage. Il en est résulté une pénurie des capacités de stockage, et a entraîné la déconnexion des machines virtuelles. » La vidéo de Google insiste beaucoup sur la sécurité physique : l'accès aux sites est étroitement contrôlé, les visites guidées ou les visites sur place sont interdites ; les véhicules sont inspectés avant leur entrée dans l'enceinte du site ; les badges pour accéder à l'intérieur des bâtiments sont difficiles à falsifier ; dans certains centres, Google a mis en place des systèmes biométriques avec reconnaissance de l'iris pour vérifier l'identité des employés ; des systèmes de vidéosurveillance automatisés permettent de détecter toute anomalie et d'alerter le personnel de sécurité ; certains centres utilisent même « des caméras thermiques sophistiquées » pour repérer des intrus potentiels, enfin, le personnel de sécurité de Google est équipé de véhicules électriques, de jeeps et de scooters pour parer à toute éventualité et il est en contact permanent avec les autorités locales, au cas où l'intervention de la police serait nécessaire.

Crédit photos : Jon Brodkin, IDG

Les logiciels d'infrastructures et middleware en croissance en 2010 selon Gartner

Le marché de l'AIM affiche une belle progression, c'est un marché stratégique qui englobe 12 segments différents comme la SOA (architecture orientée services), ou le BPM (gestion des processus métier). Ce marché progresse, car : « les entreprises sont moins obnubilées par la maîtrise des coûts et s'ouvrent à la modernisation de l'infrastructure » note Fabrizio Biscotti, directeur de recherche chez Gartner.

Sur le plan technologique, les segments les plus dynamiques comprennent les technologies de gouvernance SOA, les serveurs d'applications, les produits et appareils portail. L'Open Source est également de plus en plus une partie intégrante des plans de déploiement AIM avec un accent mis sur les serveurs d'application Open Source, les bus de services d'entreprise et quelques autres fonctionnalités AIM.

IBM loin devant

Ce marché s'est concentré en 2010, par des acquisitions et par le poids des cinq principaux acteurs qui représentent 61% du marché mondial. IBM conserve largement sa 1ère place avec 32,6% de parts de marché et 14,4% de progression. Oracle (avec BEA) est loin derrière à 17%, en hausse de 12,5%. Troisième Microsoft, avec 5% des parts et 13,9% de hausse. Suit Software AG, quatrième, qui affiche 3,4% de parts de marché et 27,3% de progression. Tibco arrive cinquième, à 2,8% de parts de marché, en progrès de 20,1%.

« Nous continuons à observer un bouillonnement créatif où, d'une part, les grands fournisseurs continuent à être consolidés, et, d'autre part, plusieurs acteurs en place et à venir vont ouvrir de nouveaux marchés tels que la messagerie à faible latence (LLM), la gestion de transfert de fichiers ( MFT), et l'analyse des processus métier (BPA) », a déclaré M. Biscotti. « En outre, il existe une activité encore embryonnaire, mais dynamique, autour du cloud avec le PaaS. »

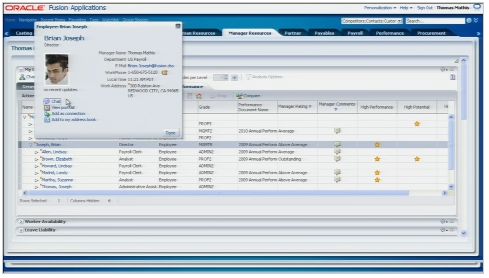

Fusion Applications : Oracle montre sa gestion des ressources humaines

Oracle vient de consacrer un webcast à sa solution Fusion HCM (human capital management) destinée à gérer les ressources humaines. C'est l'une des composantes de Fusion Applications, la suite de gestion intégrée que l'éditeur développe activement depuis plusieurs années et qu'il a dévoilée à l'occasion du dernier OpenWorld, en septembre 2010.

A terme, toutes les composantes de cette offre, proposant une large couverture fonctionnelle, pourront être au choix installées par l'entreprise de façon classique, c'est-à-dire sur des serveurs en interne, ou bien exploitées en ligne, dans le cloud. Il se trouve qu'Oracle a surtout insisté sur cette deuxième option durant son webcast sur Fusion HCM, présenté par Steve Miranda (en photo), vice-président senior, responsable du développement des applications Fusion. Cela n'a rien de surprenant. Tous les éditeurs ayant leur carte à jouer dans le cloud sont désormais en ordre de bataille et Oracle est récemment venu rappeler à Paris ses atouts dans ce domaine. Selon Steve Miranda, Oracle serait maintenant le deuxième fournisseur de solutions SaaS (software as as service), avec 5,5 millions d'utilisateurs « servis » par sa division Cloud Services. Cette dernière procède à de l'hébergement traditionnel d'applications, propose des services managés et des logiciels accessibles en mode SaaS, par abonnement.

Mise à jour semestrielle pour Fusion HCM en mode SaaS

Concernant la version en ligne de Fusion HCM, il sera possible d'exploiter l'offre sous une forme hébergée individualisée (de type FAI) ou dans une architecture partagée dite « multitenant ». La seconde proposition diffère de la première en cela qu'elle permet à plusieurs entreprises de partager la même instance d'une application, tandis que les données de chacune sont gérées séparément. Il n'est pas tellement courant que les fournisseurs de solutions SaaS donnent des détails sur l'architecture multitenant. Ils en exploitent pourtant les bénéfices parmi lesquels la capacité à procéder fréquemment à des mises à jour auxquelles les clients accèdent ainsi plus facilement. C'est cette architecture que défend tout particulièrement un chantre du SaaS tel que Salesforce.com. Et c'est cette capacité de mise à jour régulière que les supporters du multitenant mettent en avant pour inciter à choisir ce mode d'utilisation. Sur son site, Oracle annonce ainsi qu'il apportera tous les semestres des améliorations à la version SaaS de Fusion HCM.

Quoi qu'il en soit, Steve Miranda a affirmé que Fusion HCM et les autres composantes de Fusion Applications s'appuieraient sur le même code, quel que soit le modèle de déploiement choisi par les clients. Cela permettra justement à ces derniers de changer facilement de modèle s'ils le souhaitent. C'est exactement ce que propose Microsoft avec son offre de gestion de la relation client Dynamics CRM, celle-ci existant en mode SaaS, en version serveur traditionnelle ou, encore, hébergée par un partenaire intégrateur.

En cours de développement depuis cinq ans, Fusion Applications d'Oracle doit combiner les points forts des différents ERP rachetés par l'éditeur dans une suite de gestion intégrée de nouvelle génération. Telle est, depuis le début, l'ambition affichée par Oracle qui met tout particulièrement en avant l'interface utilisateur de l'offre et la présence de fonctions analytiques intégrées d'un bout à l'autre au sein des applications.

En concurrence avec Successfactors et Workday

L'offre Fusion HCM inclut, notamment, la gestion du personnel (salaires, avantages, indemnisations...), des objectifs des collaborateurs et des prévisions portant sur les besoins en ressources humaines. Sur le marché des solutions RH en mode SaaS, elle viendra concurrencer des offres d'éditeurs tels que Successfactors et Workday. Fusion HCM dispose de capacités d'intégration avec les trois ERP d'Oracle (PeopleSoft, JDE et la E-Business Suite). Cela apportera un certain confort aux clients de ces produits, mais cela souligne aussi le fait que la société de Larry Ellison évite formellement toute référence à une quelconque nécessité de migrer vers Fusion.

Fusion HCM (cliquer ici pour agrandir l'image)

Illustration : Steve Miranda, vice-président senior, responsable du développement des applications Fusion chez Oracle (crédit photo : Oracle)

[[page]]L'importance accordée à la version SaaS pourrait aussi aider l'éditeur à réaliser des ventes dans des entreprises où il est peu présent au niveau applicatif.

Plutôt qu'une migration, le fournisseur met plutôt en avant l'idée de « coexistence » entre Fusion et les applications actuellement exploitées par ses bases installées, avec une adoption qui se fera au rythme que les clients auront choisi. Cette stratégie présente peu d'inconvénients pour Oracle, puisqu'il continue à percevoir des revenus plutôt lucratifs sur la maintenance annuelle associée aux anciennes applications.

La date de sortie des Fusion Apps reste imprécise

Certains de ses clients sont néanmoins déjà passés à Fusion. Le webcast consacré aux composantes HCM donne par exemple la parole à Brian Ness, DSI au sein de l'établissement financier Principal Financial Group. La société a mis en production le module « Workforce Compensation » de Fusion HCM, dans le cadre d'un programme de mise en place pilote du produit. Même si chaque mise en route comporte ses difficultés, ce qui fut aussi le cas dans ce projet, la grande majorité des utilisateurs du groupe ont transmis des retours positifs sur le logiciel, a témoigné Brian Ness. Il est donc prévu de passer à d'autres modules de Fusion HCM cette année et l'an prochain.

Ce qui n'a pas été clairement indiqué dans le webcast, c'est la date de disponibilité de Fusion HCM et des autres composantes de Fusion Applications. On ne sait pas exactement quand les clients pourront en disposer, en dehors des entreprises participant au programme pilote.

Pendant la conférence OpenWorld de septembre 2010, le PDG Larry Ellison avait annoncé aux participants que la disponibilité générale de l'offre aurait lieu au premier trimestre 2011. Si l'on s'en tient à cette déclaration, Oracle est en retard. Mais Larry Ellison faisait peut-être référence au premier trimestre fiscal d'Oracle qui démarre en fait au mois de juin. Les responsables d'Oracle n'ont pris aucune question pendant le webcast et le groupe n'a répondu à aucune autre demande ce jour-là. (...)

Une défaillance du cloud d'Amazon plante plusieurs sites web

Amazon a commencé à signaler des problèmes sur son tableau de bord à 5 heures du matin (heure locale) hier. A 5h16, le site signalait des problèmes de connectivité affectant son service de bases de données relationnelles qui sert justement à gérer les bases de données relationnelles dans le Cloud pour plusieurs zones de l'Est des États-Unis. Amazon a également signalé des problèmes avec son service Elastic Compute Cloud (EC2) qui offre des capacités de calcul à la demande pay-as-you-go dans le nuage. La société a aussi signalé des problèmes avec l'Elastic Block Store (EBS), le système de stockage lié au service EC2. « Tôt ce matin, un événement sur le réseau a déclenché une mise en miroir d'une grande quantité de volumes EBS dans l'US-EST-1, » indiquait Amazon à 11h54 hier matin. « Ce mirroring a entraîné une pénurie des capacités dans la zone US-EST-1, empêchant la création de nouveaux volumes EBS et affectant nos disponibilités pour effectuer le re-mirroring nécessaire pour récupérer les volumes EBS touchés. »

Amazon a également déclaré qu'un de ses systèmes de contrôle en interne pour l'EBS a été surchargé et qu'il était devenu difficile de créer de nouveaux volumes et instances EBS en arrière-plan. « Nous travaillons aussi vite que possible pour accroître la capacité de la zone et accélérer l'opération de mirrorring, comme nous nous efforçons à rétablir le contrôle sur l'EBS », a ajouté l'entreprise. « Nous commençons à voir les premiers effets de ces efforts, mais l'affaire n'est pas encore réglée. Nous allons continuer à effectuer des mises à jour au fur et à mesure que nous progressons. »

Les critiques du cloud commencent

L'impact de la panne est assez étendu, surtout pour certains sites web 2.0 populaires. Sur le site de Quora, on pouvait lire : « Nous faisons actuellement face à une panne inattendue, et nous travaillons pour disposer d'un site de secours dès que possible. Merci pour votre patience. » Les sites HootSuite et Foursquare ont également été touchés, de même que Reddit, sur lequel les utilisateurs peuvent lire : « Amazon connaît actuellement une dégradation de ses services. Ils y travaillent. Nous comptons toujours sur eux pour restituer nos volumes. Nous sommes désolés. »

Certains utilisateurs ont fait part des désagréments causés par Amazon et son cloud sur Twitter. « Le cluster d'Amazon sur l'Est des États-Unis est toujours en rade, et certaines de nos données avec. Voilà pour la fiabilité des services cloud », a écrit tweeted @ Thierry_G. « Les instances et les volumes EBS d'Amazon sont encore en panne. Faut se préparer à mettre en route nos serveurs de sauvegarde GoGrid, » dit quant à lui @steve_dine.

Trimestriels EMC : Un peu plus près des nuages...

EMC a présenté les résultats du 1er trimestre 2011 et on peut constater que la stratégie du géant du stockage est la bonne. Le chiffre d'affaires progresse de 18% à 4,6 milliards de dollars et le bénéfice net croît encore plus rapidement (+28%) pour atteindre 477 millions de dollars, un free cash-flow pour ce trimestre de 1,1 milliard de dollars. Pour expliquer ces bons résultats, EMC insiste sur les bonnes performances de certaines régions comme l'Europe et la zone Asie. Son coeur de métier reste très solide, l'activité stockage a augmenté de 16% et son offre Symmetrix a progressé de 25%. Le constructeur indique aussi la bonne tenue de sa dernière acquisition dans le domaine du stockage Isilon. Le groupe confirme donc ses prévisions pour le prochain trimestre. Sur l'exercice 2011, EMC table sur un chiffre d'affaires de 20 milliards de dollars et un bénéfice net de 2,5 milliards de dollars. Joe Tucci, CEO d'EMC met l'accent sur deux axes stratégiques, le cloud computing et les big data.

VMware à la fête aussi

La filiale, spécialiste des solutions de virtualisation a annoncé un chiffre d'affaires en hausse de 33%, à 844 millions de dollars. Le bénéfice net pour ce premier trimestre atteint 126 millions de dollars contre 78 millions en 2010. Les revenus de l'éditeur sont portés par les ventes de licences qui ont progressé de 34% à 419 millions de dollars, ainsi que de l'activité support et maintenance à 364 millions de dollars en croissance de +36%. Les prévisions pour le deuxième trimestre sont donc au beau fixe, un CA compris entre 860 et 880 millions de dollars.

Illustration: Joe Tucci

Crédit Photo: EMC

(...)(21/04/2011 12:38:16)Google dévoile son service cloud Earth Builder

Google ouvre son infrastructure de cartes numériques aux entreprises qui pourront l'utiliser pour stocker leurs données géospatiales. Baptisé Google Earth Builder, ce service dans le cloud a été dévoilé hier, à l'occasion de la conférence Where 2.0 (19-21 avril, San Francisco). Il devrait être commercialisé au cours du troisième trimestre 2011. Google fournira ultérieurement des informations sur sa tarification.

Après avoir mis leurs données cartographiques dans le cloud de Google, les entreprises pourront les mettre à la disposition de leurs employés, partenaires ou clients grâce à des outils tels que le service en ligne Google Maps, des API ou encore l'application pour poste de travail Google Earth.

Traiter des masses de données ou juste quelques cartes

« Google Earth Builder est une plateforme de cartographie dans le cloud pour les entreprises et les administrations qui traitent des données géographiques, qu'il s'agisse de centaines de téraoctets ou de seulement quelques cartes de base », a indiqué Dylan Lorimer, chef de produit Earth et Maps pour l'entreprise. « Elles peuvent télécharger ce contenu dans le cloud, accéder à des fonctions pour traiter ces données, s'en servir pour construire des couches Maps et Earth, puis publier celles-ci en toute sécurité pour les mettre à disposition de leurs utilisateurs, a précisé le responsable produit. Ces derniers accèderont à ces couches à l'aide des outils qu'ils connaissent, comme Google Maps et Earth.

En s'appuyant sur Google Earth Builder, les clients économiseront à la fois sur le stockage, l'allocation des ressources serveur et sur la maintenance, qui peuvent prendre une importance considérable et s'avérer complexe lorsqu'il s'agit de gérer des données cartographiques. (...)

(...)

Trimestriels Intel 2011 : Portés par l'entreprise et la tête tournée vers les tablettes

Dans les résultats du 1er trimestre 2011 d'Intel, il y a d'abord les faits. Le chiffre d'affaires est de 12,8 milliards de dollars en hausse de 25% sur un an. Le bénéfice net grimpe de 29% pour atteindre 3,2 milliards de dollars. En regardant après dans le détail, on remarque que l'ensemble des activités se sont bien comportées. Pour Bernadette Andrietti, directrice des ventes EMEA d'Intel « cela est d'autant plus remarquable que ce trimestre est traditionnellement un peu en retrait ». Symbole de ce trimestre record, les résultats de l'activité PC sont en hausse de 17% alors que la plupart des analystes ont annoncé une baisse des ventes de PC probablement impactées par l'effet tablette. « Les analystes ont des visions un peu différentes par rapport à nos constatations sur le terrain, il est par exemple très difficile d'analyser le marché entreprise et notamment celui des TPE/PME. Enfin, il y a des éléments régionaux à prendre en compte, l'Allemagne, les pays de l'Est ou la Russie sont très dynamiques alors que l'Espagne et la Grande-Bretagne subissent un ralentissement » précise Bernadette Andrietti. Elle relativise aussi l'impact des tablettes « il y a effectivement des fortes demandes de la part de nos clients entreprises pour les tablettes, notamment pour équiper les commerciaux, mais ces produits viendront probablement en complément d'un équipement PC traditionnel ». C'est pour cela qu'Intel a fait plusieurs annonces sur les futures puces Oak Trail et son agenda en matière de puce pour tablette.

Les datacenters et les microserveurs

Si l'ensemble des activités a connu de bonnes performances, il faut souligner le secteur des datacenters qui confirme que « les entreprises ont mis la priorité sur le rafraîchissement des infrastructures plutôt que le renouvellement de leur parc d'ordinateurs qu'elles viennent d'amorcer » indique Bernadette Andrietti. L'activité Datacenter a cru de 32% au 1er trimestre 2011 à 2,4 milliards de dollars. Le lancement de la nouvelle gamme de processeur Xeon, intégrant l'architecture Sandy Bridge semble avoir séduit les entreprises. Les hébergeurs et les opérateurs sont très pro-actifs dans le domaine des achats de serveurs pour préparer les prochains services de cloud computing.

« Nous voyons par ailleurs une très forte demande de nos partenaires revendeurs pour les microserveurs » souligne la dirigeante des ventes EMEA. Les processeurs Atom spécialement dédiés pour ce type de serveurs devraient arriver d'ici 2012. Autre marché pour le processeur Atom qui est en pleine croissance, l'embarqué et particulièrement vers les Box des opérateurs. Le premier à bénéficier de cette puce est la Freebox Revolution, mais d'autres acteurs vont suivre comme Orange et Bouygues Telecom. Si on ajoute à cela les prochaines annonces concernant l'intégration des éléments de sécurité suite au rachat de McAfee, l'avenir d'Intel semble au beau fixe, les prévisions pour le deuxième trimestre affichent un chiffre d'affaires de 12,8 milliards de dollars. « Nous misons sur l'innovation » conclut Bernadette Andrietti. Une ambition confirmée par Paul Otellini, PDG d'Intel qui a relevé ses prévisions de dépenses d'investissement, notamment sur les technologies de gravure de puce les plus fines, à 14 et 22 nanomètres à destination des appareils mobiles.

Illustration: Bernadette Andrietti, Directrice des ventes EMEA Intel

Crédit Photo: Intel

(...)| < Les 10 documents précédents | Les 10 documents suivants > |