Flux RSS

Cloud computing

904 documents trouvés, affichage des résultats 771 à 780.

| < Les 10 documents précédents | Les 10 documents suivants > |

(12/04/2010 17:17:11)

Les tablettes, moteur de croissance du stockage dans le cloud

La flexibilité qu'apporte le stockage dans le cloud « n'est pas simplement une belle chose, mais répond à une nécessité quand vous travaillez avec des terminaux aux capacités limitées » explique Avi Greengart, analyste sur les produits grand public, chez Current Analysis et d'ajouter « si vous disposez que d'une mémoire flash, vous ne pourrez pas synchroniser grand-chose ». Or, de plus en plus de tablettes utilisent la mémoire flash de type NAND qui offre des capacités allant jusqu'à 64 Go.

Par exemple, l'iPad se décline en trois versions 16 Go, 32 Go et 64 Go. De son côté, HP a dévoilé un peu plus les caractéristiques de son produit, Slate, qui sera équipé d'une mémoire flash de 32 Go ou 64 Go. L'analyste estime peu probable que ces tablettes embarquent dans l'avenir autant de capacité que les notebooks ou les netbooks. Les utilisateurs de tablettes auront donc le choix de se tourner vers plusieurs fournisseurs, comme Box.net, Live Mesh, JungleDisk, Dropbox et SkyDrive. En complément des services de stockage en ligne, ces éditeurs proposent la synchronisation des dossiers et fichiers entre plusieurs terminaux (une tablette et un micro-ordinateur).

[[page]]

Une appétence et des offres

Adam Couture, analyste chez Gartner perçoit également une grande appétence pour les services de stockage en ligne avec l'intérêt des consommateurs pour les tablettes. « Ces services sont utilisées depuis longtemps par les possesseurs d'ordinateurs portables ou de bureau, intégrant un disque dur, les produits en mode cloud devrait devenir la première option de stockage ». Il complète son propos en indiquant « lorsque vous utilisez une application sur un Blackberry, vous achetez de la mémoire incrémentale. Ne serait-il pas mieux d'acquérir ce supplément dans un environnement cloud ? ». Les services de stockages en ligne « existent depuis longtemps, mais l'arrivée de l'iPad les a remis au goût du jour, avec des termes nouveaux » poursuit Adam Couture « cela signifie que vous n'allez plus synchroniser vos données en un point particulier, maintenant que vous pouvez y accéder à travers le cloud sans se préoccuper du type de terminal, ni de trouver le bon fichier » conclut l'analyste.

Preuve de cette émulation dans ce domaine, l'arrivée de la tablette d'Apple a vu fleurir des solutions de stockage et de synchronisation des données. Ainsi, SugarSync propose un service permettant aux utilisateurs d'iPad de synchroniser et de partager des fichiers, photos, musiques et vidéo stockés dans le cloud. Pour la fondatrice de la société, Laura Yecies, les utilisateurs ont le choix de télécharger un seul fichier plutôt qu'un dossier entier à partir d'un Macintosh, d'un PC sous Windows ou un smartphone. On peut accéder au contenu à distance sans utiliser la mémoire interne du terminal. Sur le plan tarifaire, SugarSync propose 2 Go gratuitement, une évolution vers 30 Go coûtera 50 dollars par an et la capacité peut atteindre 500 Go pour les plus gourmands. Ce service peut être utilisé en complément de la solution d'Apple pour le cloud « iWork document creation et editing tool », une partie du service de stockage en ligne MobileMe. Les outils Apple créent le contenu téléchargeable par SugarSync sur plusieurs plateformes.

Les professionnels s'intéressent également à ces services. Ainsi, Rackspaces Cloud a lancé récemment une application gratuite pour l'iPad, CloudPro, donnant aux utilisateur la possibilité de surveiller depuis sa tablette des serveurs Rackspace, d'appliquer des backup, de créer des VM, de les rallumer ou de les effacer à distance.

(...)(09/04/2010 12:17:30)Nehalem-EX et vSphere 4 avec les serveurs novascale bullion de Bull

« Avec notre offre bullx Série B en lame et Série R en rack (sur base Intel Xeon Westmere), nous couvrons une grande part des besoins en extreme computing, dans la banque, l'industrie et la recherche scientifique », assure Bruno Pinna, directeur marketing de Bull, « mais avec le lancement de la Série S (sur base Nehalem-EX/ https://www.lemondeinformatique.fr/actualites/lire-intel-nehalem-ex-cap-sur-la-performance-et-la-haute-disponibilite-30323.html), nous proposons des serveurs quadri sockets capables de monter en puissance grâce un lien d'interconnexion maison, le BCS (Bull Coherent Switch). Avec cette technologie, nous proposons des noeuds de 8, 12 ou 16 processeurs Xeon 7500 avec un maximum de 2 To de mémoire. » Depuis l'annonce Intel, on voit beaucoup de serveurs haut de gamme Nehalem-EX 4 ou 8 sockets reposant sur des composants standards ou spéciaux. Bull, comme SGI, s'est spécialisé dans le développement de solutions originales.

[[page]]

Même approche pour la gamme novascale bullion, Bull a en effet décidé de livrer nativement ses serveurs sur base Intel Xeon Nehalem-EX avec vSphere 4, la suite de virtualisation de VMware. « Nos serveurs novascale bullion partagent leurs caractéristiques techniques avec les bullx Série S mais, sur les premiers, nous avons décidé de mettre l'accent sur la fiabilité avec le support des fonctions Race et le partenariat avec VMware. Le marché évolue et nous pensons que la conjonction entre une machine « scalable » et l'outil vSphere 4 permet d'offrir à nos clients une plate-forme technologique stable et évolutive, et ce, dans un environnement critique virtualisé. » Sur la question de savoir pourquoi le partenariat a été fait avec VMware plutôt qu'avec Microsoft, Bruno Pinna assure trouver chez le premier une compréhension globale du marché, « on sent bien toute une stratégie cloud interne et une évolution vers le software mainframe. Nous avons également des projets en cours avec Microsoft qui reste un partenaire privilégié, mais les novascale bullion seront exclusivement livrés avec vSphere 4 et l'hyperviseur ESX 4. »

Pour l'instant, Bull ne propose pas de serveurs sur base AMD Opteron mais rien n'est définitivement exclu précise Bruno Pinna. « Nous avons effectivement une collaboration étroite avec Intel, nous finalisons par exemple avec ce dernier le Tera 100, un super calculateur pour le CEA capable d'atteindre le PetaFlop, une première en Europe. Nous nous focalisons dans nos choix et nous sommes très satisfaits de nos partenariats.»

Pour les prix, la gamme bullx démarre à 20K€. Pour les novascale bullion, Bull annonce 200K€ pour le serveur (avec WMware vSphere 4), 200K€ pour la solution de stockage et 100K€ pour les services associés.

Le cloud privé : priorité des DSI selon une étude PAC

Avec le concours d'EMC, d'Intel et de VMware, le cabinet d'études PAC a demandé à un panel de 200 décideurs informatiques français, répartis dans les principaux secteurs d'activités, leur vision du cloud computing. Étonnamment, le principal avantage mis en avant par ces responsables IT n'est pas la réduction des coûts de production ou les gains attendus pour la mise en service de nouveaux projets, mais la disponibilité des ressources (42% des réponses) et la flexibilité de la plate-forme (34%). Encore plus surprenant, l'optimisation de l'infrastructure et le paiement à l'usage ne rassemblent que 19 et 21% des « suffrages ». Christian Hilaire, PDG d'EMC France, analyse ces résultats en expliquant que « les entreprises démarrent aujourd'hui dans leur réflexion sur un cloud privé. Nos principaux clients réfléchissent à la question, c'est l'étape suivante après la virtualisation. Le cloud est bien la quatrième vague informatique après le mainframe, le PC client et le web. » Les responsables IT ont bien compris que le cloud allait leur permettre de masquer la complexité du système d'informations pour fournir des services à la carte. Et à la différence des projets informatiques traditionnels qui demandent de trois mois pour allouer des ressources à une application, la gratification est immédiate et de type self-service.

Parmi les inconvénients du cloud computing, nos responsables informatiques pointent à 50% la sécurité et à 35% la dépendance au réseau. Des freins liés à l'infrastructure et aux problèmes récurrents de sécurité. La dernière conférence RSA à San Francisco mettait également l'accent sur les défis sécuritaires qui attendaient le cloud (https://www.lemondeinformatique.fr/actualites/lire-les-defis-securitaires-du-cloud-30182.html). Pourtant, les principaux projets concernent aujourd'hui des clouds privés hébergés dans l'entreprise ou chez un tiers de confiance (opérateur ou intégrateur). Des solutions en théorie moins vulnérables que les clouds publics proposés par les éditeurs ayant flairés la bonne affaire. « Les opérateurs vont contribuer à structurer le marché en Europe, car ils possèdent les infrastructures indispensables pour faire transiter les processeurs les plus critiques à travers le cloud» précise Mathieu Poujol, directeur technologies chez PAC. « Ensuite tous les services de l'entreprise ne sont pas nécessairement hébergés dans un cloud. Il est possible de procéder par étapes » souligne Jean-Pierre Brulard, vice-président Europe chez VMware. Trois types de plates-formes services sont aujourd'hui définis pour le cloud : IaaS (le réseau, le stockage, les serveurs et les outils de virtualisation), PaaS (avec en plus les logiciels serveur, les bases de données, l'intégration SOA et les runtimes) et le SaaS (toutes ces briques avec les applications).

En illustration, Mathieu Poujol de PAC, responsable de l'étude sur le cloud computing en France

[[page]]

Autre réponse stupéfiante à la question sur les acteurs du cloud computing : Microsoft arrive en tête avec 50%, VMware suit avec 43% et Amazon ne pointe qu'à la huitième place avec 7%. Difficile à comprendre quand on sait qu'Amazon a lancé sa plate-forme EC2 en 2006 ! Un cloud arrivé à maturité avec une tarification très claire alors que Microsoft sort à peine de sa phase de tests et tente de commercialiser ses services depuis février dernier. Sur ce point précis, Mathieu Poujol précise que l'étude a été mené lors du lancement d'Azure début 2010 et que ces responsables IT ont dû être particulièrement sensibilisés au programme de Microsoft. Ce sont donc principalement les éditeurs qui sont spontanément associés au cloud et non pas les opérateurs ou les fournisseurs de services managés comme IBM ou HP.

Sur l'initiative des projets cloud, la DSI est aux commandes dans 67% des cas même les métiers et la direction générale pèsent un poids très lourd (26%). Les responsables IT semblent bien décidés à rester suffisamment réactif pour ne pas perdre la main face aux demandes des métiers. Point particulièrement intéressant dans le cadre des projets, quels sont les type d'application ou d'infrastructure concernés ? La messagerie reste toujours sur le podium avec 54% des réponses mais les ressources administratives (finance et compatibilité) arrivent sur la deuxième marche (26%) suivi de près par la CRM (24%). Les activités critiques de l'entreprise ne semblent donc pas mises à l'écart des projets cloud. Jean-Pierre Brulard précise que les différents modèles d'adoption applicatifs se résument à trois étapes, « la production informatique concerne tout d'abord les applications non critiques comme la messagerie » même si cette dernière reste particulièrement visible en cas de panne à la différence d'un ERP qui peut tomber 2/3 heures sans déclencher de plan Orsec. « Les entreprises passent ensuite aux applications métiers standards ou customisés ». On assiste là à un vrai basculement dans le monde cloud, principalement quand la virtualisation passe de 20 à 60%. « Dernière étape, l'extension au business continuity pour la gestion des risques. Mais aujourd'hui, chez les clients la vraie barrière reste le passage de l'étape 1 à la l'étape 2. »

[[page]]

A la question sur le type d'infrastructure, les décideurs plébiscitent à 71% le cloud privé quitte à développer plusieurs petits clouds à l'intérieur de l'entreprise pour répondre aux différents besoins. Mathieu Poujol estime toutefois que les clouds hybrides vont se développer naturellement avec la maitrise des clouds privés. Les clouds publics (7% des réponses) seraient réservés à une application bien précise comme la solution de SaleForce.com. Des clouds communautaires regroupant plusieurs services publics ne sont pas exclues avec des Conseils régionaux ou des ensembles de communes. « La ville de Barcelone, par exemple, a ouvert son cloud public aux hôpitaux et à sa pépinière d'entreprises » précise Mathieu Poujol.

La conclusion de cette étude que le cloud est devenu une réalité en France et que les infrastructures privées sont clairement la priorité. « Sans s'en rendre compte, en systématisant les VM, les entreprises arrivent naturellement au cloud interne » conclue Jean-Pierre Brulard. « Avec un taux de virtualisation 30% des portefeuilles applicatifs, la France est au niveau des États-Unis et du reste de l'Europe. À 30% de virtualisation, le coût au giga est de 18 cents. Avec une montée en charge pour arriver à 60%, le cout au giga passe 9/10 cents au giga pour les entreprises ». Mais aujourd'hui pour accompagner le développement du cloud et simplifier le transfert d'une VM, il est nécessaire de créer un marché Unique du cloud en Europe pour offrir un marché global aux acteurs européens.

(...)(06/04/2010 10:01:12)

Le cloud computing, avenir des opérateurs télécoms

Le monde des télécoms, côté opérateurs, n'est pas loin de faire sa révolution en passant de mesures d'économie drastiques, c'était en 2009, à un redéploiement qui aboutira en 2011. Tous les opérateurs français ont baissé leurs investissements logiciels et services en 2009, sélectionné leurs fournisseurs, réduisant leur nombre, en déréférençant une partie. Bouygues Télécom est allé le plus loin en ré-internalisant une partie de ses projets IT.

Dans cette spirale, seuls la TMA (Tierce Maintenance Applicative) et maintenant l'outsourcing ont sorti la tête de l'eau en 2009. « Le recours à la TMA était déjà en place, l'offshore est plus inhabituel dans les télécoms », note Daniel Esteves, consultant chez PAC. Mais cette croissance est en trompe l'oeil. Ces deux secteurs ont progressé en volume, mais fortement baissé en prix, comme tous les investissements des opérateurs de télécoms. Les prestataires des opérateurs ont accusé le coup, laminés par les restrictions budgétaire et les baisses de prix. En 2010 toutefois, l'investissement en logiciels et services des opérateurs de télécoms devrait commencer à reprendre. En moyenne de 3% estime PAC. « C'est très lié aux métiers des opérateurs » relève Daniel Esteves. « Ils tentent de sortir de la voix et des réseaux pour générer de nouveaux revenus ».

Les opérateurs font du cloud en interne et vont le vendre comme prestataire

Le cloud est un axe de développement très fort des opérateurs. A la fois comme clients et comme prestataires. Souvent, ils déploient en interne des solutions de cloud, les valident et les revendent ensuite. C'est la démarche d'Orange. Elle pourra englober d'autres prestataires dans un éco-systèmes cloud, dirigé par l'opérateur. Tous les aspects liés à la mobilité et aux smartphones sont également privilégiés au travers de nouvelles plate-formes de services. Certains projets restent plus complexes, comme le paiement par mobiles qui nécessite de faire travailler ensemble plusieurs partenaires. Mais la demande en services mobiles est telle, dans les entreprises, mais surtout chez les particuliers, qu'elle assurera les investissements logiciels et services des opérateurs télécoms dans les années à venir.

Free Cloud Alliance : union pour un cloud libre

Sur un marché promis à une forte croissance, les différents acteurs s'associent pour développer en commun leur technologie et leur savoir-faire. IELO, Mandriva, Nexedi et TioLive, éditeurs de logiciels libres viennent de créer la Free Cloud Alliance, initiative qui propose une offre globale réunissant Iaas, Paas et Saas.

Ces offres reposent sur différentes briques technologiques, NiftyName Virtual Datacenter de IELO qui est une solution Iaas conçue pour les hautes performances et la haute disponibilité. XS2 de Mandriva permet d'effectuer un stockage réparti des fichiers sur différents serveurs distants. NS2 (Neo Storage Server) de Nexidi apporte la possibilité de stocker des fichiers en mode objet, méthode particulièrement adaptée à l'archivage de grandes bases de données type gouvernementales ou pour l'enregistrement des transactions bancaires. Du même éditeur, Slap Cloud coordonne les ressources sur le cloud en détectant par exemple les machines inactives et fournir plus de puissances à celles qui en ont besoin. Enfin, pour chapeauter tous ces éléments, la plate-forme TioLive optimise les différentes briques pour composer une solution Paas Open Source.

Au-delà l'aspect marketing et de communication de l'annonce de l'initiative, elle a le mérite de remettre la problématique Open Source dans les débats des standards sur le cloud, qu'il soit public ou privé. La réunion des éditeurs démontrent aussi qu'une solution Open Source de bout en bout pour les clouds privés existe et qu'elle répond parfaitement à la volonté de toutes les entreprises, la réduction des coûts.

(...)(01/04/2010 12:31:18)Un datacenter mobile dans les nuages [1er avril ;-)]

La start-up californienne Datacloud vient de lancer son premier centre de calcul mobile destiné à couvrir des besoins ponctuels et localisés en puissance informatique. Le premier exemplaire a été lancé et présenté à la presse à San Francisco, au dessus de la célèbre baie, ce matin. En effet, Datacloud a placé son centre de calcul dans un dirigeable capable de se placer au dessus d'un salon, d'un événement ou de n'importe quelle installation temporaire requérant une forte puissance de calcul. Les équipes au sol sont reliées au centre de calcul par une liaison Wi-Fi classique cryptée, la distance à couvrir étant de fait très faible, permettant ainsi un réel très haut débit.

La conception de datacenters en conteneurs n'est pas neuve et l'offre de Datacloud n'est pas très innovante de ce point de vue. Deux difficultés restaient en fait à gérer : l'alimentation électrique et le refroidissement. L'intelligence de l'offre réside dans la manière de contourner ces difficultés. Le refroidissement repose sur le free-cooling : la température chute en effet considérablement au fur et à mesure de l'élévation en altitude. Si le datacenter chauffe, il suffit donc au dirigeable de monter de quelques centaines de mètres pour bénéficier d'un refroidissement plus important. De ce fait, la climatisation, grosse consommatrice d'énergie, n'est plus nécessaire.

Il reste cependant à alimenter les serveurs eux-mêmes, bien qu'optimisés sur le plan de la consommation énergétique. Le produit de Datacloud utilise pour cela des éoliennes positionnées sur de vastes ailes, des plaques solaires en silicone cristallisé et, enfin, des piles à combustibles à base alcoolique qui se rechargent par les autres alimentations et assurent en fait surtout l'uniformisation de la production électrique.

Encore expérimental, le dirigeable de Datacloud n'a pas de prix publié à ce jour.

Photo D.R. (...)

Intel Nehalem-EX : Cap sur la performance et la haute disponibilité

Attendues depuis plusieurs semaines, les puces Intel Xeon Nehalem-EX - avec quatre, six ou huit coeurs - vont permettre aux infrastructures informatiques de passer un cap en matière de performances. Lors d'un entretien, Pascal Lassaigne, directeur du marché entreprises chez Intel France, nous a ainsi expliqué que « jamais le gap d'amélioration n'avait été aussi fort entre deux générations de processeurs. Entre le Xeon 7400, classe Dunnington, et le 7500, sur base Nehalem-EX, les performances sont multipliées en moyenne par 3. Ainsi 100 serveurs monocoeur pourraient être remplacés par 5 machines animées par des Xeon 7500 huit coeurs et dans le cas où ces solutions monocore seraient remplacées par 100 unités Nehalem-EX, les performances seraient multipliées par 20. » Un benchmark réalisé par nos confrères d'InfoWorld a ainsi mis en test un Dell R810 équipé de deux puces Intel X7560 cadencées à 2,26 GHz avec 12 Mo de mémoire cache niveau 3 face à un HP équipé de quatre processeurs X7350 à 2,93 GHz avec 4 Mo de cache. Précisons encore que les Nehalem-EX supportent l'HyperThreading et que les tests ont été réalisés plusieurs fois avec et sans cette fonction. Sans surprise, le serveur Dell a surclassé la précédente génération de puces Intel et même une machine équipée de 4 Opteron 8435 (Istanbul), soit un total de 24 coeurs à 2,6 GHz. Une confrontation avec le dernier née d'AMD, l'Opteron 6100 Magny-Cours est également prévue.

Illustration Dell R810

[[page]]

Pour le lancement de cette plate-forme, Intel insiste particulièrement sur deux points : consolidation des datacenter et réduction de la consommation électrique. Destinés aux serveurs haut de gamme qui nécessitent une grande disponibilité et la capacité d'exécuter des applications critiques comme les bases de données ou des outils d'analyse décisionnelle en temps réel, les serveurs Nehalem-EX arrivent également sur le marché du calcul de haute performance avec des systèmes combinant jusqu'à 256 noeuds. Bull et SGI devraient bientôt présentés des machines de ce type.

« Les processeurs Nehalem-EX devraient aussi inclure un certain nombre de sécurité, de fonctions dédiés à la fiabilité et des améliorations dans la gestion de la mémoire par rapport à la génération précédente » poursuit Pascal Lassaigne d'Intel. Le fondeur de Santa Clara fournit sa plate-forme avec quatre canaux de mémoire pour alimenter les huit coeurs ce qui le met enfin à égalité avec l'Opteron 6100 12 coeurs d'AMD.

One Group Trading, une entreprise de négociation d'options à San Francisco, qui va bientôt recevoir des serveurs Nehalem-EX pour tests, attend un certain nombre de bénéfices avec cette plate-forme. Terence Judkins, DSI de l'entreprise a ainsi témoigné qu'il croyait ce que sera une très bonne mise à jour pour son infrastructure serveurs qui supporte une base de données, des outils d'analyse décisionnelle et des VM. « Les nouveaux serveurs nous permettront de consolider notre groupe de machines et par la même d'économiser l'énergie et les frais de maintenance. Si nous pouvons exécuter avec succès deux tâches sur un seul serveur là où auparavant nous avions besoin de deux machines alors c'est un home run », souligne Terence Judkins.

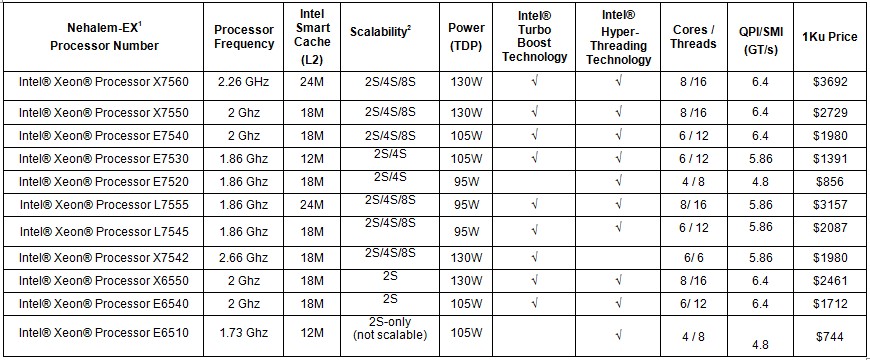

Cliquez pour agrandir le tableau

[[page]]

« Les fonctionnalités améliorées de Nehalem-EX pourrait également favoriser la montée de l'architecture x86 sur un marché dominé par les puces Intel Itanium et les processeurs à jeu d'instruction RISC (IBM PowerPC et Oracle / Sun Sparc) » estime Jim McGregor, responsable de l'analyse technologique chez In-Stat. Pour sa plate-forme Nehalem-EX, Intel a adapté certaines technologies issues de l'architecture IA-64 Itanium, comme le RAS (fiabilité, disponibilité et facilité de maintenance) afin de réduire la corruption des données et d'améliorer la performance générales des systèmes. D'autres technologies comme le MCA sera capable de détecter les erreurs dans le traitement des données en provenance de la CPU ou de mémoire système et de les corriger en travaillant de concert avec le système d'exploitation. « En apportant les caractéristiques RAS sur l'architecture x86, Intel a jeté de nouvelles bases pour les clients désirant quitter les plates-formes Risc » ajoute Jim McGregor. « Les entreprises ont toujours accepté de payer beaucoup plus chers pour bénéficier des avantages des systèmes basés sur l'architecture Risc, mais l'arrivée des Nehalem-EX qui offrent ces fonctionnalités à un prix nettement inférieur va peut-être changer la donne ». Toutefois, certaines entreprises vont continuer à travailler avec leurs plates-formes Risc ou Itanium pour des raisons de rendement, de solutions logicielles et de familiarité, ajoute-il. HP, par exemple, qui propose à la fois des machines x86 Nehalem-EX et des serveurs Integrity NonStop IA-64, continuera à proposer des puces Itanium pour ceux qui veulent des solutions éprouvées. « Toutefois, l'arrivée de la plate-forme Nehalem-EX offre un véritable avantage concurrentiel en terme de prix qui pourrait accélérer la progression de l'architecture x86 dans les systèmes haut de gamme. C'est un point que nul ne contestera» poursuit Jim McGregor.

L'Intel Nehalem-EX entre également en compétition avec le 12 coeurs Opteron 6100 d'AMD, qui contient le plus grand nombre de coeurs de processeur dans un serveur x86, explique Jim McGregor. Cependant, les puces d'AMD ne sont pas encore capables d'offrir les caractéristiques du Nehalem-EX sur le plan de la tolérance de panne. Mais pour les clients qui recherchent avant tout un bon rapport prix-performance, les Magny-Cours sont une très bonne base pour animer des serveurs classiques dans des environnements non critiques, ajoute-il.

Pour conclure signalons que les constructeurs tels que Dell, NEC, Cray, Cisco et IBM vont proposer des serveurs Nehalem-EX. Dell a déjà annoncé le PowerEdge M910, R910 et R810 serveurs, qui sont animé par des processeurs Nehalem EX. Le serveur R810 est offert à partir de 4999 $, le R910 à partir de 7799 $ et le M910 à partir de 4999 $. NEC, de son coté, commence à prendre les commandes pour l'Express5800/A1080a équipé de huit sockets. Le serveur est annoncé à un prix de 53 000 $ avec une carte mère quatre sockets et 128 Go de mémoire.

(...)(31/03/2010 17:27:52)

Le cloud source de pollution majeure selon Greenpeace

« Le cloud progresse dans une période où le climat change et la réduction des émissions de gaz sont des préoccupations essentielles » souligne le rapport « Make IT Green : Cloud Computing and its Contribution to Climate Change » de Greenpeace. Il explique que « l'accroissement de la demande en cloud provoquera aussi un grand besoin en ressources énergétiques ». A la question sur la quantification de ce besoin, Greenpeace avoue qu'il est difficile à évaluer, mais l'association estime que l'électricité consommée par les datacenters et les réseaux de télécommunications, qui sont les bases du cloud, devrait tripler entre 2007 et 2020.

l'iPad, concentré de cloud

Les grandes sociétés de l'Internet tentent d'améliorer leur efficience énergétique, leur permettant de réduire leur coût opérationnel. Mais Greenpeace souligne qu'elles privilégient le développement de datacenter, là où cela fait du sens, sans se préoccuper des questions énergétiques. Le rapport prend comme point de départ une mise à jour d'un travail sur l'iPad d'Apple, car l'association estime que ce terminal constitue un concentré des usages futurs (téléchargement de vidéos, livres, musiques) basés sur les services de type cloud.

[[page]]

Plusieurs sociétés concentrent l'ire de Greenpeace. Récemment, une campagne a été menée contre Facebook, sur sa décision de construire un datacenter à Prineville dans l'Oregon, tirant son énergie d'une centrale électrique au charbon. Le réseau social considère que le climat de l'Oregon est suffisant pour permettre une climatisation naturelle de ses équipements et n'a jamais favorisé l'utilisation du charbon. Bon point par contre pour Yahoo, qui utilise l'énergie hydroélectrique pour son datacenter dans la banlieue de Buffalo dans l'état de New York. Google et Microsoft travaillent eux sur des datacenters plus respectueux de l'environnement et investissent aussi dans l'éducation des gens en la matière. En 2009, Google, qui produit et commercialise de l'électricité, a proposé 3,7 milliards de dollars sur un plan de 20 ans pour réduire la dépendance énergétique américaine.

Vers des clouds plus vert..ueux

Néanmoins, Greenpeace souhaite que les entreprises Internet évoluent vers l'utilisation d'énergies renouvelables. « Si les fournisseurs de cloud veulent véritablement fournir un service vert, ils doivent orienter leurs investissements vers ces sources d'énergies alternatives, mais aussi s'impliquer davantage dans le débat politique sur ces sujets pour permettre le déploiement rapide de production électrique plus économique et d'accorder une place plus grande dans la R&D sur les systèmes de stockage qui délivrent de l'électricité en continu » (...)

| < Les 10 documents précédents | Les 10 documents suivants > |